Quatorze années d'expérience approfondie dans le secteur, conscients du prochain raz-de-marée, nous devons aller de l'avant. Cet article vise à explorer, en réfléchissant à l'entreprise, les tendances technologiques et applicatives à l'ère de l'IA, en restant fidèles à nos valeurs internes et en recherchant l'excellence grâce aux idées externes.

Le tournant technologique : un jeu d’efficacité entre la puissance de calcul, les algorithmes et les données

Avec l'évolution rapide des grands modèles, l'humanité s'est engagée sur la voie rapide vers l'intelligence artificielle surhumaine (ASI). La maturité des technologies de Big Data fournit à l'IA d'immenses facteurs de production, le développement de la technologie GPU libère la productivité de l'IA, et les innovations algorithmiques permettent à l'IA de surmonter les goulots d'étranglement de la puissance de calcul et des données. Avec les progrès constants des grands modèles de langage tels que DeepSeek, GPT o1 et Grok en termes d'algorithmes de modèles, de paramètres d'entraînement et d'accumulation de puissance de calcul, nous sommes arrivés à un carrefour du développement technologique de l'IA : un jeu d'efficacité entre la puissance de calcul, les algorithmes et les données.

Si l'on se réfère à la loi de Moore, le développement de la puissance de calcul atteindra le plus tôt possible le plafond d'efficacité énergétique. L'ère des grands modèles de base reposant sur l'accumulation de puissance de calcul touchera bientôt à sa fin. Il ne s'agit pas d'un « discours sur l'inefficacité de la puissance de calcul », un plus grand nombre de paramètres et de puissance de calcul signifie forcément de meilleurs résultats de modèle, mais la diminution des rendements marginaux entraînera une stabilisation des investissements dans le développement technologique en termes de puissance de calcul. Cela est clairement illustré par l'évolution actuelle des produits des géants de l'IA : avec le lancement de xAI Grok, l'amélioration des performances apportée par l'accumulation de puissance de calcul montre des signes de fatigue, et OpenAI et d'autres géants de l'IA ont commencé à explorer des domaines d'application tels que les agents IA, lançant des produits d'agents intelligents.

Les données synthétiques et les données privées sont les prochaines percées en matière de données pour la prochaine génération de grands modèles. Bien que nous soyons à l'ère de l'explosion des données, grâce aux progrès spectaculaires de l'efficacité du traitement des données obtenus grâce aux technologies de Big Data et aux percées algorithmiques, le développement de l'IA est confronté à un problème d'épuisement des données. Dès les débuts de ChatGPT, Sam Altman a averti que « nous sommes à la fin de l'ère actuelle des grands modèles ». Les données de haute qualité conservées dans l'histoire d'Internet ont été presque entièrement épuisées par GPT-3/4. Le nombre de paramètres des grands modèles peut encore augmenter, mais la quantité de données de haute qualité correspondante devient de plus en plus rare, ce qui réduit progressivement les rendements marginaux de l'augmentation du nombre de paramètres.

Les algorithmes sont plus comme un « catalyseur » du développement de l'IA, ils peuvent briser les contraintes de la puissance de calcul et des données, réalisant une évolution non linéaire. Les percées dans le domaine des algorithmes signifient souvent des percées pour les LLM, comme ChatGPT basé sur Transformer et DeepSeek basé sur MoE. Cependant, avec l'augmentation de la complexité des modèles, l'espace d'amélioration des algorithmes se réduit progressivement. On pense généralement que les percées algorithmiques peuvent nécessiter la combinaison de plus de résultats de recherche interdisciplinaires, tels que l'apprentissage profond inspiré des neurosciences et les mécanismes d'attention inspirés des sciences cognitives, mais il est difficile de prédire combien de « moments Transformer » il y aura à l'avenir.

Déclaration de Tongfu Shield : le développement des grands modèles de base tend à se stabiliser dans le jeu d’efficacité entre la puissance de calcul, les algorithmes et les données, devenant une infrastructure solide pour l’ASI ; les ressources technologiques se tournent progressivement vers l’extraction de la valeur des données dans les domaines spécialisés et la mise en œuvre d’agents IA ; le « déploiement des applications » deviendra le thème principal du développement de la prochaine ère de l’IA.

Explosion des applications : la collaboration multi-agents ouvre l’ère des agents

Le développement des agents IA est une évolution des « robots conversationnels » vers les « assistants intelligents ». Le cœur des agents réside dans « l'exécution des tâches », permettant à l'IA de ne pas se limiter à donner des conseils, mais d'exécuter des tâches spécifiques, telles que passer une commande en ligne ou exécuter une transaction. L'évolution des tâches simples vers les tâches complexes nécessite souvent la coopération de différents modèles et de différents agents. Nous définissons ce concept de « collaboration multi-agents » comme InterAgent (IA), qui est une innovation dans l'architecture technologique, mais aussi une restructuration du paradigme d'application industrielle. Nous pensons que l'IA stimulera le développement de l'IA, passant d'une intelligence unique à une coopération de groupe, d'une assistance par des outils à une exécution autonome, devenant le moteur principal de l'explosion totale de l'ère des agents.

Sur le plan technologique, le protocole MCP d'Anthropic permet la connexion de différentes sources de données, de modèles et d'outils, fournissant un protocole standardisé pour la collaboration multi-agents (IA). Le protocole MCP (Model Context Protocol) définit la manière dont les applications et les modèles échangent des informations contextuelles, ce qui rend le développement d'agents plus simple et plus pratique, et rend la collaboration multi-agents plus cohérente et plus efficace. L'écosystème du protocole MCP est encore en phase de construction précoce. Tongfu Shield, en tant que fournisseur de services de système de confiance pour les agents IA, participe activement à la construction de cet écosystème, déploie des serveurs MCP et développe des plugins fonctionnels MCP pour la communauté, contribuant ainsi à l'expansion de l'écosystème de collaboration multi-agents.

Figure 1 : Service de plugin IA MCP de Tongfu Shield

Sur le plan applicatif, avec la maturité progressive des frameworks d'agents tels que Dify et elizaOS, les agents IA deviennent de plus en plus performants dans leur rôle d'« assistant intelligent ». L'arrivée soudaine de Manus a déclenché un débat sur les « agents universels ». D'une part, en tant qu'assistant IA universel, Manus a démontré la capacité à transformer les capacités de raisonnement logique des grands modèles en productivité réelle, avec un énorme potentiel commercial ; d'autre part, étant donné qu'il n'a pas ouvert de canaux de test publics, l'authenticité des innovations technologiques de Manus, ses stratégies marketing et sa capacité réelle de création de valeur sont également sujettes à controverse, en particulier son concept d'« agent universel », qui présente encore des limites dans le contexte des tendances actuelles du développement de l'IA.

Par rapport au récit universel et grandiose de Manus, les plates-formes d'applications d'agents telles que Dify ont déjà des applications concrètes dans de nombreux domaines, grâce à la force de la communauté. Par rapport à un grand modèle universel, un flux de travail exclusif pour des scénarios d'application spécifiques est plus dynamique, cette vitalité provient de l'essence du commerce : la création de valeur. Imaginez une entreprise qui crée un agent IA pour atteindre et vendre aux clients, afin de maximiser les profits, elle utilisera les données de la plus haute qualité et les meilleures expériences d'experts pour former l'agent, et les données privées et le savoir-faire du secteur créeront des barrières à l'information, ce qui rendra ses performances bien meilleures que celles d'un modèle d'agent universel. Imaginez ensuite un marché des agents IA, rassemblant d'excellents agents de tous les domaines (car le marché fournit suffisamment d'incitations aux créateurs d'agents), les agents se font concurrence sur le marché, seuls les agents capables de créer de la valeur peuvent survivre. Les agents performants attireront plus d'utilisateurs, et plus d'utilisateurs fourniront plus de données pour faire progresser davantage les agents, créant ainsi un cycle vertueux.

Figure 2 : Plateforme de plugins IA en chaîne de Tongfu Shield (à gauche), marché des plugins d'agents IA (à droite)

Déclaration de Tongfu Shield : à l’ère des applications de l’IA, l’agent est le cœur de l’application, et la collaboration multi-agents (InterAgent, ou IA) est le cœur de la technologie ; l’assistance à la construction d’infrastructures pour les agents générera d’énormes retours commerciaux, les mots clés étant « domaine vertical », « incitation communautaire » et « plateforme ouverte ».

L’avenir des modèles : les petits modèles ouvrent la voie à un nouveau « test de Turing »

Mustafa Suleyman, cofondateur de DeepMind, propose dans son ouvrage « Le raz-de-marée arrive » un nouveau « test de Turing » pour l'IA : donner 100 000 $ à une IA et voir si elle peut apprendre à effectuer des transactions sur Amazon et gagner finalement 1 000 000 $. Il s'agit d'un concept très intéressant, par rapport à la ligne de base technologique, pour les utilisateurs, ce qui compte le plus pour un agent IA, c'est sa capacité d'action, c'est-à-dire sa capacité de création de valeur. La réussite commerciale est le nouveau « test de Turing », et ce test est spécialement conçu pour les agents. Le développement technologique est souvent motivé par les modèles commerciaux, nous pensons que l'avenir du développement technologique des modèles ira également des grands modèles de base vers des petits modèles de domaine spécialisé plus performants et plus rentables.

D'un point de vue technologique, le cadre technique des petits modèles est déjà mature. Contrairement à la croyance générale, les petits modèles ont en réalité une origine technologique antérieure aux grands modèles de langage, leurs prémisses remontant aux systèmes experts des années 1960, leur idée centrale étant de simuler les capacités de décision des experts humains grâce à une base de connaissances et à un mécanisme de raisonnement. Le cadre MoE (qui a également directement inspiré l'innovation algorithmique de DeepSeek) très populaire vers 2010 est également le cadre de base des modèles experts, qui, grâce à un mécanisme de routage dynamique, attribue les entrées à différents sous-modèles (experts), réduisant ainsi la charge de calcul tout en garantissant les performances, jetant ainsi les bases de la conception modulaire des petits modèles. La maturité des grands modèles permet également d'améliorer la qualité des petits modèles, grâce à des techniques telles que la distillation des connaissances et l'élagage des modèles, les petits modèles peuvent réduire considérablement leur taille tout en maintenant leurs performances.

D'un point de vue commercial, le terrain commercial des petits modèles est déjà bien établi. Les petits modèles ont un excellent rapport coût-efficacité, les coûts de déploiement et d'inférence ne représentent qu'une fraction de ceux des grands modèles, mais combinés à une base de connaissances d'experts, ils peuvent obtenir des performances bien supérieures à celles des grands modèles. Les îlots de données confèrent aux données une valeur commerciale et des barrières concurrentielles plus élevées, avec la maturité de l'application commerciale des petits modèles, les données de haute valeur peuvent réaliser une véritable factorisation des données, offrant aux entreprises de nouveaux modèles commerciaux et des espaces de profit.

Il est à noter que la combinaison de l'identité numérique distribuée et de la technologie des petits modèles peut créer des modèles commerciaux de haute valeur dans l'espace numérique. Grâce aux petits modèles, les données privées de chaque domaine peuvent maximiser leur valeur commerciale, et l'identité numérique du modèle devient la clé de la détermination des droits des données. La technologie d'identité numérique distribuée est actuellement assez mature. Comment permettre à chaque petit modèle, à chaque agent IA, d'avoir une identité fiable, voire un système de compte, dans l'espace numérique est une question clé pour l'exploration et l'innovation des applications commerciales des agents IA.

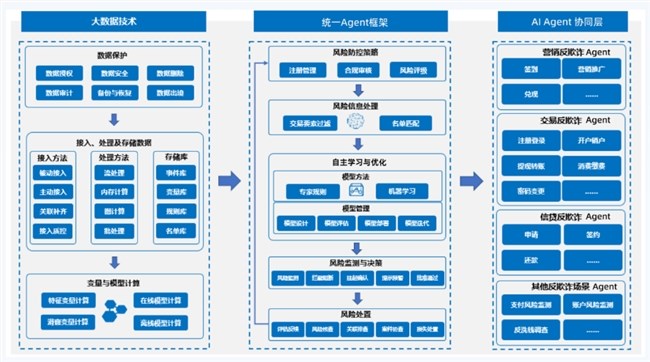

Figure 3 : Matrice de collaboration multi-agents de sécurité des opérations de réseau de Tongfu Shield

Figure 4 : Plateforme de contrôle intelligent des risques des agents IA du secteur bancaire de Tongfu Shield

Déclaration de Tongfu Shield : la réussite commerciale est le nouveau « test de Turing », les petits modèles sont la meilleure voie pour que les agents IA réussissent le nouveau « test de Turing ». Le commerce distribué et l’intelligence distribuée connaîtront également un essor grâce au développement des petits modèles.