Récemment, Meta a discrètement publié six résultats de recherche, apportant de nouvelles applications et des percées technologiques dans le domaine de l'IA. Ces projets incluent des modèles multimodaux, un modèle de génération de musique à partir de texte, une technique de filigrane audio, des ensembles de données, et plus encore. Découvrons ensemble ces résultats de recherche.

Meta Chameleon (modèle « caméléon »)

Tout d'abord, le modèle multimodal « Chameleon » traite simultanément le texte et les images, prenant en charge les entrées et sorties de texte mixtes, offrant ainsi une solution nouvelle pour le traitement des données multimodales.

Alors que la plupart des modèles de fusion postérieure actuels utilisent l'apprentissage basé sur la diffusion, Meta Chameleon utilise la tokenisation pour le texte et les images. Cela permet une approche plus unifiée et rend le modèle plus facile à concevoir, à maintenir et à étendre.

Exemple vidéo : génération d'images avec des titres créatifs ou création d'une scène entièrement nouvelle à l'aide d'un mélange d'invites textuelles et d'images

Actuellement, Meta publie les composants clés des modèles Chameleon 7B et 34B sous licence de recherche. Les modèles actuellement publiés ont été ajustés pour la sécurité, prennent en charge les entrées en mode mixte et les sorties de texte pur, et peuvent être utilisés à des fins de recherche. L'entreprise souligne qu'elle ne publiera pas le modèle de génération d'images de Chameleon.

Accès au produit :https://top.aibase.com/tool/meta-chameleon

Prédiction multi-jetons (Multi-Token Prediction)

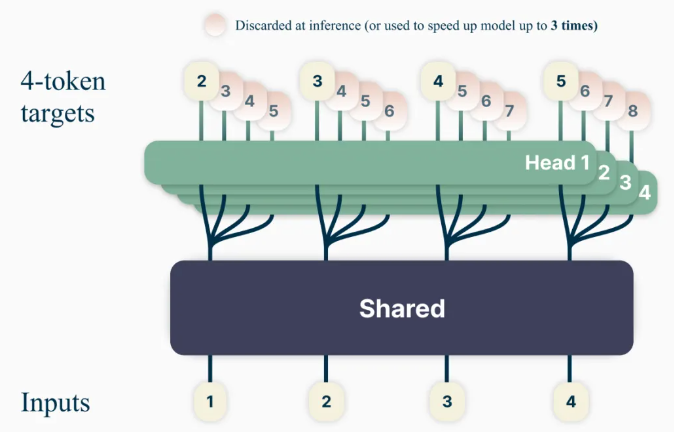

La nouvelle méthode d'entraînement des modèles linguistiques « Multi-Token Prediction » vise à améliorer les capacités et l'efficacité de l'entraînement des modèles, en entraînant les modèles à prédire plusieurs mots à la fois, ce qui améliore la précision des prédictions du modèle.

En utilisant cette méthode, les modèles linguistiques peuvent être entraînés à prédire simultanément plusieurs mots futurs, au lieu de la méthode précédente qui prédisait un mot à la fois. Cela améliore les capacités et l'efficacité de l'entraînement du modèle, tout en augmentant la vitesse. Dans un esprit d'ouverture scientifique responsable, les modèles pré-entraînés seront publiés sous licence non commerciale/à usage de recherche pour l'auto-complétion de code.

Accès au produit :https://top.aibase.com/tool/multi-token-prediction

Modèle de génération de musique à partir de texte « JASCO »

Alors que les modèles actuels de texte à musique (comme MusicGen) s'appuient principalement sur les entrées textuelles pour générer de la musique, le nouveau modèle de Meta, « JASCO » (pour « Joint Audio and Symbolic Conditioning for Time-Controlled Text-to-Music Generation »), peut accepter diverses entrées conditionnelles, telles que des accords ou des rythmes spécifiques, afin d'améliorer le contrôle de la sortie musicale générée. Plus précisément, une couche de goulot d'étranglement d'information peut être combinée à un flou temporel pour extraire les informations relatives à un contrôle spécifique. Cela permet de combiner simultanément des conditions symboliques et basées sur l'audio dans un même modèle de génération de texte à musique.

JASCO offre une qualité de génération comparable aux références d'évaluation, tout en permettant un contrôle plus précis et plus flexible de la musique générée. L'entreprise publiera un article de recherche et une page d'exemples. Le code d'inférence sera publié plus tard ce mois-ci sous licence MIT dans le cadre du dépôt AudioCraft, et les modèles pré-entraînés seront publiés sous licence CC-BY-NC.

Accès au code :https://top.aibase.com/tool/audiocraft

Technique de filigrane audio « AudioSeal »

Il s'agit de la première technique de filigrane audio spécialement conçue pour la détection locale de la parole générée par l'IA, permettant de localiser précisément les segments générés par l'IA dans de longs segments audio. AudioSeal améliore les filigranes audio traditionnels en se concentrant sur la détection du contenu généré par l'IA plutôt que sur la stéganographie.

Contrairement aux méthodes traditionnelles qui reposent sur des algorithmes de décodage complexes, l'approche de détection locale d'AudioSeal permet une détection plus rapide et plus efficace. Cette conception améliore la vitesse de détection de 485 fois par rapport aux méthodes précédentes, la rendant idéale pour les applications à grande échelle et en temps réel. Notre méthode atteint des performances de pointe en termes de robustesse et d'imperceptibilité des filigranes audio.

AudioSeal est publié sous licence commerciale.

Accès au produit :https://top.aibase.com/tool/audioseal

Ensemble de données PRISM

Parallèlement, Meta a publié l'ensemble de données PRISM, développé en collaboration avec des partenaires externes. Il contient des données de conversation et des préférences de 1 500 participants dans le monde entier, utilisées pour améliorer les grands modèles linguistiques, augmentant ainsi la diversité des conversations, la diversité des préférences et les avantages sociaux du modèle.

Cet ensemble de données mappe les préférences et les retours détaillés de chaque personne à 8 011 conversations en temps réel avec 21 LLM différents.

Accès à l'ensemble de données : https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

Indicateur « DIG In »

Utilisé pour évaluer les différences géographiques présentes dans les modèles de génération d'images à partir de texte, fournissant davantage de données de référence pour l'amélioration des modèles. Pour comprendre comment les perceptions de la représentation géographique diffèrent selon les régions, Meta a mené une étude d'annotation à grande échelle. Nous avons collecté plus de 65 000 annotations et plus de 20 réponses à des enquêtes pour chaque exemple, couvrant l'attrait, la similarité, la cohérence et les suggestions partagées, afin d'améliorer l'évaluation automatique et manuelle des modèles de texte à image.

Accès au code :https://top.aibase.com/tool/dig-in

La publication de ces projets apporte de nouvelles avancées technologiques et perspectives d'application dans le domaine de l'IA, jouant un rôle important dans le développement et l'application des technologies d'IA.