Une étude menée par Google DeepMind sur les utilisations malveillantes les plus courantes de l'IA révèle que les « deepfakes », des intelligences artificielles (IA) générant de faux politiciens et célébrités, sont plus répandues que les tentatives d'attaques informatiques assistées par l'IA. Cette recherche, fruit d'une collaboration entre DeepMind, la branche IA de Google, et Jigsaw, une unité de recherche et développement de Google, vise à quantifier les risques liés aux outils d'IA générative mis sur le marché par les plus grandes entreprises technologiques mondiales en quête de profits importants.

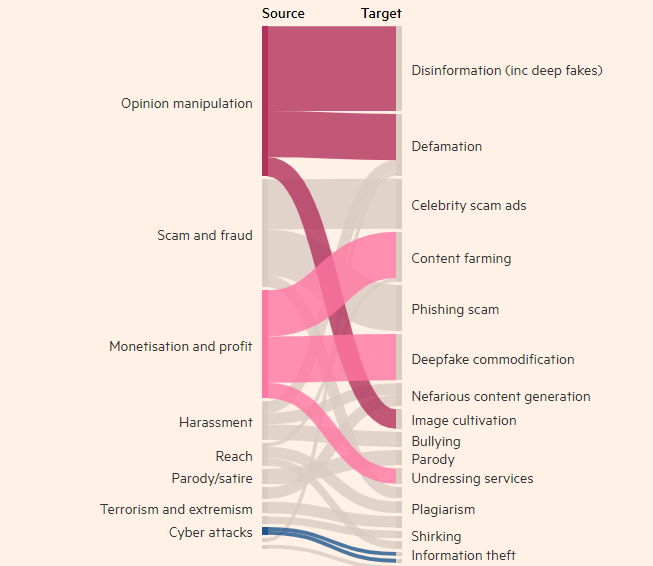

Les motivations des acteurs malveillants liés à la technologie

L'étude révèle que la création d'images, de vidéos et d'audios réalistes mais falsifiés est de loin l'utilisation la plus fréquente des outils d'IA générative, presque deux fois plus que l'utilisation de l'IA pour créer de fausses informations avec des outils textuels (comme les chatbots). L'objectif le plus courant de la mauvaise utilisation de l'IA générative est d'influencer l'opinion publique, ce qui représente 27 % des cas, soulevant des inquiétudes quant à l'impact des deepfakes sur les élections mondiales de cette année.

Ces derniers mois, des deepfakes du Premier ministre britannique Rishi Sunak et d'autres dirigeants mondiaux ont circulé sur TikTok, X et Instagram. Les électeurs britanniques voteront lors des élections générales de la semaine prochaine. Bien que les plateformes de médias sociaux s'efforcent de signaler ou de supprimer ce type de contenu, il est possible que les utilisateurs ne reconnaissent pas sa nature fallacieuse, et la diffusion de ce contenu pourrait influencer le vote des électeurs. Les chercheurs de DeepMind ont analysé environ 200 cas d'utilisation abusive, provenant des plateformes de médias sociaux X et Reddit, ainsi que de blogs en ligne et de reportages médiatiques sur ces abus.

L'étude a révélé que la deuxième motivation principale de la mauvaise utilisation des produits d'IA générative (tels que ChatGPT d'OpenAI et Gemini de Google) est le profit, qu'il s'agisse de fournir des services de création de deepfakes ou d'utiliser l'IA générative pour créer un volume important de contenu, comme de faux articles d'actualité. L'étude a constaté que la plupart des utilisations abusives utilisent des outils facilement accessibles et « nécessitant un minimum de compétences techniques », ce qui signifie qu'un plus grand nombre d'acteurs malveillants peuvent abuser de l'IA générative.

L'étude de DeepMind aura un impact sur l'amélioration de la sécurité de ses modèles d'évaluation, et l'entreprise espère que cela influencera également la façon dont ses concurrents et autres parties prenantes considèrent les « manifestations de danger ».

Points clés :

- 👉 L'étude de DeepMind révèle que les deepfakes constituent le principal problème lié à la mauvaise utilisation des applications d'intelligence artificielle.

- 👉 L'objectif le plus courant de la mauvaise utilisation des outils d'IA générative est d'influencer l'opinion publique, ce qui représente 27 % des cas.

- 👉 La deuxième motivation principale de la mauvaise utilisation de l'IA générative est le profit, principalement via la fourniture de services de deepfakes et la création de fausses informations.