Récemment, une équipe de Kunlun Wanwei dirigée par Yan Shuicheng en Chine et une équipe de recherche de l'Université technologique de Nanyang à Singapour ont publié un projet nommé Q*, visant à améliorer les capacités de raisonnement des petits modèles. Ce projet diffère d'OpenAI, mais permet aux petits modèles d'atteindre des capacités de raisonnement comparables à celles de modèles dont les paramètres sont des dizaines, voire des centaines de fois plus nombreux.

Les résultats expérimentaux de l'algorithme Q* de l'équipe de recherche sont remarquables : sur l'ensemble de données GSM8K, Q* a permis à Llama-2-7b d'atteindre une précision de 80,8 %, surpassant ChatGPT.

Sur l'ensemble de données MATH, Q* a permis à DeepSeek-Math-7b d'atteindre une précision de 55,4 %, surpassant Gemini Ultra.

Sur l'ensemble de données MBPP, Q* a permis à CodeQwen1.5-7b-Chat d'atteindre une précision de 77,0 %, réduisant l'écart de niveau de programmation avec GPT-4. Ces résultats montrent le potentiel de l'algorithme Q* pour améliorer les capacités de raisonnement des petits modèles.

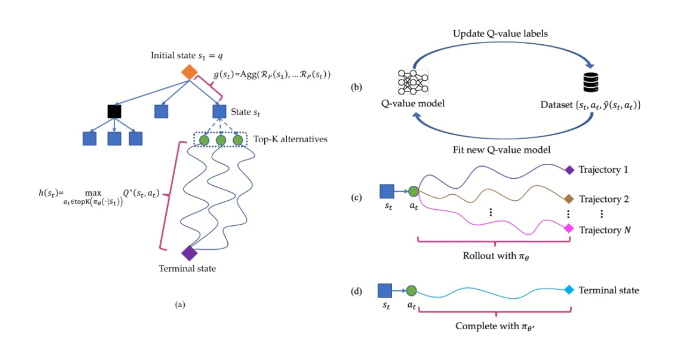

Le principe de l'algorithme Q* consiste à décomposer les trajectoires de raisonnement des grands modèles de langage en plusieurs états, à planifier chaque état globalement et à utiliser l'algorithme de recherche A* pour rechercher de manière prioritaire les tâches de raisonnement complexes. Simultanément, ils ont entraîné un modèle de valeur Q proxy par apprentissage supervisé afin d'obtenir la valeur Q optimale des paires état-action, améliorant ainsi les performances du modèle.

Points clés :

🔍 Le projet Q* n'est pas publié par OpenAI. Grâce à l'algorithme de l'équipe de recherche, les capacités de raisonnement des petits modèles ont été considérablement améliorées.

🔍 Ce projet a obtenu des résultats expérimentaux significatifs sur plusieurs ensembles de données, démontrant le potentiel et l'efficacité de l'algorithme Q*.

🔍 Lien de l'article : https://arxiv.org/abs/2406.14283