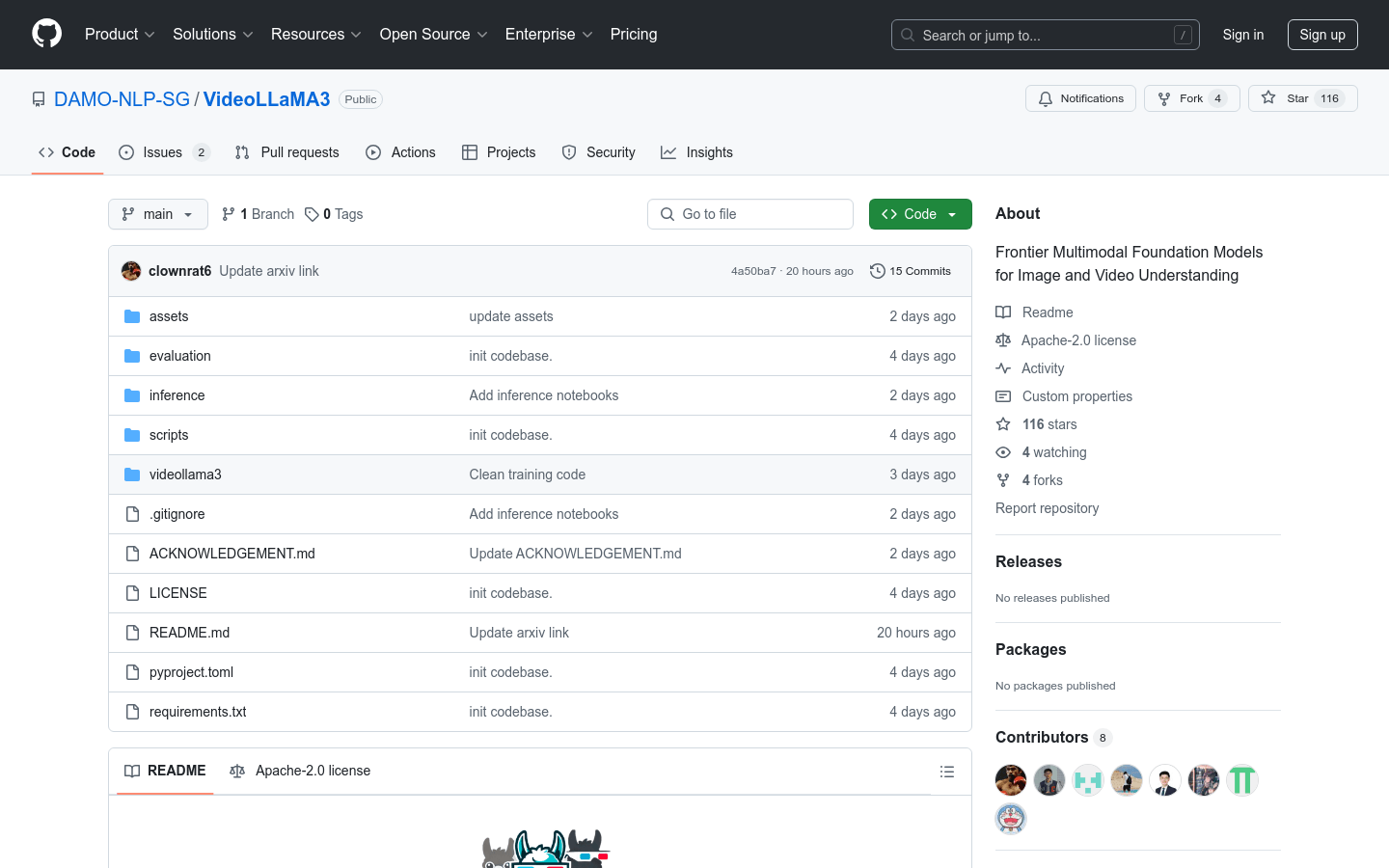

VideoLLaMA3

VideoLLaMA3 est un modèle de base multimodal de pointe, spécialisé dans la compréhension des images et des vidéos.

VideoLLaMA3 Dernière situation du trafic

Nombre total de visites mensuelles

521149929

Taux de rebond

35.96%

Nombre moyen de pages par visite

6.1

Durée moyenne de la visite

00:06:29