फ्रांस का स्वतंत्र गैर-लाभकारी एआई अनुसंधान प्रयोगशाला Kyutai ने एक वॉयस असिस्टेंट Moshi लॉन्च किया है, जो एक क्रांतिकारी वास्तविक समय का मूल बहु-मोडल आधार मॉडल है। यह नवोन्मेषी मॉडल कुछ कार्यों में OpenAI द्वारा मई में पेश किए गए GPT-4o के प्रदर्शन को अनुकरण और पार कर जाता है।

उत्पाद का प्रवेश द्वार:https://top.aibase.com/tool/moshi-chat

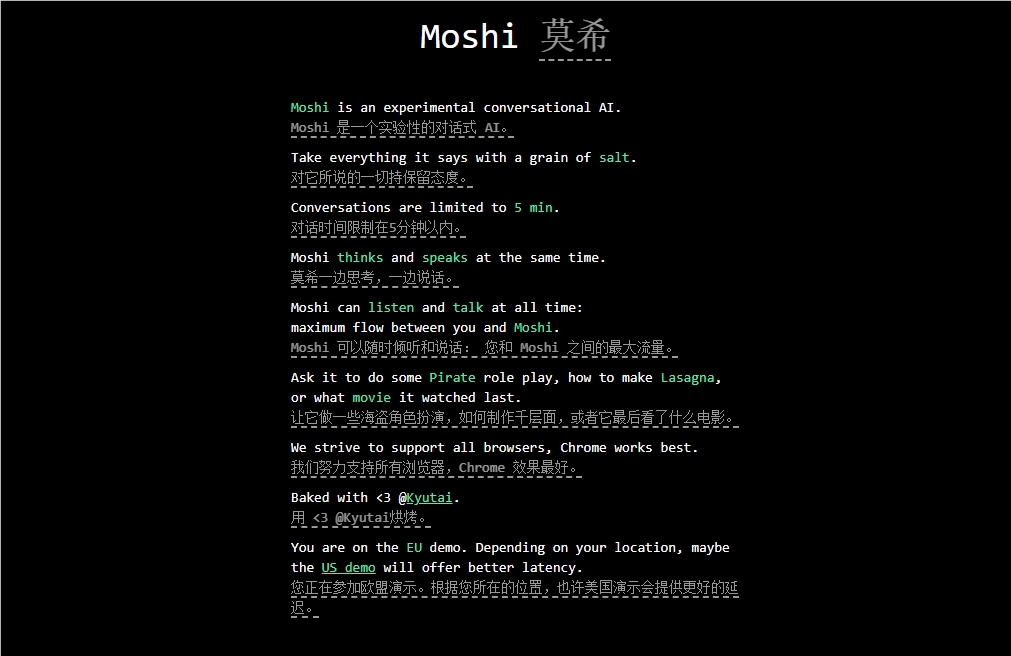

Moshi भावनाओं को समझने और व्यक्त करने के लिए डिज़ाइन किया गया है, और इसमें विभिन्न लहजों (फ्रेंच सहित) में संवाद करने की क्षमता है। यह एक साथ सुनने और ऑडियो और वॉयस उत्पन्न करने में सक्षम है, और पाठ विचार की प्रवाहिता को बनाए रखता है। बताया गया है कि Moshi में मानव जैसी कई भावनाएं हैं, जो 70 प्रकार की भावनाओं और शैलियों में बोलने में सक्षम है।

Moshi की एक प्रमुख विशेषता यह है कि यह दो ऑडियो धाराओं को एक साथ संभाल सकती है, जिससे यह एक साथ सुनने और बोलने में सक्षम है। यह वास्तविक समय की बातचीत पाठ और ऑडियो के मिश्रण के संयुक्त पूर्व-प्रशिक्षण पर आधारित है, जो Kyutai द्वारा विकसित 70 अरब पैरामीटर भाषा मॉडल Helium के संश्लेषित पाठ डेटा का उपयोग करता है।

Moshi की फाइन-ट्यूनिंग प्रक्रिया में 100,000 "बोलचाल शैली" संश्लेषित संवादों को टेक्स्ट-टू-स्पीच (TTS) तकनीक के माध्यम से परिवर्तित किया गया। इस मॉडल की आवाज़ को एक अन्य TTS मॉडल द्वारा उत्पन्न संश्लेषित डेटा के माध्यम से प्रशिक्षित किया गया, जिससे 200 मिलीसेकंड की आश्चर्यजनक एंड-टू-एंड विलंबता प्राप्त हुई।

यह ध्यान देने योग्य है कि Kyutai ने Moshi का एक छोटा संस्करण भी विकसित किया है, जो MacBook या उपभोक्ता स्तर के GPU पर चलाया जा सकता है, जिससे अधिक व्यापक उपयोगकर्ताओं को इसका उपयोग करने की अनुमति मिलती है।

मुख्य बिंदु: 🔍 Kyutai ने Moshi लॉन्च किया, एक वास्तविक समय का मूल बहु-मोडल आधार एआई मॉडल।

🔍 Moshi में भावनाओं को समझने और व्यक्त करने की क्षमता है, जो कई लहजों का समर्थन करता है।

🔍 यह मॉडल कठोर फाइन-ट्यूनिंग और प्रशिक्षण से गुजरा है, जो प्रभावी प्रदर्शन और विविध अनुप्रयोग क्षमता को प्रदर्शित करता है।