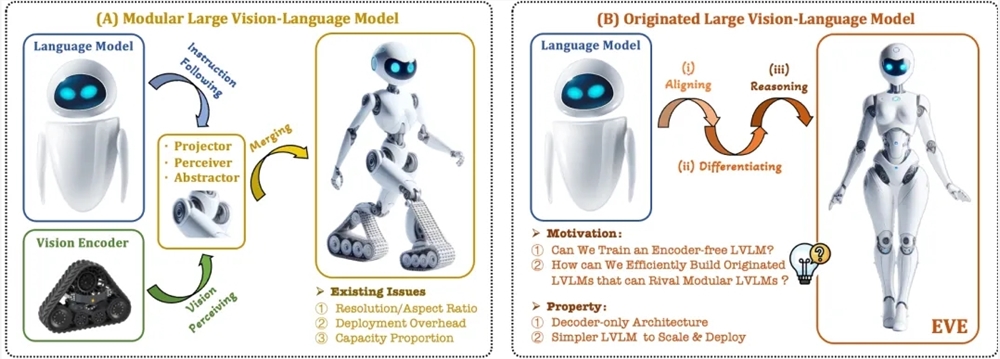

हाल ही में, मल्टी-मॉडल बड़े मॉडल के अनुसंधान और अनुप्रयोगों में महत्वपूर्ण प्रगति हुई है। विदेशी कंपनियों जैसे OpenAI, Google, Microsoft आदि ने कई उन्नत मॉडल पेश किए हैं, जबकि घरेलू संस्थाएँ जैसे Zhipu AI, Jieti Xingchen ने भी इस क्षेत्र में सफलता प्राप्त की है। ये मॉडल आमतौर पर दृश्य एन्कोडर पर निर्भर करते हैं ताकि दृश्य विशेषताओं को निकाला जा सके और बड़े भाषा मॉडल के साथ मिलाया जा सके, लेकिन प्रशिक्षण विभाजन के कारण दृश्य अनुक्रम पूर्वाग्रह की समस्या होती है, जो मल्टी-मॉडल बड़े मॉडल की तैनाती की दक्षता और प्रदर्शन को सीमित करती है।

इन समस्याओं को हल करने के लिए, Zhiyuan अनुसंधान संस्थान ने Dalian University of Technology, Peking University और अन्य उच्च शिक्षा संस्थानों के साथ मिलकर नई पीढ़ी का बिना एन्कोडर वाला दृश्य भाषा मॉडल EVE पेश किया है। EVE ने बारीकी से प्रशिक्षण रणनीतियों और अतिरिक्त दृश्य पर्यवेक्षण के माध्यम से दृश्य-भाषा प्रतिनिधित्व, संरेखण और तर्क को एक एकीकृत शुद्ध डिकोडर आर्किटेक्चर में समाहित किया है। सार्वजनिक डेटा का उपयोग करते हुए, EVE ने कई दृश्य-भाषा बेंचमार्क परीक्षणों में उत्कृष्ट प्रदर्शन किया, जो एन्कोडर-आधारित मुख्यधारा के मल्टी-मॉडल तरीकों के निकट या उनसे बेहतर है।

EVE की मुख्य विशेषताएँ शामिल हैं:

स्वदेशी दृश्य भाषा मॉडल: दृश्य एन्कोडर को हटाकर, किसी भी छवि के अनुपात को संभालता है, और समान प्रकार के Fuyu-8B मॉडल से काफी बेहतर है।

कम डेटा और प्रशिक्षण लागत: पूर्व-प्रशिक्षण के लिए OpenImages, SAM और LAION जैसे सार्वजनिक डेटा का उपयोग किया जाता है, प्रशिक्षण समय कम होता है।

पारदर्शी और प्रभावी अन्वेषण: शुद्ध डिकोडर के स्वदेशी मल्टी-मॉडल आर्किटेक्चर के लिए एक प्रभावी, पारदर्शी विकास पथ प्रदान करता है।

मॉडल संरचना:

पैच एम्बेडिंग परत: एकल परत समुच्चय और औसत पूलिंग परत के माध्यम से छवि 2D विशेषता मानचित्र प्राप्त करता है, स्थानीय विशेषताओं और वैश्विक जानकारी को बढ़ाता है।

पैच संरेखण परत: कई परतों के नेटवर्क दृश्य विशेषताओं को एकीकृत करता है, जो दृश्य एन्कोडर के आउटपुट के साथ सूक्ष्म संरेखण को प्राप्त करता है।

प्रशिक्षण रणनीति:

बड़े भाषा मॉडल द्वारा मार्गदर्शित पूर्व-प्रशिक्षण चरण: दृश्य और भाषा के बीच प्रारंभिक संबंध स्थापित करना।

जनरेटिव पूर्व-प्रशिक्षण चरण: दृश्य-भाषा सामग्री की समझ में मॉडल की क्षमता को बढ़ाना।

पर्यवेक्षित माइक्रो-फाइन-ट्यूनिंग चरण: मॉडल को भाषा निर्देशों का पालन करने और संवाद पैटर्न सीखने की क्षमता को मानकीकृत करना।

मात्रात्मक विश्लेषण: EVE ने कई दृश्य भाषा बेंचमार्क परीक्षणों में उत्कृष्ट प्रदर्शन किया, जो विभिन्न एन्कोडर-आधारित दृश्य भाषा मॉडलों के समान है। हालांकि विशिष्ट निर्देशों का सही उत्तर देने में चुनौतियाँ हैं, लेकिन प्रभावी प्रशिक्षण रणनीतियों के माध्यम से, EVE ने एन्कोडर-आधारित दृश्य भाषा मॉडलों के समान प्रदर्शन हासिल किया है।

EVE ने बिना एन्कोडर के स्वदेशी दृश्य भाषा मॉडल की क्षमता को प्रदर्शित किया है, भविष्य में प्रदर्शन में और सुधार, बिना एन्कोडर आर्किटेक्चर का अनुकूलन और स्वदेशी मल्टी-मॉडल निर्माण के माध्यम से, मल्टी-मॉडल मॉडल के विकास को आगे बढ़ाने की संभावना है।

पत्रिका का पता: https://arxiv.org/abs/2406.11832

प्रोजेक्ट कोड: https://github.com/baaivision/EVE

मॉडल का पता: https://huggingface.co/BAAI/EVE-7B-HD-v1.0