कृत्रिम बुद्धिमत्ता की दुनिया में, बड़े भाषा मॉडल (LLMs) अपनी उत्कृष्ट प्राकृतिक भाषा प्रसंस्करण क्षमता के लिए प्रसिद्ध हैं। हालाँकि, इन मॉडलों को वास्तविक अनुप्रयोगों में तैनात करने में कई चुनौतियों का सामना करना पड़ता है, मुख्य रूप से उनके अनुमान चरण में उच्च गणना लागत और मेमोरी उपयोग के कारण। इस समस्या को हल करने के लिए, शोधकर्ता LLMs की दक्षता बढ़ाने के तरीकों की खोज कर रहे हैं। हाल ही में, Q-Sparse नामक एक विधि ने व्यापक ध्यान आकर्षित किया है।

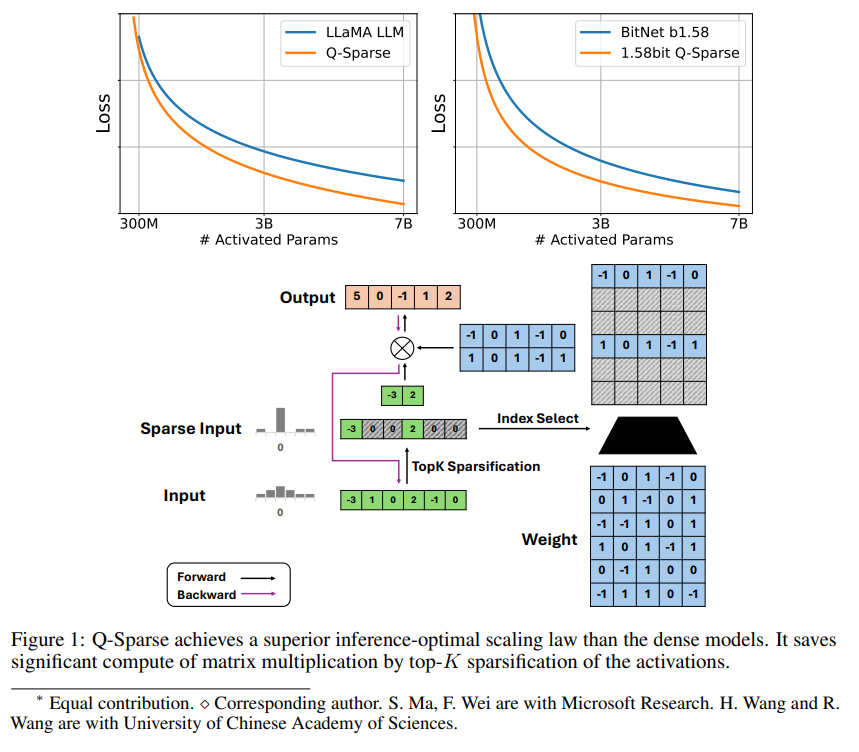

Q-Sparse एक सरल लेकिन प्रभावी विधि है, जो सक्रियण में top-K स्पर्शता और प्रशिक्षण में डायरेक्ट थ्रू अनुमानक को लागू करके LLMs की पूर्ण स्पर्शता को प्राप्त करती है। इसका मतलब है कि अनुमान के दौरान दक्षता में काफी सुधार हो सकता है। महत्वपूर्ण शोध निष्कर्षों में शामिल हैं:

Q-Sparse ने आधारभूत LLMs के समान परिणामों को बनाए रखते हुए अनुमान की दक्षता को अधिकतम किया है।

स्पर्श सक्रियण LLMs के लिए एक अनुकूलित अनुमान विस्तार नियम पेश किया गया।

Q-Sparse विभिन्न सेटिंग्स में प्रभावी है, जिसमें प्रारंभ से प्रशिक्षण, मौजूदा LLMs का निरंतर प्रशिक्षण और सूक्ष्म समायोजन शामिल हैं।

Q-Sparse पूर्ण सटीकता और 1-बिट LLMs (जैसे BitNet b1.58) के लिए उपयुक्त है।

स्पर्श सक्रियण के लाभ

स्पर्शता LLMs की दक्षता को दो तरीकों से बढ़ाती है: पहले, स्पर्शता मैट्रिक्स गुणन की गणना को कम कर सकती है, क्योंकि शून्य तत्वों की गणना नहीं की जाती; दूसरे, स्पर्शता इनपुट/आउटपुट (I/O) के ट्रांसफर की मात्रा को कम कर सकती है, जो LLMs के अनुमान चरण की मुख्य बाधा है।

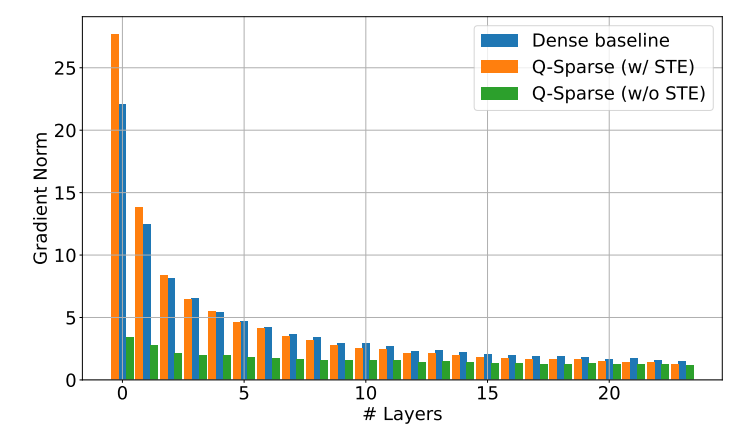

Q-Sparse प्रत्येक रेखीय प्रक्षिप्ति में top-K स्पर्शता कार्य को लागू करके सक्रियण की पूर्ण स्पर्शता को प्राप्त करता है। प्रतिगामी प्रसार के लिए, सक्रियण के ग्रेडिएंट की गणना के लिए डायरेक्ट थ्रू अनुमानक का उपयोग किया जाता है। इसके अतिरिक्त, सक्रियण की स्पर्शता को और बढ़ाने के लिए वर्ग ReLU कार्य को पेश किया गया है।

प्रयोगात्मक सत्यापन

शोधकर्ताओं ने स्पर्श सक्रियण LLMs के विस्तार नियम का अध्ययन करने के लिए कई विस्तारित प्रयोग किए और कुछ दिलचस्प निष्कर्ष निकाले:

स्पर्श सक्रियण मॉडल की प्रदर्शन क्षमता मॉडल के आकार और स्पर्श अनुपात के बढ़ने के साथ बढ़ती है।

एक निश्चित स्पर्श अनुपात S को ध्यान में रखते हुए, स्पर्श सक्रियण मॉडल की प्रदर्शन क्षमता मॉडल के आकार N के साथ शक्ति नियम विस्तार नियम का पालन करती है।

एक निश्चित पैरामीटर N के साथ, स्पर्श सक्रियण मॉडल की प्रदर्शन क्षमता स्पर्श अनुपात S के साथ指数 नियम विस्तार नियम का पालन करती है।

Q-Sparse का उपयोग न केवल प्रारंभ से प्रशिक्षण के लिए किया जा सकता है, बल्कि मौजूदा LLMs के निरंतर प्रशिक्षण और सूक्ष्म समायोजन के लिए भी किया जा सकता है। निरंतर प्रशिक्षण और सूक्ष्म समायोजन सेटिंग्स में, शोधकर्ताओं ने प्रारंभ से प्रशिक्षण के समान संरचना और प्रशिक्षण प्रक्रिया का उपयोग किया, एकमात्र अंतर यह है कि उन्होंने पूर्व-प्रशिक्षित वजन के साथ मॉडल को प्रारंभ किया और स्पर्श कार्य को निरंतर प्रशिक्षण के लिए सक्षम किया।

शोधकर्ता Q-Sparse को 1-बिट LLMs (जैसे BitNet b1.58) और मिश्रित विशेषज्ञता (MoE) के साथ संयोजन करने की खोज कर रहे हैं, ताकि LLMs की दक्षता को और बढ़ाया जा सके। इसके अलावा, वे Q-Sparse को बैच मोड के साथ संगत बनाने के लिए भी प्रयासरत हैं, जो LLMs के प्रशिक्षण और अनुमान को और अधिक लचीलापन प्रदान करेगा।