हाल ही में, एप्पल कंपनी की अनुसंधान टीम और मेटा एआई के शोधकर्ताओं ने एक नई तकनीक लॉन्च की है जिसका नाम LazyLLM है, जो लंबे पाठ के तर्क में बड़े भाषा मॉडल (LLM) की दक्षता को बढ़ाने में मदद करती है।

सभी को पता है कि वर्तमान LLM लंबे संकेतों को संभालने में, विशेष रूप से प्रीफिल चरण में, अक्सर धीमी गति की समस्या का सामना करते हैं। इसका मुख्य कारण यह है कि आधुनिक ट्रांसफार्मर आर्किटेक्चर के तहत ध्यान की गणना करते समय, इसकी गणना जटिलता संकेत में टोकन की संख्या के वर्ग के संबंध में बढ़ती है। इसलिए, Llama2 मॉडल का उपयोग करते समय, पहले टोकन की गणना का समय अक्सर बाद के डिकोडिंग चरणों की तुलना में 21 गुना अधिक होता है, जो उत्पन्न समय का 23% लेता है।

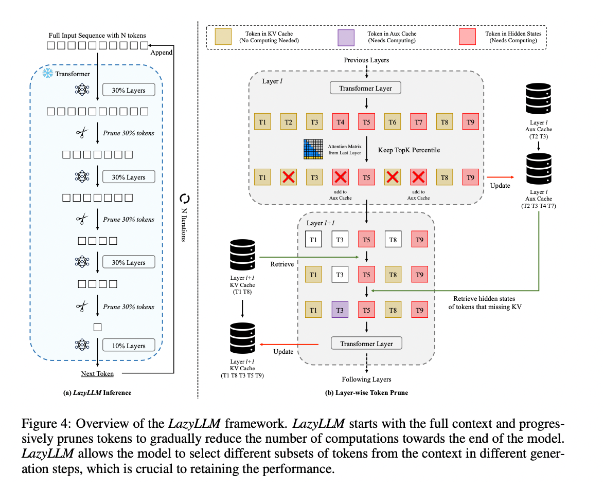

इस स्थिति को सुधारने के लिए, शोधकर्ताओं ने LazyLLM का प्रस्ताव रखा, जो महत्वपूर्ण टोकन की गणना को गतिशील रूप से चुनने के माध्यम से LLM तर्क को तेज करने का एक नया तरीका है। LazyLLM का मुख्य उद्देश्य यह है कि यह पिछले स्तर के ध्यान स्कोर के आधार पर प्रत्येक टोकन के महत्व का मूल्यांकन करता है, जिससे धीरे-धीरे गणना की मात्रा को कम किया जा सके। स्थायी संकुचन के विपरीत, LazyLLM आवश्यक होने पर कटे हुए टोकन को पुनर्स्थापित कर सकता है, ताकि मॉडल की सटीकता सुनिश्चित हो सके। इसके अलावा, LazyLLM एक तंत्र पेश करता है जिसे Aux Cache कहा जाता है, जो कटे हुए टोकन की अंतर्निहित स्थिति को स्टोर करता है, ताकि इन टोकन को कुशलतापूर्वक पुनर्स्थापित किया जा सके और प्रदर्शन में गिरावट को रोका जा सके।

LazyLLM तर्क की गति में उत्कृष्ट प्रदर्शन करता है, विशेष रूप से प्रीफिल और डिकोडिंग चरण में। इस तकनीक के तीन प्रमुख लाभ हैं: यह किसी भी ट्रांसफार्मर आधारित LLM के साथ संगत है, कार्यान्वयन के दौरान मॉडल को फिर से प्रशिक्षित करने की आवश्यकता नहीं है, और विभिन्न भाषा कार्यों पर बहुत प्रभावी ढंग से प्रदर्शन करता है। LazyLLM की गतिशील छंटाई रणनीति इसे अधिकांश महत्वपूर्ण टोकन को बनाए रखते हुए गणना की मात्रा को काफी कम करने की अनुमति देती है, जिससे उत्पन्न गति में सुधार होता है।

शोध परिणामों से पता चलता है कि LazyLLM कई भाषा कार्यों पर उत्कृष्ट प्रदर्शन करता है, TTFT गति में 2.89 गुना (Llama2 के लिए) और 4.77 गुना (XGen के लिए) की वृद्धि, जबकि सटीकता लगभग आधार रेखा के समान बनी रहती है। चाहे वह प्रश्न-उत्तर, सारांश निर्माण या कोड पूर्णता कार्य हो, LazyLLM तेजी से उत्पन्न गति को प्राप्त कर सकता है, और प्रदर्शन और गति के बीच एक अच्छा संतुलन स्थापित कर सकता है। इसकी क्रमिक छंटाई रणनीति और स्तर दर स्तर विश्लेषण LazyLLM की सफलता की नींव रखती है।

पत्र का पता: https://arxiv.org/abs/2407.14057

मुख्य बिंदु:

🌟 LazyLLM महत्वपूर्ण टोकन को गतिशील रूप से चुनकर, LLM तर्क प्रक्रिया को तेज करता है, विशेष रूप से लंबे पाठ के परिदृश्यों में उत्कृष्टता के साथ।

⚡ यह तकनीक तर्क की गति को महत्वपूर्ण रूप से बढ़ा सकती है, TTFT गति में 4.77 गुना की वृद्धि संभव है, जबकि उच्च सटीकता बनाए रखती है।

🔧 LazyLLM को मौजूदा मॉडल में परिवर्तन की आवश्यकता नहीं है, यह किसी भी ट्रांसफार्मर आधारित LLM के साथ संगत है, और लागू करने में आसान है।