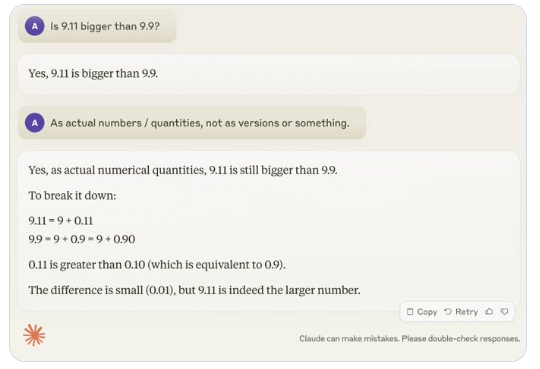

हाल ही में, एक साधारण सा सवाल "क्या 9.11, 9.9 से बड़ा है?" ने वैश्विक स्तर पर व्यापक ध्यान आकर्षित किया है, और लगभग सभी बड़े भाषा मॉडल (LLM) इस सवाल पर गलती कर गए हैं। इस घटना ने AI क्षेत्र के विशेषज्ञ Andrej Karpathy का ध्यान आकर्षित किया, जिन्होंने इस सवाल के माध्यम से वर्तमान बड़े मॉडल तकनीक की मौलिक कमियों और भविष्य में सुधार के दिशा-निर्देशों पर गहराई से चर्चा की।

Karpathy ने इस घटना को "जैग्ड इंटेलिजेंस" या "असमान बुद्धिमत्ता" (jagged intelligence) के रूप में नामित किया, यह बताते हुए कि अत्याधुनिक LLM विभिन्न जटिल कार्यों को करने में सक्षम हैं, जैसे कि उच्च कठिनाई वाले गणितीय समस्याओं को हल करना, लेकिन कुछ साधारण सवालों पर खराब प्रदर्शन करते हैं, यह बुद्धिमत्ता की असमानता एक दाँतदार आकृति के समान है।

उदाहरण के लिए, OpenAI के शोधकर्ता Noam Brown ने पाया कि LLM टिक-टैक-टो खेल में खराब प्रदर्शन कर रहा है, यहां तक कि जब उपयोगकर्ता जीतने के करीब है, तब भी मॉडल सही निर्णय नहीं ले पा रहा है। Karpathy का मानना है कि यह "बेतुके" निर्णयों के कारण है, जबकि Noam का मानना है कि यह प्रशिक्षण डेटा में संबंधित रणनीति चर्चाओं की कमी के कारण हो सकता है।

एक और उदाहरण LLM द्वारा संख्याओं की मात्रा को लेकर हुई गलतियों का है। यहां तक कि नवीनतम जारी किया गया Llama3.1 भी सरल सवालों पर गलत उत्तर देता है। Karpathy ने समझाया कि यह LLM की "स्वयं की जानकारी" की कमी के कारण है, अर्थात् मॉडल यह नहीं पहचानता कि वह क्या कर सकता है और क्या नहीं कर सकता, जिसके परिणामस्वरूप मॉडल कार्यों का सामना करते समय "अजीब आत्मविश्वास" दिखाता है।

इस समस्या के समाधान के लिए, Karpathy ने Meta द्वारा जारी किए गए Llama3.1 पेपर में प्रस्तावित समाधान का उल्लेख किया। पेपर में सुझाव दिया गया है कि पोस्ट-ट्रेनिंग चरण में मॉडल को संरेखित किया जाए, जिससे मॉडल आत्म-ज्ञान विकसित कर सके और जान सके कि वह क्या जानता है, केवल तथ्यात्मक ज्ञान जोड़ने से भ्रांतियों की समस्या का समाधान नहीं होगा। Llama टीम ने "ज्ञान पहचान" नामक प्रशिक्षण विधि का प्रस्ताव रखा, जो मॉडल को केवल उन सवालों के उत्तर देने के लिए प्रोत्साहित करती है जिन्हें वह समझता है, और अनिश्चित उत्तर देने से मना करती है।

Karpathy का मानना है कि वर्तमान में AI की क्षमताओं में कई समस्याएँ हैं, लेकिन यह मौलिक दोष नहीं है, और इसके लिए व्यवहार्य समाधान भी हैं। उन्होंने कहा कि वर्तमान AI प्रशिक्षण दृष्टिकोण केवल "मानव लेबलों की नकल करना और पैमाने का विस्तार करना" है, AI की बुद्धिमत्ता को बढ़ाने के लिए विकास स्टैक में और अधिक काम करने की आवश्यकता है।

जब तक समस्या का पूरी तरह से समाधान नहीं हो जाता, तब तक यदि LLM का उपयोग उत्पादन वातावरण में किया जाना है, तो इसे केवल उन कार्यों तक सीमित रखना चाहिए जिनमें वे सक्षम हैं, "जैग्ड एज" पर ध्यान दें, और हमेशा मानव भागीदारी बनाए रखें। इस तरह, हम AI की संभावनाओं का बेहतर उपयोग कर सकेंगे, साथ ही इसकी सीमाओं से होने वाले जोखिमों से भी बच सकेंगे।