प्राकृतिक भाषा प्रसंस्करण के क्षेत्र में, बड़े भाषा मॉडल (LLMs) का विकास तेजी से हो रहा है और कई क्षेत्रों में महत्वपूर्ण प्रगति हासिल की गई है। हालाँकि, जैसे-जैसे मॉडल की जटिलता बढ़ती है, उनके आउटपुट का सटीक मूल्यांकन करना महत्वपूर्ण हो जाता है। पारंपरिक रूप से, हम मूल्यांकन के लिए मानवों पर निर्भर करते हैं, लेकिन यह तरीका समय-खपत करने वाला और पैमाने पर कठिन है, जो तेजी से विकसित हो रहे मॉडल के साथ नहीं चल सकता।

इस स्थिति को बदलने के लिए, Salesforce AI शोध टीम ने SFR-Judge लॉन्च किया है, जो तीन बड़े भाषा मॉडलों का एक मूल्यांकन परिवार है। इन मॉडलों में क्रमशः 80 अरब, 120 अरब और 700 अरब पैरामीटर हैं, जो Meta Llama3 और Mistral NeMO पर आधारित हैं। SFR-Judge विभिन्न मूल्यांकन कार्यों को निष्पादित कर सकता है, जिसमें जोड़ी तुलना, एकल स्कोरिंग और द्वि-श्रेणी मूल्यांकन शामिल हैं, जिसका उद्देश्य शोध टीमों को नए मॉडलों के प्रदर्शन का तेजी से और प्रभावी ढंग से मूल्यांकन करने में मदद करना है।

पारंपरिक LLM मूल्यांकन मॉडल अक्सर कुछ पूर्वाग्रह समस्याओं का सामना करते हैं, जैसे कि स्थिति पूर्वाग्रह और लंबाई पूर्वाग्रह, जो उनके निर्णयों को प्रभावित कर सकते हैं। इन समस्याओं को हल करने के लिए, SFR-Judge ने प्रत्यक्ष प्राथमिकता अनुकूलन (DPO) प्रशिक्षण विधि अपनाई है, जिससे मॉडल सकारात्मक और नकारात्मक उदाहरणों से सीखता है, जिससे इसकी मूल्यांकन कार्यों की समझ में सुधार होता है, पूर्वाग्रह को कम किया जाता है, और निर्णय की संगति सुनिश्चित की जाती है।

परीक्षणों में, SFR-Judge ने 13 बेंचमार्क परीक्षणों में उत्कृष्ट प्रदर्शन किया, कई मौजूदा मूल्यांकन मॉडलों, जिसमें कुछ निजी मॉडल भी शामिल हैं, को पीछे छोड़ दिया। विशेष रूप से RewardBench लीडरबोर्ड पर, SFR-Judge की सटीकता 92.7% तक पहुंच गई, जो जनरेटिव मूल्यांकन मॉडल के लिए 90% के निशान को पहली और दूसरी बार पार करने का प्रमाण है, जिससे यह मूल्यांकन मॉडलों में अपनी उत्कृष्टता प्रदर्शित करता है।

SFR-Judge की प्रशिक्षण विधि तीन विभिन्न डेटा प्रारूपों को शामिल करती है। सबसे पहले, "विचार श्रृंखला आलोचना", जो मॉडल को मूल्यांकन प्रतिक्रिया का संरचित विश्लेषण उत्पन्न करने में मदद करता है। दूसरा, "मानक मूल्यांकन", जो मूल्यांकन प्रक्रिया को सरल बनाता है और सीधे प्रतिक्रिया देता है कि क्या यह मानकों के अनुरूप है। अंत में, "प्रतिक्रिया व्युत्पत्ति" मॉडल को उच्च गुणवत्ता वाली प्रतिक्रियाओं की विशेषताओं को समझने में मदद करती है, जिससे इसकी निर्णय क्षमता को मजबूत किया जा सके। इन तीन डेटा प्रारूपों का संयोजन SFR-Judge की मूल्यांकन क्षमता को बहुत बढ़ाता है।

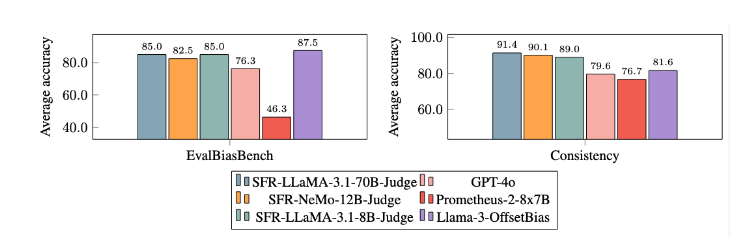

कई प्रयोगों के बाद, SFR-Judge मॉडल ने अन्य मॉडलों की तुलना में पूर्वाग्रह को कम करने में महत्वपूर्ण रूप से बेहतर प्रदर्शन किया है। EvalBiasBench बेंचमार्क परीक्षण में, उन्होंने जोड़ी क्रम में उच्च स्थिरता दिखाई, जो यह दर्शाता है कि भले ही प्रतिक्रिया क्रम बदल जाए, मॉडल का निर्णय फिर भी स्थिर रहता है। यह SFR-Judge को एक विश्वसनीय स्वचालित मूल्यांकन समाधान बनाता है, मानव एनोटेशन पर निर्भरता को कम करता है, और मॉडल मूल्यांकन के लिए अधिक स्केलेबल विकल्प प्रदान करता है।

पत्र प्रवेश: https://arxiv.org/abs/2409.14664

महत्वपूर्ण बिंदु:

📊 उच्च सटीकता: SFR-Judge ने 13 बेंचमार्क परीक्षणों में 10 सर्वश्रेष्ठ परिणाम प्राप्त किए, विशेष रूप से RewardBench पर 92.7% की उच्च सटीकता हासिल की।

🛡️ पूर्वाग्रह कम करना: इस मॉडल ने अन्य मूल्यांकन मॉडलों की तुलना में कम पूर्वाग्रह प्रदर्शित किया, विशेष रूप से लंबाई और स्थिति पूर्वाग्रह के मामले में।

🔧 बहुपरकारी अनुप्रयोग: SFR-Judge जोड़ी तुलना, एकल स्कोरिंग और द्वि-श्रेणी मूल्यांकन का समर्थन करता है, जो विभिन्न मूल्यांकन परिदृश्यों के लिए अनुकूल है।