हाल ही में, गूगल ने "gemma-2-2b-jpn-it" नामक एक नए मॉडल की घोषणा की है, जो इसके Gemma श्रृंखला के भाषा मॉडल का नवीनतम सदस्य है। यह मॉडल विशेष रूप से जापानी भाषा के लिए अनुकूलित किया गया है, जो गूगल की बड़े भाषा मॉडल (LLM) के क्षेत्र में निरंतर निवेश की प्रतिबद्धता को दर्शाता है।

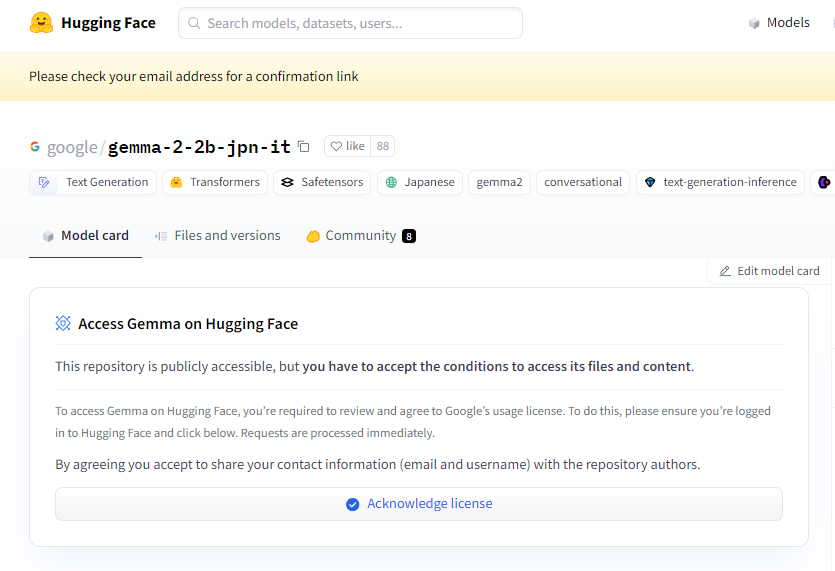

प्रोजेक्ट का लिंक: https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it एक टेक्स्ट-टू-टेक्स्ट डिकोडर प्रकार का बड़ा भाषा मॉडल है, जिसमें ओपन वेट्स हैं, जिसका अर्थ है कि यह सार्वजनिक रूप से उपलब्ध है और विभिन्न टेक्स्ट जनरेशन कार्यों के लिए इसे बारीकी से ट्यून किया जा सकता है, जैसे कि प्रश्न-उत्तर, सारांश और तर्क आदि।

इस नए मॉडल में 26.1 अरब पैरामीटर हैं और यह BF16 टेन्सर प्रकार का उपयोग करता है। यह गूगल के जेमिनी श्रृंखला मॉडल आर्किटेक्चर पर आधारित है, जिसमें अत्याधुनिक तकनीकी दस्तावेज और संसाधन शामिल हैं, जिससे डेवलपर्स इसे विभिन्न अनुप्रयोगों में एकीकृत करने के लिए आसानी से उपयोग कर सकते हैं। उल्लेखनीय है कि यह मॉडल गूगल के नवीनतम TPU हार्डवेयर, विशेष रूप से TPUv5p के साथ संगत है। यह हार्डवेयर शक्तिशाली गणना क्षमता प्रदान करता है, जिससे मॉडल के प्रशिक्षण की गति अधिक होती है और प्रदर्शन बेहतर होता है, जो पारंपरिक CPU बुनियादी ढांचे से कहीं अधिक है।

सॉफ़्टवेयर के मामले में, gemma-2-2b-jpn-it को प्रशिक्षण के लिए JAX और ML Pathways ढांचे का उपयोग किया गया है। JAX विशेष रूप से उच्च प्रदर्शन मशीन लर्निंग अनुप्रयोगों के लिए अनुकूलित किया गया है, जबकि ML Pathways पूरे प्रशिक्षण प्रक्रिया को व्यवस्थित करने के लिए लचीला प्लेटफ़ॉर्म प्रदान करता है। इस प्रकार का संयोजन गूगल को कुशल प्रशिक्षण कार्यप्रवाह को लागू करने में सक्षम बनाता है।

gemma-2-2b-jpn-it के लॉन्च के साथ, इसके कई क्षेत्रों में अनुप्रयोग संभावनाओं पर व्यापक ध्यान दिया गया है। यह मॉडल सामग्री निर्माण और संचार में उत्कृष्टता प्राप्त कर सकता है, जैसे कि कविता, नाटक, कोड, मार्केटिंग सामग्री, और यहां तक कि चैटबॉट प्रतिक्रियाएं उत्पन्न करना। इसकी टेक्स्ट जनरेशन क्षमता सारांश कार्यों के लिए भी उपयुक्त है, जो बड़े पैमाने पर टेक्स्ट को संक्षिप्त सारांश में संकुचित कर सकती है, जो शोध, शिक्षा और ज्ञान अन्वेषण के लिए बहुत उपयुक्त है।

हालांकि, gemma-2-2b-jpn-it में कुछ सीमाएं भी हैं, जिन्हें उपयोगकर्ताओं को समझना आवश्यक है। मॉडल का प्रदर्शन इसके प्रशिक्षण डेटा की विविधता और गुणवत्ता पर निर्भर करता है; यदि डेटा में पूर्वाग्रह या कमी है, तो यह मॉडल की प्रतिक्रियाओं को प्रभावित कर सकता है। इसके अतिरिक्त, चूंकि बड़े भाषा मॉडल में ज्ञान का अंतर्निहित भंडार नहीं होता है, जटिल प्रश्नों को संभालते समय, यह असंगत या पुरानी तथ्यात्मक बयानों को उत्पन्न कर सकता है।

विकास प्रक्रिया के दौरान, गूगल ने नैतिक विचारों पर भी बहुत ध्यान दिया है, gemma-2-2b-jpn-it का कठोर मूल्यांकन किया है ताकि सामग्री सुरक्षा, प्रतिनिधित्व हानि और प्रशिक्षण डेटा स्मृति से संबंधित मुद्दों का समाधान किया जा सके। गूगल ने हानिकारक सामग्री को समाप्त करने के लिए फ़िल्टरिंग तकनीकों को लागू किया है और एक पारदर्शी और जवाबदेही ढांचा स्थापित किया है, जो डेवलपर्स को लगातार निगरानी करने और डेटा गोपनीयता नियमों का पालन सुनिश्चित करने के लिए गोपनीयता संरक्षण तकनीकों को अपनाने के लिए प्रोत्साहित करता है।

मुख्य बिंदु:

🌟 गूगल द्वारा पेश किया गया gemma-2-2b-jpn-it मॉडल विशेष रूप से जापानी भाषा के लिए अनुकूलित है, जिसमें 26.1 अरब पैरामीटर और उन्नत तकनीकी आर्किटेक्चर है।

💡 यह मॉडल सामग्री निर्माण, प्राकृतिक भाषा प्रसंस्करण आदि क्षेत्रों में व्यापक अनुप्रयोग संभावनाएं रखता है, जो विभिन्न टेक्स्ट जनरेशन कार्यों का समर्थन करता है।

🔒 गूगल ने मॉडल विकास में नैतिक विचारों को महत्व दिया है, सामग्री सुरक्षा फ़िल्टरिंग और गोपनीयता संरक्षण उपायों को लागू किया है, ताकि जोखिम को कम किया जा सके।