क्या आपको "चित्र देखकर बात करने" वाले जादुई GPT-4V के बारे में याद है? यह चित्र की सामग्री को समझ सकता है और चित्र के आधार पर कार्य कर सकता है, यह तो आलसी लोगों के लिए एक वरदान है! लेकिन इसका एक गंभीर कमजोर पहलू है: दृष्टि थोड़ी कमजोर है!

कल्पना कीजिए, आप GPT-4V से एक बटन दबाने के लिए कहते हैं, लेकिन यह "स्क्रीन का अंधा" बनकर इधर-उधर क्लिक करता है, क्या यह बहुत परेशान करने वाला नहीं है?

आज हम आपको एक ऐसे जादुई उपकरण के बारे में बताने जा रहे हैं जो GPT-4V की दृष्टि को बेहतर बना सकता है - OmniParser! यह माइक्रोसॉफ्ट द्वारा जारी किया गया एक नया मॉडल है, जिसका उद्देश्य ग्राफिकल यूजर इंटरफेस (GUI) के स्वचालित इंटरैक्शन की समस्याओं को हल करना है।

OmniParser क्या करता है?

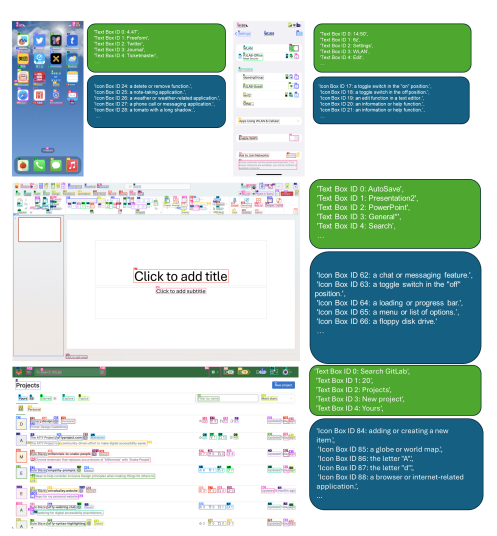

सीधे शब्दों में कहें, OmniParser एक "स्क्रीन अनुवादक" है, जो स्क्रीन के स्क्रिनशॉट को GPT-4V के समझने योग्य "संरचित भाषा" में बदल सकता है। OmniParser ने इंटरैक्टिव आइकन डिटेक्शन मॉडल, आइकन विवरण मॉडल और OCR मॉड्यूल के आउटपुट को मिलाकर बनाया गया है।

यह संयोजन UI के संरचित, DOM जैसी प्रस्तुति उत्पन्न करता है, और संभावित इंटरैक्टिव तत्वों की सीमाओं के चारों ओर स्क्रीनशॉट को कवर करता है। शोधकर्ताओं ने पहले लोकप्रिय वेबपृष्ठों और आइकन विवरण डेटासेट का उपयोग करके एक इंटरैक्टिव आइकन डिटेक्शन डेटासेट बनाया। इन डेटासेट्स का उपयोग विशेष मॉडल को माइक्रो-ट्यून करने के लिए किया गया: एक स्क्रीन पर इंटरैक्टिव क्षेत्रों का पता लगाने के लिए और एक पहचानने के लिए जो तत्वों के कार्यात्मक अर्थ को निकालता है।

विशेष रूप से, OmniParser:

स्क्रीन पर सभी इंटरैक्टिव आइकन और बटन की पहचान करता है और उन्हें बॉक्स में चिह्नित करता है, प्रत्येक बॉक्स को एक अनोखा ID देता है।

प्रत्येक आइकन के कार्य का वर्णन करता है, जैसे "सेटिंग", "न्यूनतम करना"। स्क्रीन पर टेक्स्ट की पहचान करता है और उसे निकालता है।

इस तरह, GPT-4V स्पष्ट रूप से जान सकता है कि स्क्रीन पर क्या है, हर चीज का क्या कार्य है, और किस बटन को दबाना है, बस उसे ID बताना होता है।

OmniParser कितना प्रभावशाली है?

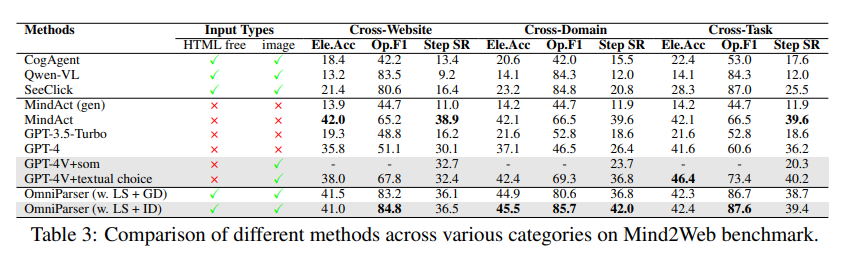

शोधकर्ताओं ने OmniParser का परीक्षण करने के लिए विभिन्न परीक्षणों का उपयोग किया और पाया कि यह वास्तव में GPT-4V की "दृष्टि को बेहतर" बना सकता है!

ScreenSpot परीक्षण में, OmniParser ने GPT-4V की सटीकता को काफी बढ़ा दिया, यहां तक कि कुछ विशेष रूप से ग्राफिकल इंटरफेस के लिए प्रशिक्षित मॉडलों को भी पार कर गया। उदाहरण के लिए, ScreenSpot डेटासेट पर, OmniParser की सटीकता 73% बढ़ गई, जो कि मूल HTML解析 पर निर्भर मॉडल से अधिक है। यह ध्यान देने योग्य है कि UI तत्वों के स्थानीय अर्थ का संयोजन भविष्यवाणी की सटीकता में उल्लेखनीय वृद्धि करता है - OmniParser के आउटपुट का उपयोग करते समय, GPT-4V का आइकन सही पहचान 70.5% से बढ़कर 93.8% हो गया।

Mind2Web परीक्षण में, OmniParser ने GPT-4V के वेब ब्राउज़िंग कार्य में प्रदर्शन को और बेहतर बना दिया, सटीकता यहां तक कि HTML जानकारी की सहायता से GPT-4V से भी अधिक हो गई।

AITW परीक्षण में, OmniParser ने GPT-4V के मोबाइल नेविगेशन कार्य में प्रदर्शन को भी काफी बढ़ा दिया।

OmniParser की क्या कमियाँ हैं?

हालांकि OmniParser बहुत प्रभावशाली है, लेकिन इसमें कुछ छोटी-मोटी समस्याएं हैं, जैसे:

दोहराए गए आइकन या टेक्स्ट के सामने भ्रमित होना, भेद करने के लिए अधिक विस्तृत विवरण की आवश्यकता होती है।

कभी-कभी बॉक्स ठीक से नहीं बनते, जिससे GPT-4V गलत स्थान पर क्लिक कर सकता है।

आइकन की समझ कभी-कभी गलत हो सकती है, अधिक सटीक विवरण के लिए संदर्भ के साथ मिलाना आवश्यक होता है।

हालांकि, शोधकर्ता OmniParser में सुधार करने के लिए प्रयास कर रहे हैं, और हमें विश्वास है कि यह और अधिक शक्तिशाली होगा, और अंततः GPT-4V का सबसे अच्छा साथी बन जाएगा!

मॉडल अनुभव: https://huggingface.co/microsoft/OmniParser

पत्रिका प्रवेश: https://arxiv.org/pdf/2408.00203

आधिकारिक परिचय: https://www.microsoft.com/en-us/research/articles/omniparser-for-pure-vision-based-gui-agent/

मुख्य बिंदु:

✨OmniParser GPT-4V को स्क्रीन की सामग्री को बेहतर समझने में मदद कर सकता है, जिससे यह कार्य को अधिक सटीकता से निष्पादित कर सकता है।

🔍OmniParser विभिन्न परीक्षणों में उत्कृष्ट प्रदर्शन करता है, जो इसकी प्रभावशीलता को साबित करता है।

🛠️OmniParser में कुछ सुधार की आवश्यकता है, लेकिन भविष्य की संभावनाएं उज्ज्वल हैं।