कृत्रिम बुद्धिमत्ता के क्षेत्र में, जितना बड़ा आकार होता है, लगता है कि उसकी क्षमता उतनी ही अधिक होती है। अधिक शक्तिशाली भाषा मॉडल के लिए, प्रमुख तकनीकी कंपनियां मॉडल पैरामीटर और प्रशिक्षण डेटा को बेतहाशा बढ़ा रही हैं, लेकिन परिणामस्वरूप उन्हें लागत में भी भारी वृद्धि का सामना करना पड़ रहा है। क्या भाषा मॉडल को प्रशिक्षित करने का कोई ऐसा तरीका नहीं है जो दोनों आर्थिक और प्रभावी हो?

हार्वर्ड विश्वविद्यालय और स्टैनफोर्ड विश्वविद्यालय के शोधकर्ताओं ने हाल ही में एक पेपर प्रकाशित किया है, जिसमें उन्होंने पाया कि मॉडल प्रशिक्षण की सटीकता (precision) एक छिपी हुई कुंजी की तरह है, जो भाषा मॉडल प्रशिक्षण के "लागत कोड" को अनलॉक कर सकती है।

मॉडल सटीकता क्या है? सरल शब्दों में, इसका मतलब है कि मॉडल पैरामीटर और गणना प्रक्रिया में उपयोग किए जाने वाले संख्यात्मक बिट्स की संख्या। पारंपरिक गहरे शिक्षण मॉडल आमतौर पर प्रशिक्षण के लिए 32-बिट फ्लोटिंग पॉइंट (FP32) का उपयोग करते हैं, लेकिन हाल के वर्षों में, हार्डवेयर के विकास के साथ, 16-बिट फ्लोटिंग पॉइंट (FP16) या 8-बिट पूर्णांक (INT8) जैसे कम सटीकता वाले संख्यात्मक प्रकारों का उपयोग करना संभव हो गया है।

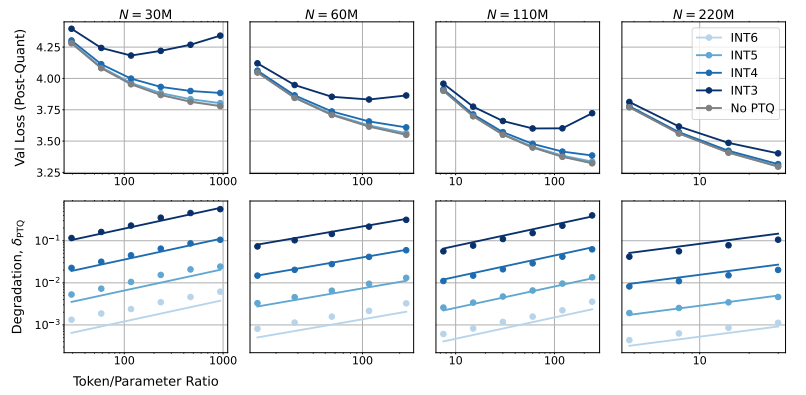

तो, मॉडल की सटीकता को कम करने से मॉडल के प्रदर्शन पर क्या प्रभाव पड़ेगा? यही इस पेपर का अनुसंधान प्रश्न है। शोधकर्ताओं ने विभिन्न सटीकताओं के तहत मॉडल प्रशिक्षण और निष्पादन के लागत और प्रदर्शन में बदलाव का विश्लेषण करने के लिए बड़े पैमाने पर प्रयोग किए और एक नई "सटीकता-संवेदनशील" स्केलिंग नियमावली प्रस्तुत की।

उन्होंने पाया कि कम सटीकता का उपयोग करके प्रशिक्षण करने से मॉडल के "प्रभावी पैरामीटर संख्या" को प्रभावी ढंग से कम किया जा सकता है, जिससे प्रशिक्षण के लिए आवश्यक गणना की मात्रा में कमी आती है। इसका मतलब है कि समान गणना बजट में, हम बड़े पैमाने के मॉडल को प्रशिक्षित कर सकते हैं, या समान आकार में, कम सटीकता का उपयोग करने से बड़ी मात्रा में गणना संसाधनों की बचत हो सकती है।

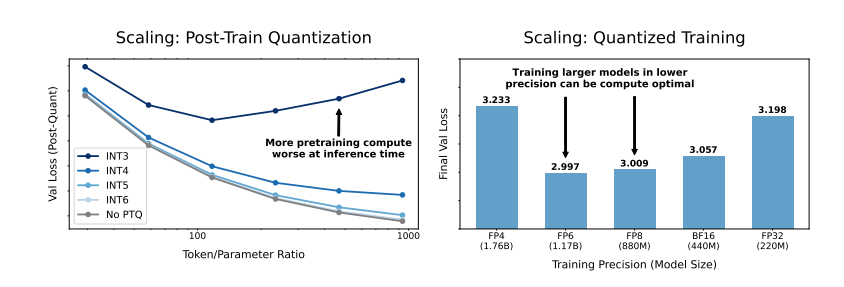

और भी आश्चर्यजनक बात यह है कि शोधकर्ताओं ने यह भी पाया कि कुछ मामलों में, कम सटीकता का उपयोग करके प्रशिक्षण करने से मॉडल के प्रदर्शन में सुधार हो सकता है! उदाहरण के लिए, उन मॉडलों के लिए जिन्हें "मात्रात्मक प्रशिक्षण के बाद" (post-training quantization) की आवश्यकता होती है, यदि प्रशिक्षण चरण में कम सटीकता का उपयोग किया जाए, तो मॉडल मात्रात्मक सटीकता में कमी के प्रति अधिक मजबूत होता है, जिससे निष्पादन चरण में बेहतर प्रदर्शन होता है।

तो, हमें मॉडल को प्रशिक्षित करने के लिए कौन सी सटीकता चुननी चाहिए? शोधकर्ताओं ने अपनी स्केलिंग नियमावली का विश्लेषण करके कुछ दिलचस्प निष्कर्ष निकाले:

पारंपरिक 16-बिट सटीकता प्रशिक्षण शायद सबसे अच्छा विकल्प नहीं है। उनके शोध से पता चला है कि 7-8-बिट सटीकता शायद अधिक आर्थिक और प्रभावी विकल्प हो सकता है।

अत्यधिक कम सटीकता (जैसे 4-बिट) के प्रशिक्षण की कोशिश करना भी बुद्धिमानी नहीं है। क्योंकि अत्यधिक कम सटीकता में, मॉडल के प्रभावी पैरामीटर की संख्या तेजी से घट जाती है, प्रदर्शन बनाए रखने के लिए, हमें मॉडल का आकार काफी बढ़ाना पड़ता है, जिससे उच्च गणना लागत होती है।

विभिन्न आकार के मॉडलों के लिए, सबसे अच्छी प्रशिक्षण सटीकता भिन्न हो सकती है। उन मॉडलों के लिए जिन्हें बहुत अधिक "अधिक प्रशिक्षण" (overtraining) की आवश्यकता होती है, जैसे Llama-3 और Gemma-2 श्रृंखला, उच्च सटीकता का उपयोग करके प्रशिक्षण करना अधिक आर्थिक और प्रभावी हो सकता है।

यह शोध हमें भाषा मॉडल प्रशिक्षण को समझने और अनुकूलित करने के लिए एक नया दृष्टिकोण प्रदान करता है। यह हमें बताता है कि सटीकता का चयन स्थिर नहीं है, बल्कि इसे विशेष मॉडल आकार, प्रशिक्षण डेटा मात्रा और अनुप्रयोग परिदृश्यों के अनुसार संतुलित करना आवश्यक है।

बेशक, इस शोध में कुछ सीमाएँ भी हैं। उदाहरण के लिए, उनके द्वारा उपयोग किए गए मॉडल का आकार अपेक्षाकृत छोटा है, और प्रयोग के परिणामों को बड़े आकार के मॉडलों पर सीधे लागू नहीं किया जा सकता। इसके अलावा, उन्होंने केवल मॉडल के हानि फ़ंक्शन पर ध्यान केंद्रित किया है, और नीचे के कार्यों पर मॉडल के प्रदर्शन का मूल्यांकन नहीं किया है।

फिर भी, यह शोध महत्वपूर्ण है। यह मॉडल सटीकता और मॉडल प्रदर्शन और प्रशिक्षण लागत के बीच जटिल संबंध को उजागर करता है और हमें भविष्य में अधिक शक्तिशाली और आर्थिक भाषा मॉडल डिजाइन और प्रशिक्षित करने के लिए मूल्यवान अंतर्दृष्टि प्रदान करता है।

पेपर: https://arxiv.org/pdf/2411.04330