हाल ही में, एआई बड़े भाषा मॉडल (LLM) ने विभिन्न कार्यों में उत्कृष्ट प्रदर्शन किया है, कविता लिखना, कोड लिखना, बातचीत करना कोई बड़ी बात नहीं है, यह सचमुच सब कुछ कर सकता है! लेकिन, क्या आप विश्वास कर सकते हैं? ये "जीनियस" एआई वास्तव में "गणित के नौसिखिए" हैं! ये सरल अंकगणितीय समस्याओं को हल करते समय अक्सर गड़बड़ कर देते हैं, जो लोगों को चौंका देता है।

एक नवीनतम अध्ययन ने LLM के अंकगणितीय तर्क क्षमता के पीछे के "अजीब" रहस्य को उजागर किया: ये न तो शक्तिशाली एल्गोरिदम पर निर्भर करते हैं और न ही पूरी तरह से याददाश्त पर, बल्कि एक रणनीति अपनाते हैं जिसे "हीुरिस्टिक हॉटचपॉट" कहा जाता है! यह एक छात्र की तरह है, जो गणित के सूत्रों और प्रमेयों को गंभीरता से नहीं पढ़ता, बल्कि कुछ "छोटी चतुराई" और "अनुभव के नियमों" पर निर्भर करता है।

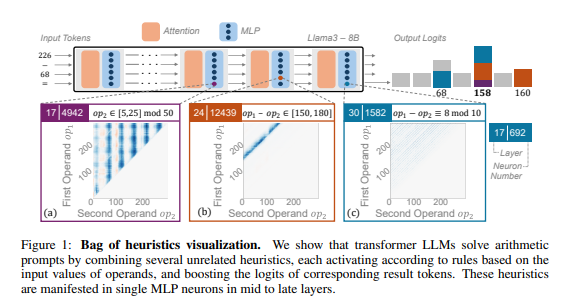

शोधकर्ताओं ने अंकगणितीय तर्क को एक विशिष्ट कार्य के रूप में लेते हुए Llama3, Pythia और GPT-J जैसे कई LLM का गहन विश्लेषण किया। उन्होंने पाया कि LLM मॉडल में अंकगणितीय गणना के लिए जिम्मेदार भाग (जिसे "सर्किट" कहा जाता है) कई एकल न्यूरॉनों से बना होता है, प्रत्येक न्यूरॉन एक "सूक्ष्म कैलकुलेटर" की तरह होता है, जो केवल विशिष्ट संख्या पैटर्न की पहचान करता है और संबंधित उत्तर देता है। उदाहरण के लिए, एक न्यूरॉन "अंक में 8 होने वाले नंबर" की पहचान करने के लिए विशेष रूप से जिम्मेदार हो सकता है, जबकि दूसरा न्यूरॉन "150 से 180 के बीच के परिणाम वाले घटाव" की पहचान करता है।

ये "सूक्ष्म कैलकुलेटर" जैसे एक बेतरतीब औजारों का ढेर हैं, LLM इन्हें किसी विशिष्ट एल्गोरिदम के अनुसार उपयोग नहीं करता, बल्कि इन "औजारों" को उत्तर की गणना के लिए इनपुट संख्या पैटर्न के आधार पर यादृच्छिक रूप से संयोजित करता है। यह एक रसोइये की तरह है, जिसके पास कोई निश्चित नुस्खा नहीं है, बल्कि वह उपलब्ध सामग्री के आधार पर मनमाने ढंग से मिलाकर "डार्क डिश" बनाता है।

और भी आश्चर्यजनक बात यह है कि यह "हीुरिस्टिक हॉटचपॉट" रणनीति LLM के प्रशिक्षण के प्रारंभिक चरण में ही प्रकट हो गई थी, और प्रशिक्षण के साथ-साथ धीरे-धीरे सुधार होती गई। इसका मतलब है कि LLM शुरू से ही इस "जोड़-तोड़" तर्क विधि पर निर्भर करता है, न कि बाद में इस रणनीति का विकास करता है।

तो, यह "अजीब" अंकगणितीय तर्क विधि किस समस्या का कारण बनती है? शोधकर्ताओं ने पाया कि "हीुरिस्टिक हॉटचपॉट" रणनीति की सामान्यीकरण क्षमता सीमित है, जिससे गलतियाँ होने की संभावना होती है। इसका कारण यह है कि LLM द्वारा उपयोग किए जाने वाले "छोटे चतुराइयां" की संख्या सीमित है, और ये "छोटे चतुराइयां" स्वयं भी दोषपूर्ण हो सकते हैं, जिससे वे नए संख्या पैटर्न का सामना करते समय सही उत्तर नहीं दे पाते। जैसे एक रसोइया जो केवल "टमाटर अंडा" बना सकता है, उसे अचानक "फिश फ्राई" बनाने के लिए कहा जाए, तो वह निश्चित रूप से परेशान होगा।

यह अध्ययन LLM की अंकगणितीय तर्क क्षमता की सीमाओं को उजागर करता है, और भविष्य में LLM की गणितीय क्षमताओं में सुधार के लिए दिशा भी दिखाता है। शोधकर्ताओं का मानना है कि केवल मौजूदा प्रशिक्षण विधियों और मॉडल संरचनाओं पर निर्भर रहना LLM की अंकगणितीय तर्क क्षमता को बढ़ाने के लिए पर्याप्त नहीं हो सकता, और LLM को अधिक शक्तिशाली और सामान्यीकृत एल्गोरिदम सीखने में मदद करने के लिए नए तरीकों की खोज करनी होगी, ताकि वे वास्तव में "गणित के विशेषज्ञ" बन सकें।

पेपर का पता: https://arxiv.org/pdf/2410.21272