अली क्लाउड बायालियन प्लेटफ़ॉर्म ने हाल ही में Qwen2.5-Turbo मिलियन लंबे टेक्स्ट मॉडल लॉन्च करने की घोषणा की है। Qwen2.5-Turbo मॉडल को टोंगयि कियानवेन टीम द्वारा विकसित किया गया है, जो 1000000 टोकन तक के सुपर लंबे संदर्भ को संसाधित करने का समर्थन करता है, जो 1000000 अंग्रेजी शब्दों या 1500000 चीनी वर्णों के बराबर है।

इस नए संस्करण के मॉडल ने लंबे टेक्स्ट खोज कार्यों में 100% सटीकता हासिल की है, और लंबे टेक्स्ट मूल्यांकन सेट RULER पर 93.1 अंक प्राप्त किए हैं, जो GPT-4 को पार करता है। LV-Eval, LongBench-Chat जैसे वास्तविक परिदृश्यों के करीब लंबे टेक्स्ट कार्यों में, Qwen2.5-Turbo अधिकांश आयामों में GPT-4o-mini को पार कर गया है। छोटे टेक्स्ट बेंचमार्क परीक्षणों में, Qwen2.5-Turbo का प्रदर्शन भी बहुत अच्छा रहा है, पहले के 1M टोकन संदर्भ लंबाई वाले ओपन-सोर्स मॉडल को काफी पीछे छोड़ते हुए।

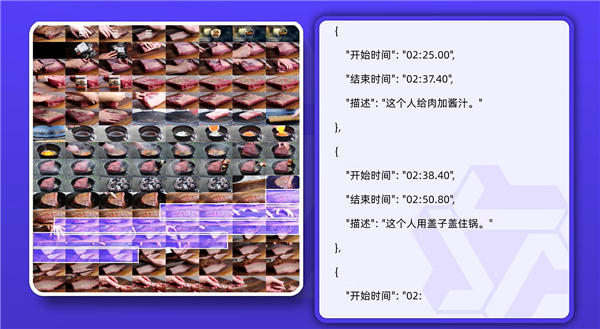

Qwen2.5-Turbo मॉडल के अनुप्रयोग परिदृश्य व्यापक हैं, जिसमें लंबे उपन्यासों की गहन समझ, बड़े पैमाने पर कोड सहायक, कई शोध पत्र पढ़ना आदि शामिल हैं, जो एक बार में 10 लंबे उपन्यास, 150 घंटे के भाषण稿 या 30000 पंक्तियों का कोड संसाधित कर सकते हैं। अनुमानित गति के मामले में, टोंगयि कियानवेन टीम ने विरल ध्यान तंत्र के माध्यम से गणना की मात्रा को लगभग 12.5 गुना कम कर दिया है, 1M टोकन संदर्भ के पहले शब्द को लौटाने का समय 4.9 मिनट से घटाकर 68 सेकंड कर दिया है, जिससे 4.3 गुना की गति में सुधार हुआ है।

अली क्लाउड बायालियन प्लेटफ़ॉर्म सभी उपयोगकर्ताओं को Qwen2.5-Turbo API को सीधे कॉल करने की क्षमता प्रदान करता है, और सीमित समय के लिए 10000000 टोकन की मात्रा मुफ्त में देता है। बाद में 1 मिलियन टोकन के उपयोग की लागत केवल 0.3 युआन है।

वर्तमान में, अली क्लाउड बायालियन प्लेटफ़ॉर्म ने Qwen, Llama, ChatGLM सहित 200 से अधिक प्रमुख घरेलू और अंतरराष्ट्रीय ओपन-सोर्स और क्लोज़-सोर्स बड़े मॉडल लॉन्च किए हैं, जो उपयोगकर्ताओं को सीधे कॉल करने, प्रशिक्षण में सुधार करने या RAG अनुप्रयोग बनाने का समर्थन करते हैं।