AI की दुनिया में, "बड़ी मेहनत से चमत्कार" एक सुनहरे नियम की तरह लगने लगा है। मॉडल जितना बड़ा, डेटा जितना अधिक, और कंप्यूटिंग शक्ति जितनी मजबूत, ऐसा लगता है कि हम बुद्धिमत्ता के पवित्र ग्रंथ के करीब पहुँच सकते हैं। हालाँकि, इस तेज़ी के पीछे, विशाल लागत और ऊर्जा खपत का दबाव छिपा हुआ है।

AI प्रशिक्षण को अधिक कुशल बनाने के लिए, वैज्ञानिक अधिक शक्तिशाली ऑप्टिमाइज़र की खोज में लगे हुए हैं, जैसे एक कोच, जो मॉडल के पैरामीटर को लगातार अनुकूलित करने में मदद करता है, अंततः सर्वश्रेष्ठ स्थिति तक पहुँचता है। AdamW, जो Transformer प्री-ट्रेनिंग का डिफ़ॉल्ट ऑप्टिमाइज़र है, वर्षों से उद्योग का मानक रहा है। हालाँकि, बढ़ते मॉडल आकार के सामने, AdamW भी अब असमर्थ दिखने लगा है।

क्या कोई ऐसा तरीका नहीं है, जो प्रशिक्षण की गति को बढ़ा सके और ऊर्जा खपत को कम कर सके? चिंता न करें, एक पूरी चीनी टीम अपने "गुप्त हथियार" C-AdamW के साथ आ रही है!

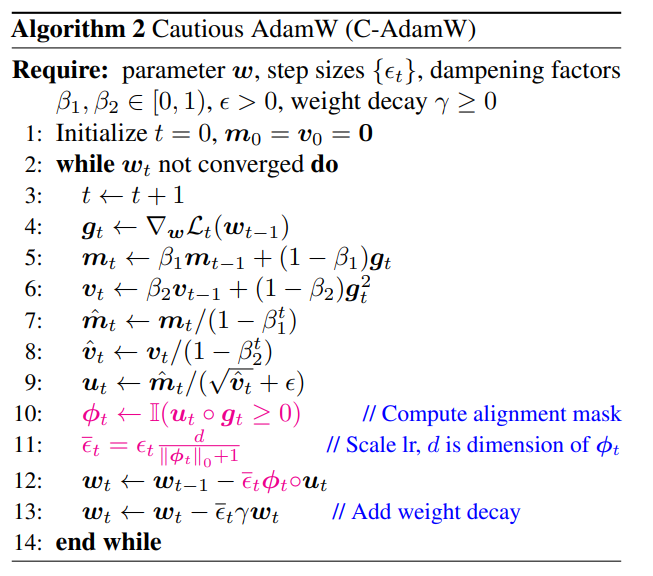

C-AdamW का पूरा नाम Cautious AdamW है, जिसका हिंदी में अर्थ है "सावधान AdamW", क्या यह सुनने में "ध्यानशील" नहीं लगता? बिल्कुल सही, C-AdamW का मूल विचार "सोच-समझकर कदम उठाना" है।

कल्पना कीजिए, मॉडल के पैरामीटर एक समूह की तरह हैं जो हमेशा इधर-उधर दौड़ना चाहते हैं। AdamW एक जिम्मेदार शिक्षक की तरह है, जो उन्हें सही दिशा में आगे बढ़ने में मदद करता है। लेकिन कभी-कभी, बच्चे बहुत उत्साहित हो जाते हैं और गलत दिशा में दौड़ते हैं, जिससे समय और ऊर्जा बर्बाद होती है।

इस समय, C-AdamW एक बुद्धिमान वृद्ध की तरह है, जो "सत्य की दृष्टि" के साथ अपडेट की दिशा को सटीक रूप से पहचान सकता है। यदि दिशा गलत है, तो C-AdamW तुरंत रोक देता है, जिससे मॉडल गलत रास्ते पर और अधिक नहीं बढ़ता।

यह "सावधानी" की रणनीति सुनिश्चित करती है कि प्रत्येक अपडेट प्रभावी रूप से हानि फ़ंक्शन को कम कर सके, जिससे मॉडल की संकुचन गति तेज हो जाती है। प्रयोगात्मक परिणामों से पता चलता है कि C-AdamW Llama और MAE प्री-ट्रेनिंग में प्रशिक्षण गति को 1.47 गुना बढ़ा देता है!

और सबसे महत्वपूर्ण बात यह है कि C-AdamW में लगभग कोई अतिरिक्त गणनात्मक लागत नहीं है, केवल मौजूदा कोड में एक साधारण परिवर्तन करना होता है। इसका मतलब है कि डेवलपर्स आसानी से C-AdamW को विभिन्न मॉडल प्रशिक्षण में लागू कर सकते हैं और "गति और उत्साह" का आनंद ले सकते हैं!

C-AdamW की "ध्यानशीलता" यह है कि यह Adam के हैमिल्टन फ़ंक्शन को बनाए रखता है और लियापुनोव विश्लेषण के तहत संकुचन की गारंटी को नष्ट नहीं करता। इसका मतलब है कि C-AdamW न केवल तेज है, बल्कि इसकी स्थिरता भी सुनिश्चित की गई है, जिससे प्रशिक्षण में दुर्घटनाएं नहीं होती हैं।

बेशक, "ध्यानशीलता" का मतलब "कोई प्रगति नहीं" नहीं है। शोध टीम ने कहा है कि वे अधिक समृद्ध ϕ फ़ंक्शन का अन्वेषण जारी रखेंगे और प्रदर्शन स्थान में मास्क लागू करेंगे, ताकि C-AdamW के प्रदर्शन को और बढ़ाया जा सके।

यह अनुमान लगाया जा सकता है कि C-AdamW गहरे शिक्षण के क्षेत्र में एक नया प्रिय बन जाएगा, जो बड़े मॉडल प्रशिक्षण में क्रांतिकारी परिवर्तन लाएगा!

पेपर का लिंक: https://arxiv.org/abs/2411.16085

GitHub:

https://github.com/kyleliang919/C-Optim