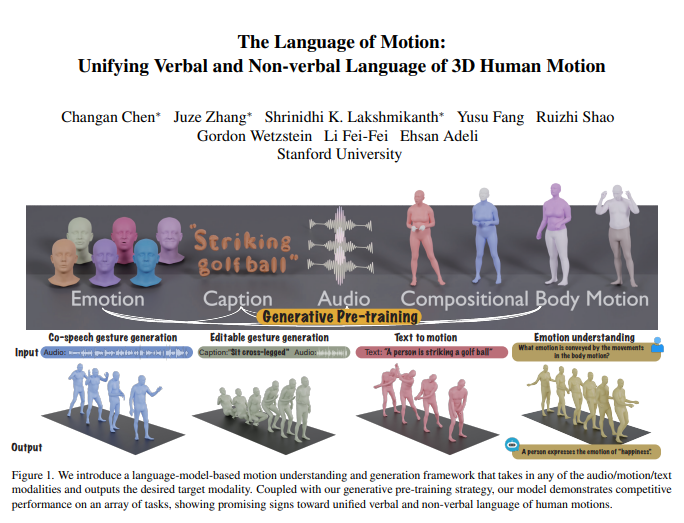

ली फेइफेई की टीम ने एक नया मल्टी-मोडल मॉडल पेश किया है, जो मानव क्रियाओं को समझने और उत्पन्न करने में सक्षम है, और भाषाई मॉडल को संयोजित करके मौखिक और गैर-मौखिक भाषाओं के एकीकृत प्रसंस्करण को संभव बनाया है। यह क्रांतिकारी अनुसंधान मशीनों को न केवल मानव निर्देशों को समझने में सक्षम बनाता है, बल्कि क्रियाओं में निहित भावनाओं को भी पढ़ने में सक्षम बनाता है, जिससे मानव-मशीन इंटरैक्शन अधिक स्वाभाविक हो जाता है।

इस मॉडल का核心 इसके मल्टी-मोडल भाषा मॉडल ढांचे में है, जो ऑडियो, क्रियाओं और टेक्स्ट जैसे विभिन्न प्रकार के इनपुट को स्वीकार कर सकता है और आवश्यक मोड डेटा का आउटपुट देता है। जनरेटिव प्री-ट्रेनिंग रणनीति के साथ, यह मॉडल कई कार्यों में उत्कृष्ट प्रदर्शन दिखाता है। उदाहरण के लिए, सहयोगी आवाज इशारा उत्पन्न करने के मामले में, यह मॉडल न केवल मौजूदा तकनीकी स्तर को पार करता है, बल्कि प्रशिक्षण के लिए आवश्यक डेटा की मात्रा को भी काफी कम करता है। इसके अलावा, यह मॉडल नए अनुप्रयोग परिदृश्यों को भी अनलॉक करता है, जैसे संपादन योग्य इशारा उत्पन्न करना और क्रियाओं के माध्यम से भावनाओं की भविष्यवाणी करना।

मानव संचार स्वाभाविक रूप से मल्टी-मोडल होता है, जिसमें मौखिक और गैर-मौखिक संकेत शामिल होते हैं, जैसे आवाज, चेहरे के भाव और शारीरिक मुद्रा। यह मॉडल इन मल्टी-मोडल व्यवहारों को समझने में सक्षम है, जो गेम, फिल्म और वर्चुअल रियलिटी जैसे अनुप्रयोगों में स्वाभाविक रूप से संवाद करने वाले आभासी पात्रों को बनाने के लिए महत्वपूर्ण है। हालाँकि, मौजूदा क्रिया उत्पन्न करने वाले मॉडल आमतौर पर विशिष्ट इनपुट मोड (आवाज, टेक्स्ट या क्रिया डेटा) तक सीमित होते हैं, और उपलब्ध डेटा की विविधता का पूरी तरह से उपयोग नहीं कर पाते हैं।

यह मॉडल भाषाई मॉडल का उपयोग करके मौखिक और गैर-मौखिक भाषाओं को एकीकृत करता है, जिसके मुख्य तीन कारण हैं:

भाषाई मॉडल स्वाभाविक रूप से विभिन्न मोडों को जोड़ता है।

आवाज में उच्च स्तर की अर्थवत्ता होती है, जबकि मजाकों पर प्रतिक्रिया जैसी कार्यों का मॉडलिंग करने के लिए मजबूत अर्थीय तर्क क्षमता की आवश्यकता होती है।

भाषाई मॉडल व्यापक प्री-ट्रेनिंग के माध्यम से मजबूत अर्थीय समझ प्राप्त करता है।

इस लक्ष्य को प्राप्त करने के लिए, अनुसंधान टीम ने पहले शरीर को विभिन्न भागों (चेहरा, हाथ, ऊपरी शरीर, निचला शरीर) में विभाजित किया और प्रत्येक भाग को अलग से क्रिया लेबल किया। टेक्स्ट और आवाज के लेबलर के संयोजन के साथ, किसी भी मोड का इनपुट एक श्रृंखला के रूप में प्रस्तुत किया जा सकता है, जिसका उपयोग भाषाई मॉडल द्वारा किया जा सकता है। यह मॉडल दो चरणों की प्रशिक्षण प्रक्रिया अपनाता है: पहले प्री-ट्रेनिंग, विभिन्न मोडों और संयोजित शारीरिक क्रियाओं के संरेखण के लिए, और ऑडियो और टेक्स्ट के संरेखण के लिए। इसके बाद, डाउनस्ट्रीम कार्यों को निर्देशों में परिवर्तित किया जाता है, और इन निर्देशों पर मॉडल को प्रशिक्षित किया जाता है ताकि वह विभिन्न कार्य निर्देशों का पालन कर सके।

यह मॉडल BEATv2 सहयोगी आवाज इशारा उत्पन्न करने वाले बेंचमार्क परीक्षण में उत्कृष्ट प्रदर्शन करता है, जो मौजूदा मॉडलों को काफी पीछे छोड़ देता है। प्री-ट्रेनिंग रणनीति की प्रभावशीलता भी सिद्ध हुई है, विशेष रूप से डेटा की कमी के मामले में, यह मजबूत सामान्यीकरण क्षमता प्रदर्शित करता है। आवाज-क्रिया और टेक्स्ट-क्रिया कार्यों पर बाद के प्रशिक्षण के माध्यम से, मॉडल न केवल ऑडियो और टेक्स्ट संकेतों का पालन कर सकता है, बल्कि क्रिया डेटा से भावनाओं की भविष्यवाणी करने जैसी नई क्षमताएँ भी प्राप्त कर सकता है।

तकनीकी विवरण में, यह मॉडल विभिन्न इनपुट मोडों को संसाधित करने के लिए मोड विशिष्ट लेबलर का उपयोग करता है। विशेष रूप से, यह मॉडल ने एक संयोजन शरीर गति VQ-VAE का प्रशिक्षण किया है, जो चेहरे, हाथ, ऊपरी शरीर और निचले शरीर की क्रियाओं को डिस्क्रीट लेबल में परिवर्तित करता है। ये मोड विशिष्ट शब्दावली (ऑडियो और टेक्स्ट) एक एकीकृत मल्टी-मोडल शब्दकोश में संयोजित की जाती हैं। प्रशिक्षण प्रक्रिया के दौरान, विभिन्न मोडों के मिश्रित लेबल को इनपुट के रूप में उपयोग किया जाता है, और आउटपुट उत्पन्न करने के लिए एन्कोडर-डीकोडर भाषाई मॉडल का उपयोग किया जाता है।

यह मॉडल मल्टी-मोडल शब्दकोश का भी उपयोग करता है, जो विभिन्न मोड डेटा को एकीकृत प्रारूप में परिवर्तित करने के लिए उपयोग किया जाता है। प्री-ट्रेनिंग चरण में, मॉडल विभिन्न मोडों के बीच रूपांतरण कार्यों को निष्पादित करके विभिन्न मोडों के बीच के संबंधों को सीखता है। उदाहरण के लिए, मॉडल ऊपरी शरीर की क्रियाओं को निचले शरीर की क्रियाओं में बदलना या ऑडियो को टेक्स्ट में परिवर्तित करना सीख सकता है। इसके अलावा, मॉडल कुछ क्रिया फ़्रेमों को यादृच्छिक रूप से मास्क करके क्रियाओं के समय विकास को भी सीखता है।

बाद के प्रशिक्षण चरण में, मॉडल पेयर किए गए डेटा का उपयोग करके समायोजित किया जाता है, ताकि सहयोगी आवाज इशारा उत्पन्न करने या टेक्स्ट से क्रिया उत्पन्न करने जैसे डाउनस्ट्रीम कार्यों को निष्पादित किया जा सके। मॉडल को स्वाभाविक मानव निर्देशों का पालन करने में सक्षम बनाने के लिए, शोधकर्ताओं ने एक मल्टी-टास्क निर्देश पालन टेम्पलेट बनाया, जो ऑडियो से क्रिया, टेक्स्ट से क्रिया और भावना से क्रिया जैसे कार्यों को निर्देशों में परिवर्तित करता है। यह मॉडल इशारों को संपादित करने की क्षमता भी रखता है, जो टेक्स्ट और ऑडियो संकेतों के आधार पर समन्वित पूरे शरीर की क्रियाएँ उत्पन्न कर सकता है।

अंत में, यह मॉडल क्रियाओं से भावनाओं की भविष्यवाणी करने की नई क्षमता भी अनलॉक करता है। यह मानसिक स्वास्थ्य या मनोचिकित्सा जैसे क्षेत्रों के लिए महत्वपूर्ण है। अन्य मॉडलों की तुलना में, यह मॉडल क्रियाओं में व्यक्त की गई भावनाओं की अधिक सटीकता से भविष्यवाणी कर सकता है, जो मजबूत शारीरिक भाषा समझ क्षमता को दर्शाता है।

यह अध्ययन यह दर्शाता है कि मानव क्रियाओं के मौखिक और गैर-मौखिक भाषाओं का एकीकरण व्यावहारिक अनुप्रयोगों के लिए अत्यंत महत्वपूर्ण है, और भाषाई मॉडल इसके लिए एक मजबूत ढांचा प्रदान करता है।

पेपर का लिंक: https://arxiv.org/pdf/2412.10523v1