बड़े AI मॉडल (जैसे Transformer और भाषा मॉडल) का प्रशिक्षण AI क्षेत्र में एक अनिवार्य कुंजी घटक बन गया है, लेकिन इसे उच्च गणना लागत, मेमोरी खपत और ऊर्जा मांगों का सामना करना पड़ता है। उदाहरण के लिए, OpenAI का GPT-3 175 अरब पैरामीटर के साथ आता है, जिसे GPU प्रशिक्षण के लिए कई सप्ताह की आवश्यकता होती है। इस विशाल संसाधन की मांग ने इस तकनीक के बड़े पैमाने पर उन संगठनों में उपयोग को सीमित कर दिया है जिनके पास पर्याप्त कंप्यूटिंग संसाधन हैं, साथ ही ऊर्जा दक्षता और पर्यावरणीय प्रभाव के बारे में चिंताओं को भी बढ़ा दिया है। इन चुनौतियों का समाधान करना AI के विकास की व्यापक पहुंच और स्थिरता को सुनिश्चित करने के लिए महत्वपूर्ण है।

पारंपरिक प्रशिक्षण विधियाँ अप्रभावी हैं, नवोन्मेषक समाधानों की आवश्यकता है

बड़े मॉडल प्रशिक्षण की कम दक्षता का मुख्य कारण घनिष्ठ मैट्रिक्स पर निर्भरता है, जिसके लिए बड़ी मात्रा में मेमोरी और गणना क्षमता की आवश्यकता होती है। आधुनिक GPU कम-गुणवत्ता या कम-रैंक संचालन के अनुकूलन के लिए सीमित समर्थन प्रदान करते हैं, जिससे इन आवश्यकताओं में और वृद्धि होती है। कुछ विधियाँ, जैसे मैट्रिक्स विघटन और प्रेरणात्मक रैंक कमी, इन समस्याओं को हल करने के लिए प्रस्तावित की गई हैं, लेकिन व्यावहारिक अनुप्रयोगों में ये सीमित हैं। उदाहरण के लिए, GaLore एक बैच सेटिंग में प्रशिक्षण कर सकता है, लेकिन इसमें अवास्तविक रनटाइम ओवरहेड होता है। इसी तरह, कम रैंक के अनुकूलकों का उपयोग करते हुए LTE बड़े कार्यों में संकुचन के मामले में समस्याएँ पेश करता है। वर्तमान में एक ऐसा तरीका नहीं है जो मेमोरी उपयोग, गणना लागत और प्रशिक्षण समय को एक साथ कम कर सके, बिना प्रदर्शन को नुकसान पहुँचाए, जिससे नवोन्मेषक समाधानों की मांग और भी आवश्यक हो गई है।

CoMERA ढांचा: अनुकूली टेन्सर ऑप्टिमाइजेशन के माध्यम से कुशल प्रशिक्षण

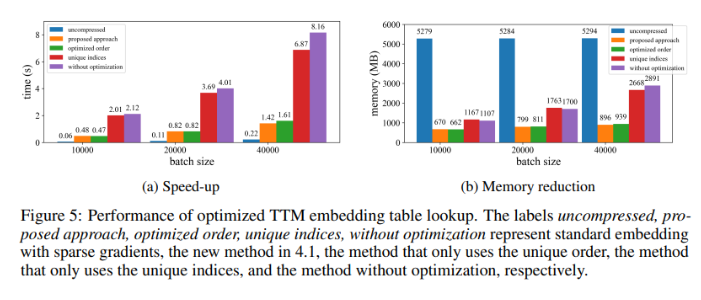

न्यूयॉर्क स्टेट यूनिवर्सिटी के अल्बानी विश्वविद्यालय, कैलिफोर्निया विश्वविद्यालय सांता बारबरा, अमेज़न एलेक्सा AI और मेटा के शोधकर्ताओं ने CoMERA (Computing-and Memory-Efficient training method via Rank-Adaptive tensor optimization) नामक एक नई ढाँचा प्रस्तुत किया है। यह ढाँचा मेमोरी दक्षता और गणना गति को अनुकूली रैंक टेन्सर संकुचन तकनीक के माध्यम से एकीकृत करता है। पारंपरिक विधियों के विपरीत जो केवल संकुचन पर ध्यान केंद्रित करती हैं, CoMERA संकुचन अनुपात और मॉडल सटीकता के बीच संतुलन बनाने के लिए बहु-लक्ष्य अनुकूलन विधियों का उपयोग करता है। यह GPU उपयोगिता को अनुकूलित करने के लिए टेन्सर एम्बेडिंग और उन्नत टेन्सर नेटवर्क संकुचन का उपयोग करता है, जिससे रनटाइम ओवरहेड को कम किया जा सकता है, जबकि मजबूत प्रदर्शन बनाए रखा जा सकता है। यह ढाँचा CUDA ग्राफ भी पेश करता है, ताकि GPU संचालन के दौरान कर्नेल प्रारंभ विलंबता को न्यूनतम किया जा सके, जो पारंपरिक टेन्सर संकुचन विधियों में एक प्रमुख बाधा है।

CoMERA की आधारशिला अनुकूली टेन्सर प्रतिनिधित्व है, जो मॉडल स्तरों को संसाधन प्रतिबंधों के अनुसार अपने रैंक को गतिशील रूप से समायोजित करने की अनुमति देती है। टेन्सर रैंक को संशोधित करके, यह ढाँचा न्यूरल नेटवर्क संचालन की अखंडता को नुकसान पहुँचाए बिना संकुचन को प्राप्त कर सकता है। यह गतिशील अनुकूलन एक दो-चरणीय प्रशिक्षण प्रक्रिया के माध्यम से प्राप्त किया जाता है:

प्रारंभिक चरण: स्थिर संकुचन पर ध्यान केंद्रित करना।

पश्चात चरण: विशिष्ट संकुचन लक्ष्यों को पूरा करने के लिए रैंक को समायोजित करना।

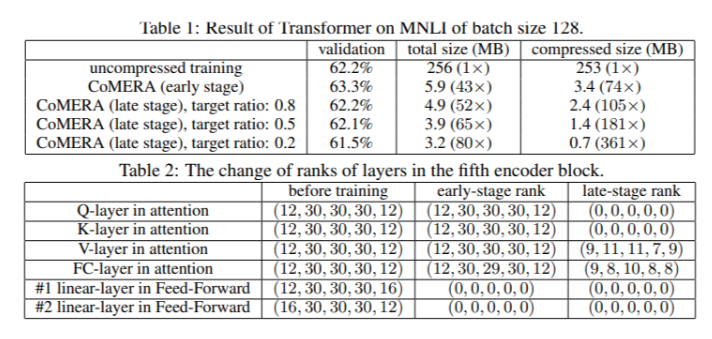

एक छह एन्कोडर Transformer मॉडल में, CoMERA ने अपने प्रारंभिक चरण में 43 गुना तक संकुचन अनुपात प्राप्त किया, जबकि इसके पश्चात अनुकूलन चरण में, संकुचन अनुपात 361 गुना तक बढ़ गया। इसके अलावा, GaLore की तुलना में, इसने मेमोरी खपत को 9 गुना कम किया और प्रत्येक प्रशिक्षण चक्र की गति को 2-3 गुना बढ़ा दिया।

अनेक परीक्षण परिणामों से CoMERA का प्रदर्शन उत्कृष्ट साबित हुआ

जब MNLI डेटा सेट पर प्रशिक्षण के लिए Transformer मॉडल पर लागू किया गया, तो CoMERA ने मॉडल का आकार 256MB से घटाकर 3.2MB तक कर दिया, जबकि सटीकता बनाए रखी। DLRM जैसे बड़े पैमाने पर अनुशंसा प्रणाली में, CoMERA ने मॉडल को 99 गुना संकुचित किया और चरम मेमोरी उपयोग को 7 गुना कम किया। यह ढाँचा पूर्व-प्रशिक्षित CodeBERT (एक विशिष्ट क्षेत्र का बड़ा भाषा मॉडल) में भी उत्कृष्ट प्रदर्शन करता है, 4.23 गुना की समग्र संकुचन अनुपात प्राप्त करता है और कुछ प्रशिक्षण चरणों में 2 गुना तेजी हासिल करता है। ये परिणाम विभिन्न कार्यों और आर्किटेक्चर को संभालने की इसकी क्षमता को उजागर करते हैं, जिससे इसके विभिन्न क्षेत्रों में अनुप्रयोग का विस्तार होता है।

CoMERA ढांचे के प्रमुख लाभों का सारांश

इस अध्ययन के प्रमुख निष्कर्ष इस प्रकार हैं:

CoMERA ने विशिष्ट स्तरों के लिए 361 गुना तक का संकुचन अनुपात प्राप्त किया, जबकि पूरे मॉडल के लिए 99 गुना का संकुचन अनुपात प्राप्त किया, जिससे भंडारण और मेमोरी की आवश्यकताएँ काफी कम हो गईं।

इस ढाँचे ने Transformer और अनुशंसा प्रणालियों के प्रत्येक प्रशिक्षण चक्र के समय को 2-3 गुना कम किया, जिससे गणना संसाधनों और समय की बचत हुई।

टेन्सर प्रतिनिधित्व और CUDA ग्राफ का उपयोग करके, CoMERA ने चरम मेमोरी खपत को 7 गुना कम किया, जिससे छोटे GPU पर प्रशिक्षण संभव हो गया।

CoMERA की विधि Transformer और बड़े भाषा मॉडल सहित कई आर्किटेक्चर का समर्थन करती है, जबकि सटीकता को बनाए रखती या बढ़ाती है।

प्रशिक्षण के लिए आवश्यक ऊर्जा और संसाधनों को कम करके, CoMERA अधिक सतत AI प्रथाओं को बढ़ावा देने में मदद करता है और व्यापक दर्शकों को अत्याधुनिक मॉडल का उपयोग करने में सक्षम बनाता है।