एनवीडिया ने GB200 और B200 के लॉन्च के केवल 6 महीने बाद, एक नया GPU - GB300 और B300 पेश किया है। यह केवल एक मामूली अपग्रेड की तरह लग सकता है, लेकिन वास्तव में इसमें बड़े बदलावों की संभावनाएं हैं, विशेष रूप से इनफेरेंस मॉडल के प्रदर्शन में उल्लेखनीय सुधार, जो पूरी उद्योग पर गहरा प्रभाव डालेगा।

B300/GB300: इनफेरेंस प्रदर्शन में बड़ा उछाल

B300 GPU ताइवान सेमीकंडक्टर 4NP प्रक्रिया नोड का उपयोग करता है, जो कंप्यूटिंग चिप्स के लिए अनुकूलित डिज़ाइन है। इससे B300 का FLOPS प्रदर्शन B200 की तुलना में 50% बढ़ गया है। कुछ प्रदर्शन वृद्धि TDP में वृद्धि से आई है, GB300 और B300HGX के TDP क्रमशः 1.4KW और 1.2KW तक पहुंच गए हैं (जबकि GB200 और B200 के लिए ये क्रमशः 1.2KW और 1KW हैं)। शेष प्रदर्शन वृद्धि आर्किटेक्चर के सुधार और सिस्टम स्तर के अनुकूलन से आई है, जैसे कि CPU और GPU के बीच गतिशील पावर आवंटन।

FLOPS के सुधार के अलावा, मेमोरी को 12-Hi HBM3E में अपग्रेड किया गया है, जिससे प्रत्येक GPU की HBM क्षमता 288GB तक बढ़ गई है। हालाँकि, पिन स्पीड अपरिवर्तित रही है, इसलिए प्रत्येक GPU की मेमोरी बैंडविड्थ अभी भी 8TB/s है। यह ध्यान देने योग्य है कि सैमसंग GB200 या GB300 की सप्लाई चेन में प्रवेश करने में असफल रहा है।

इसके अलावा, एनवीडिया ने मूल्य निर्धारण में भी समायोजन किया है। इससे Blackwell उत्पादों की लाभप्रदता पर कुछ हद तक प्रभाव पड़ेगा, लेकिन महत्वपूर्ण बात यह है कि B300/GB300 के प्रदर्शन में सुधार मुख्य रूप से इनफेरेंस मॉडल में देखा जाएगा।

इनफेरेंस मॉडल के लिए विशेष रूप से डिज़ाइन किया गया

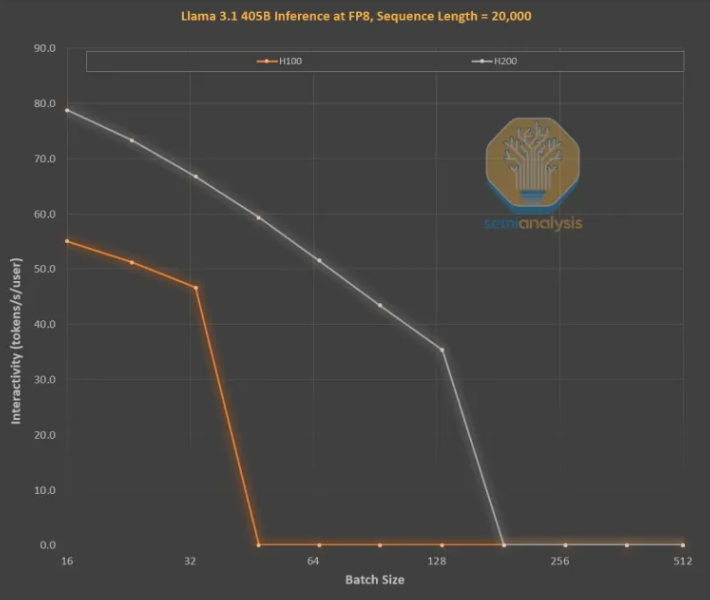

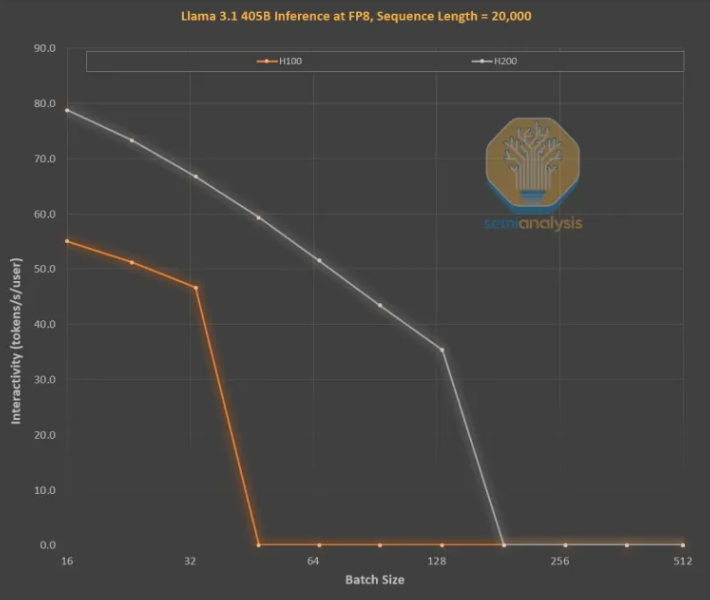

मेमोरी में सुधार OpenAI O3 शैली के LLM इनफेरेंस प्रशिक्षण के लिए महत्वपूर्ण है, क्योंकि लंबे अनुक्रम KVCache को बढ़ाते हैं, जिससे कुंजी बैच आकार और विलंबता सीमित होती है। H100 से H200 के अपग्रेड (मुख्य रूप से मेमोरी में वृद्धि) ने निम्नलिखित दो सुधार लाए हैं:

उच्च मेमोरी बैंडविड्थ (H200 के लिए 4.8TB/s, H100 के लिए 3.35TB/s) ने सभी तुलनीय बैच आकारों के इंटरैक्टिविटी में 43% की वृद्धि की है।

चूंकि H200 चलाने का बैच आकार H100 की तुलना में बड़ा है, प्रति सेकंड उत्पन्न होने वाले टोकन की संख्या 3 गुना बढ़ गई है, लागत लगभग 3 गुना कम हो गई है। यह अंतर मुख्य रूप से KVCache द्वारा कुल बैच आकार को सीमित करने के कारण है।

बड़ी मेमोरी क्षमता का प्रदर्शन में सुधार पर बड़ा प्रभाव है। दोनों GPUs के बीच प्रदर्शन और आर्थिक अंतर उनके पैरामीटर स्पेसिफिकेशनों से कहीं अधिक है:

इनफेरेंस मॉडल का उपयोगकर्ता अनुभव खराब हो सकता है, क्योंकि अनुरोध और प्रतिक्रिया के बीच स्पष्ट प्रतीक्षा समय होता है। यदि इनफेरेंस समय को उल्लेखनीय रूप से तेज किया जा सके, तो उपयोगकर्ताओं की उपयोग करने की इच्छा और भुगतान करने की इच्छा बढ़ेगी।

मेमोरी अपग्रेड के माध्यम से हार्डवेयर द्वारा 3 गुना प्रदर्शन वृद्धि हासिल करना अद्भुत है, जो मोर के कानून, ह्वांग के कानून या हमने देखी गई किसी अन्य हार्डवेयर सुधार की गति से कहीं अधिक है।

सबसे शक्तिशाली मॉडल उन मॉडल्स की तुलना में कहीं अधिक प्रीमियम चार्ज कर सकते हैं जिनका प्रदर्शन थोड़ा कम होता है। अग्रणी मॉडल की ग्रॉस मार्जिन 70% से अधिक है, जबकि ओपन-सोर्स प्रतिस्पर्धा के पिछड़े मॉडल की लाभप्रदता 20% से कम है। इनफेरेंस मॉडल को केवल एक श्रृंखला विचार नहीं करना चाहिए। खोज कार्य को प्रदर्शन में सुधार के लिए विस्तारित किया जा सकता है, जैसा कि O1Pro और O3 में किया गया है। इससे अधिक स्मार्ट मॉडल अधिक समस्याओं को हल कर सकते हैं और प्रत्येक GPU के लिए अधिक राजस्व उत्पन्न कर सकते हैं।

बेशक, एनवीडिया एकमात्र कंपनी नहीं है जो मेमोरी क्षमता बढ़ा सकती है। ASIC भी ऐसा कर सकते हैं, वास्तव में, AMD अधिक अनुकूल स्थिति में हो सकता है, क्योंकि इसके MI300X, MI325X और MI350X की मेमोरी क्षमता आमतौर पर एनवीडिया की तुलना में अधिक है, क्रमशः 192GB, 256GB और 288GB, लेकिन एनवीडिया के पास NVLink नामक एक गुप्त हथियार है।

NVL72 का महत्व इस तथ्य में निहित है कि यह 72 GPUs को एक ही समस्या पर सहयोग करने की अनुमति देता है, मेमोरी साझा करता है, और विलंबता बहुत कम है। दुनिया में कोई अन्य त्वरक पूरी इंटरकनेक्टिंग स्विचिंग क्षमता नहीं रखता।

एनवीडिया के GB200NVL72 और GB300NVL72 कई महत्वपूर्ण कार्यों को पूरा करने के लिए महत्वपूर्ण हैं:

उच्च इंटरैक्टिविटी, प्रत्येक विचार श्रृंखला की विलंबता को कम करती है।

72 GPUs KVCache को वितरित कर सकते हैं, जिससे लंबी विचार श्रृंखलाओं (बुद्धिमत्ता में वृद्धि) को प्राप्त किया जा सकता है।

बैच आकार की स्केलेबिलिटी सामान्य 8 GPU सर्वर से कहीं बेहतर है, जिससे लागत कम होती है।

एक ही समस्या पर काम करने के लिए अधिक सैंपल आकार सटीकता और मॉडल प्रदर्शन में सुधार करता है।

इसलिए, NVL72 की टोकनॉमिक्स 10 गुना से अधिक बढ़ गई है, विशेष रूप से लंबे इनफेरेंस श्रृंखलाओं पर। KVCache द्वारा मेमोरी का उपयोग आर्थिक प्रभाव के लिए घातक है, लेकिन NVL72 ही एकमात्र तरीका है जो इनफेरेंस की लंबाई को 100,000 से अधिक टोकन तक बढ़ा सकता है।

GB300: सप्लाई चेन का पुनर्निर्माण

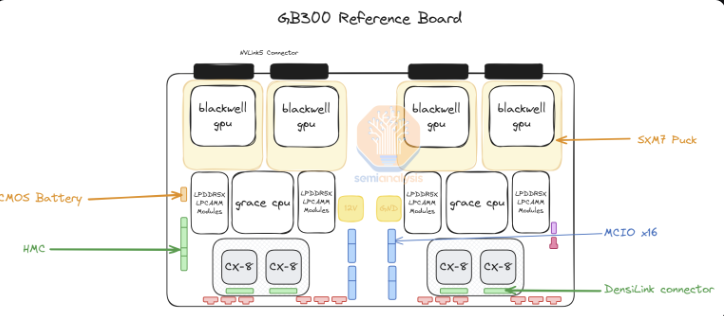

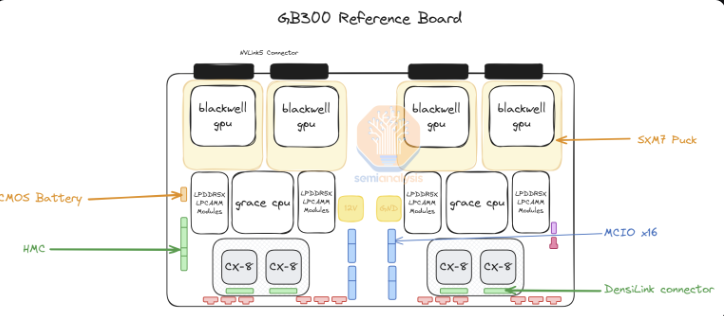

GB300 के लिए, एनवीडिया द्वारा प्रदान की गई सप्लाई चेन और सामग्री में बड़ा बदलाव आया है। GB200 के लिए, एनवीडिया ने पूरा बियान्का बोर्ड (जिसमें ब्लैकवेल GPU, ग्रेस CPU, 512GB LPDDR5X, VRM सामग्री) और स्विच पैलेट और कॉपर बैकप्लेट प्रदान किया।

GB300 के लिए, एनवीडिया केवल "SXM Puck" मॉड्यूल पर B300, BGA पैकेज वाले ग्रेस CPU, और HMC प्रदान करता है, जो अमेरिका की स्टार्टअप Axiado से आएगा, न कि GB200 के Aspeed से। अंतिम ग्राहक अब कंप्यूटिंग बोर्ड पर शेष घटकों की सीधी खरीद करेंगे, दूसरी स्तर की मेमोरी LPCAMM मॉड्यूल का उपयोग करेगी, न कि सॉल्ड LPDDR5X। Micron इन मॉड्यूल का प्रमुख सप्लायर बनेगा। स्विच पैलेट और कॉपर बैकप्लेट अपरिवर्तित रहेंगे, एनवीडिया पूरी तरह से इन घटकों की आपूर्ति करेगा।

सामने SXM Puck की ओर बढ़ने से अधिक OEM और ODM को कंप्यूटिंग पैलेट में भाग लेने का अवसर मिला है। पहले केवल Wistron और Foxconn बियान्का कंप्यूटिंग बोर्ड का निर्माण कर सकते थे, और अब अधिक OEM और ODM इसमें शामिल हो सकते हैं। Wistron ODM रूप में सबसे बड़ा हारने वाला है, क्योंकि उन्होंने बियान्का बोर्ड का हिस्सा खो दिया है। Foxconn के लिए, बियान्का बोर्ड के हिस्से की हानि उनके SXM Puck और SXM Puck स्लॉट के एकमात्र निर्माता होने के तथ्य से संतुलित हो जाती है। एनवीडिया Puck और स्लॉट के लिए अन्य सप्लायरों को शामिल करने की कोशिश कर रहा है, लेकिन अभी तक कोई अन्य आदेश नहीं दिया है।

एक और महत्वपूर्ण बदलाव VRM सामग्री है। जबकि SXM Puck पर कुछ VRM सामग्री है, अधिकांश ऑन-बोर्ड VRM सामग्री बड़े पैमाने पर कंपनियों/OEMs द्वारा सीधे VRM सप्लायर्स से खरीदी जाएगी। व्यापार मॉडल में बदलाव के कारण, Monolithic Power Systems बाजार हिस्सेदारी खो देगा।

एनवीडिया ने GB300 प्लेटफार्म पर 800G ConnectX-8NIC भी प्रदान किया है, जो InfiniBand और Ethernet पर दोगुनी स्केलेबिलिटी बैंडविड्थ प्रदान करता है। एनवीडिया ने पहले GB200 के ConnectX-8 को जटिलता के कारण और बियान्का बोर्ड पर PCIe Gen6 सक्षम करने से बचने के कारण रद्द कर दिया था।

ConnectX-8 में ConnectX-7 की तुलना में बड़े सुधार हुए हैं। इसमें न केवल 2 गुना बैंडविड्थ है, बल्कि इसमें 32 PCIe चैनलों के बजाय 48 PCIe चैनल भी हैं, जिससे अनूठी आर्किटेक्चर जैसे एयर-कूल MGX B300A को लागू किया जा सकता है। इसके अलावा, ConnectX-8 में SpectrumX क्षमताएं हैं, जबकि पहले के 400G उत्पादों में, SpectrumX को कम कुशल Bluefield3DPU की आवश्यकता थी।

GB300 का बड़े पैमाने पर कंपनियों पर प्रभाव

GB200 और GB300 की विलंबता का बड़े पैमाने पर कंपनियों पर प्रभाव का मतलब है कि कई आदेश जो Q3 से शुरू हो रहे थे, एनवीडिया के नए, महंगे GPU पर स्थानांतरित किए जाएंगे। पिछले सप्ताह तक, सभी बड़े पैमाने पर कंपनियों ने GB300 को अपनाने का निर्णय लिया है। इसका एक हिस्सा GB300 के उच्च प्रदर्शन के कारण है, लेकिन एक हिस्सा इस कारण से भी है कि वे अपनी किस्मत को नियंत्रित कर सकते हैं।

बड़े पैमाने पर कंपनियों को GB200 पर सर्वर स्तर पर अधिक बदलाव करने की अनुमति नहीं है, क्योंकि यह लॉन्च समय की चुनौतियों और रैक, शीतलन और पावर सप्लाई/घनत्व में महत्वपूर्ण परिवर्तनों के कारण है। इससे मेटा ने Broadcom और एनवीडिया से NIC के बहु-स्रोत की उम्मीद छोड़ दी, और पूरी तरह से एनवीडिया पर निर्भर हो गई। अन्य मामलों में, जैसे कि गूगल, उन्होंने आंतरिक NIC छोड़ दिए और केवल एनवीडिया का उपयोग करने का निर्णय लिया।

बड़े पैमाने पर कंपनियों के हजारों संगठनों के लिए जो CPU से लेकर नेटवर्क, फिर से स्क्रू और धातु की प्लेट तक सभी लागतों को अनुकूलित करने के लिए अभ्यस्त हैं, यह असाधारण है।

सबसे चौंकाने वाला उदाहरण अमेज़न है, जिन्होंने एक बहुत ही आदर्श कॉन्फ़िगरेशन का चयन किया है, जिसकी TCO संदर्भ डिजाइन की तुलना में खराब है। अमेज़न को PCIe स्विच और कम कुशल 200G लचीले ऑप्टिकल एडाप्टर NIC का उपयोग करने के कारण हवा-शीतलन की आवश्यकता होती है, इसलिए वे NVL72 रैक को मेटा, गूगल, माइक्रोसॉफ्ट, ओरेकल, X.AI और कोरवीव के समान तैनात नहीं कर सकते। अपने आंतरिक NIC के कारण, अमेज़न को NVL36 का उपयोग करने के लिए मजबूर होना पड़ा, जिससे उच्च बैकप्लेट और स्विच सामग्री के कारण प्रति GPU लागत भी अधिक हो गई। कुल मिलाकर, उनके अनुकूलन के प्रतिबंधों के कारण, अमेज़न की कॉन्फ़िगरेशन आदर्श नहीं है।

अब GB300 के साथ, बड़े पैमाने पर कंपनियों को मदरबोर्ड, शीतलन आदि के अधिक घटकों को अनुकूलित करने की अनुमति है। इससे अमेज़न को अपना कस्टम मदरबोर्ड बनाने की अनुमति मिली है, जो तरल-कूल्ड है और पहले हवा-कूल्ड घटकों को एकीकृत करता है, जैसे कि Astera Labs PCIe स्विच। जैसे-जैसे अधिक घटक तरल-कूल्ड होते हैं, और 25 की तीसरी तिमाही में अंततः K2V6400G NIC पर HVM को लागू किया जाता है, इसका मतलब है कि अमेज़न NVL72 आर्किटेक्चर में वापस आ सकता है और अपनी TCO में काफी सुधार कर सकता है।

हालांकि, बड़े पैमाने पर कंपनियों को अधिक सामग्री को डिज़ाइन, सत्यापित और पुष्टि करने की आवश्यकता है, यह सबसे बड़ा नुकसान है। यह आसानी से बड़े पैमाने पर कंपनियों द्वारा डिज़ाइन किए जाने वाले सबसे जटिल प्लेटफार्मों में से एक बन सकता है (गूगल के TPU सिस्टम को छोड़कर)। कुछ बड़े पैमाने पर कंपनियों को जल्दी डिज़ाइन करने में सक्षम होंगे, लेकिन अन्य टीमों के धीमी गति से चलने वाले कंपनियां पीछे रह जाएंगी। हालाँकि बाजार रिपोर्ट में रद्द करने की स्थिति है, लेकिन हमें लगता है कि माइक्रोसॉफ्ट धीमी डिज़ाइन गति के कारण GB300 को तैनात करने में सबसे धीमी कंपनियों में से एक है, वे अभी भी चौथी तिमाही में कुछ GB200 खरीद रहे हैं।

ग्राहकों द्वारा भुगतान की जाने वाली कुल मूल्य भिन्नता बहुत अधिक है, क्योंकि घटक एनवीडिया के लाभ ढेर से निकाले जा रहे हैं, ODM में स्थानांतरित हो रहे हैं। ODM की आय प्रभावित होती है, और सबसे महत्वपूर्ण बात यह है कि एनवीडिया की ग्रॉस मार्जिन पूरे वर्ष में बदल जाएगी।

संदर्भ: https://semianalysis.com/2024/12/25/nvidias-christmas-present-gb300-b300-reasoning-inference-amazon-memory-supply-chain/