हाल के वर्षों में, दृश्य बड़े मॉडल (Large Vision Language Models, LVLMs) ने छवि समझ और क्रॉस-मोडल कार्यों में असाधारण क्षमताएँ दिखाई हैं, लेकिन इसके साथ ही "भ्रमण की समस्या" भी बढ़ती जा रही है। इस चुनौती का सामना करने के लिए, ताओटियन समूह के भविष्य के जीवन प्रयोगशाला टीम ने "टोकन प्राथमिकता अनुकूलन" (Token Preference Optimization, संक्षेप में TPO) नामक एक नई विधि प्रस्तुत की है, और एक आत्म-समायोजित दृश्य एंकरिंग पुरस्कार तंत्र पेश किया है।

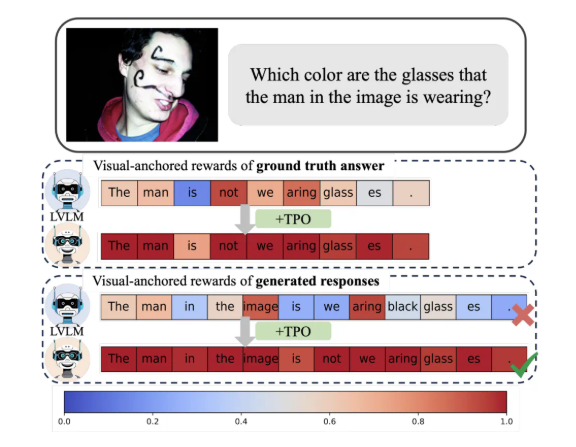

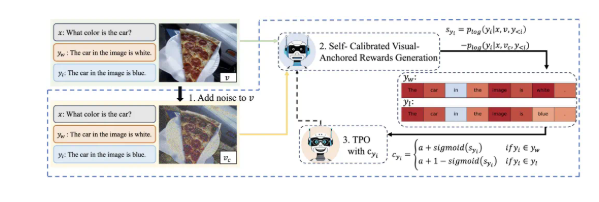

TPO का सबसे बड़ा नवाचार यह है कि यह स्वचालित रूप से टोकन-स्तरीय पुरस्कार संकेतों को लागू करता है। यह विधि स्वचालित रूप से प्राथमिकता डेटा में दृश्य एंकरिंग टोकन की पहचान कर सकती है, जिससे मैनुअल सूक्ष्म-लेबलिंग की जटिलता से बचा जा सकता है, जबकि प्रशिक्षण प्रक्रिया में प्रत्येक टोकन को दृश्य जानकारी के साथ इसकी निर्भरता के स्तर को दर्शाने वाले पुरस्कार दिए जाते हैं। यह आत्म-समायोजित दृश्य एंकरिंग पुरस्कार संकेत मॉडल की दृश्य जानकारी पर निर्भरता को अनुकूलित करने के लिए है, जिससे भ्रमण की घटनाओं को प्रभावी ढंग से कम किया जा सके।

अध्ययन से पता चलता है कि TPO का उपयोग करने वाले मॉडल कई परीक्षण मानकों में पारंपरिक विधियों की तुलना में महत्वपूर्ण रूप से बेहतर प्रदर्शन करते हैं, विशेष रूप से अधिक जटिल कार्यों में, मॉडल द्वारा उत्पन्न उत्तरों की निर्भरता छवि जानकारी पर बढ़ती जा रही है, न कि भाषा मॉडल के पूर्व ज्ञान पर। यह प्रगति न केवल मॉडल की समझने की क्षमता को बढ़ाती है, बल्कि आगे के अनुसंधान के लिए महत्वपूर्ण सैद्धांतिक आधार भी प्रदान करती है।

इसके अलावा, शोध टीम ने TPO के विभिन्न पैरामीटर सेटिंग्स पर एबलेशन प्रयोग किए, जिसमें पाया गया कि अनुकूलित शोर जोड़ने के चरण और पुरस्कार वितरण रणनीति मॉडल के प्रदर्शन को और बढ़ा सकते हैं। यह खोज निश्चित रूप से भविष्य के दृश्य बड़े मॉडल अनुसंधान और अनुप्रयोगों के लिए दिशा प्रदान करती है।

संक्षेप में, ताओटियन की यह नवोन्मेषी उपलब्धि मल्टी-मोडल संरेखण तकनीक के लिए नए दृष्टिकोण प्रदान करती है, और जीवन और उपभोक्ता क्षेत्रों में AI तकनीक के गहरे अनुप्रयोग को बढ़ावा देती है।