2025年1月20日,DeepSeek ने अपने पहले मजबूत शिक्षण (RL) द्वारा प्रशिक्षित निष्कर्ष मॉडल DeepSeek-R1 की घोषणा की, जो कई निष्कर्ष बेंचमार्क परीक्षणों में OpenAI-o1-1217 के समान प्रदर्शन प्राप्त करता है। DeepSeek-R1, DeepSeek-V3-Base मॉडल पर आधारित है, और निष्कर्ष क्षमता को बढ़ाने के लिए बहु-चरण प्रशिक्षण और ठंडे प्रारंभ डेटा का उपयोग करता है।

DeepSeek के शोधकर्ताओं ने सबसे पहले DeepSeek-R1-Zero विकसित किया, जो एक ऐसा मॉडल है जिसे बड़े पैमाने पर मजबूत शिक्षण द्वारा प्रशिक्षित किया गया है, बिना किसी पर्यवेक्षित सूक्ष्म समायोजन के पूर्व चरण के। DeepSeek-R1-Zero ने निष्कर्ष बेंचमार्क परीक्षणों में उत्कृष्ट प्रदर्शन दिखाया, जैसे कि AIME2024 परीक्षा में, इसका pass@1 स्कोर 15.6% से बढ़कर 71.0% हो गया।हालांकि, DeepSeek-R1-Zero में कुछ समस्याएँ भी थीं, जैसे कि पढ़ने में कठिनाई और भाषा का मिश्रण।

इन समस्याओं को हल करने और निष्कर्ष प्रदर्शन को और बढ़ाने के लिए, DeepSeek टीम ने DeepSeek-R1 विकसित किया। DeepSeek-R1 ने मजबूत शिक्षण से पहले बहु-चरण प्रशिक्षण और ठंडे प्रारंभ डेटा को पेश किया। विशेष रूप से, शोधकर्ताओं ने पहले हजारों ठंडे प्रारंभ डेटा को DeepSeek-V3-Base मॉडल को सूक्ष्म समायोजित करने के लिए इकट्ठा किया। फिर, उन्होंने DeepSeek-R1-Zero को प्रशिक्षित करने के समान निष्कर्ष-उन्मुख मजबूत शिक्षण किया। जब मजबूत शिक्षण प्रक्रिया लगभग संकुचन के करीब पहुंच गई, तो उन्होंने मजबूत शिक्षण चेकपॉइंट से अस्वीकृति नमूनाकरण करके नए पर्यवेक्षित सूक्ष्म समायोजन डेटा बनाए, और लेखन, तथ्य प्रश्नोत्तरी और आत्म-ज्ञान जैसे क्षेत्रों में DeepSeek-V3 के पर्यवेक्षित डेटा के साथ मिलाकर DeepSeek-V3-Base मॉडल को फिर से प्रशिक्षित किया। अंत में, सभी परिदृश्यों के संकेतों का उपयोग करके सूक्ष्म समायोजित चेकपॉइंट पर अतिरिक्त मजबूत शिक्षण किया गया।

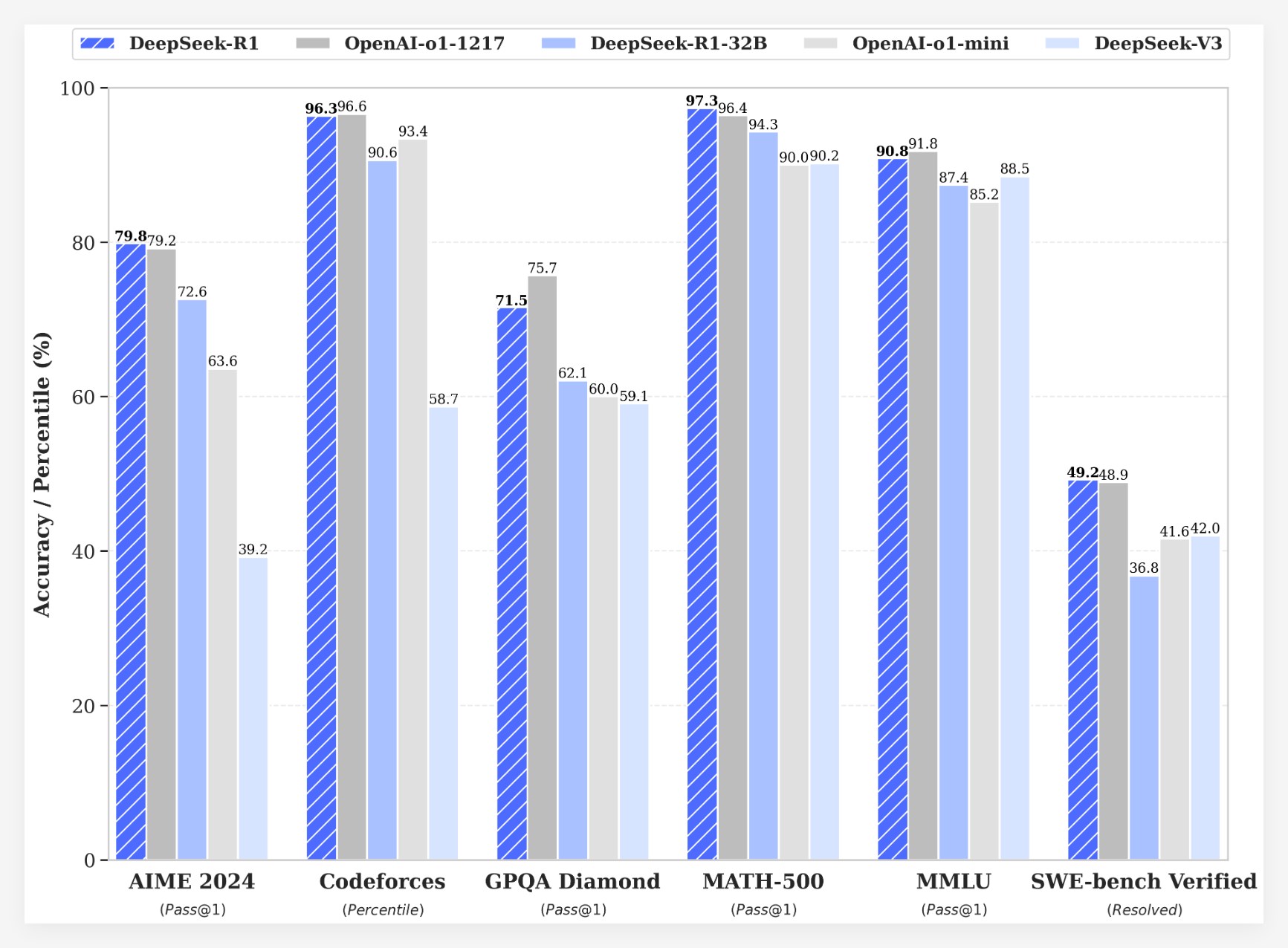

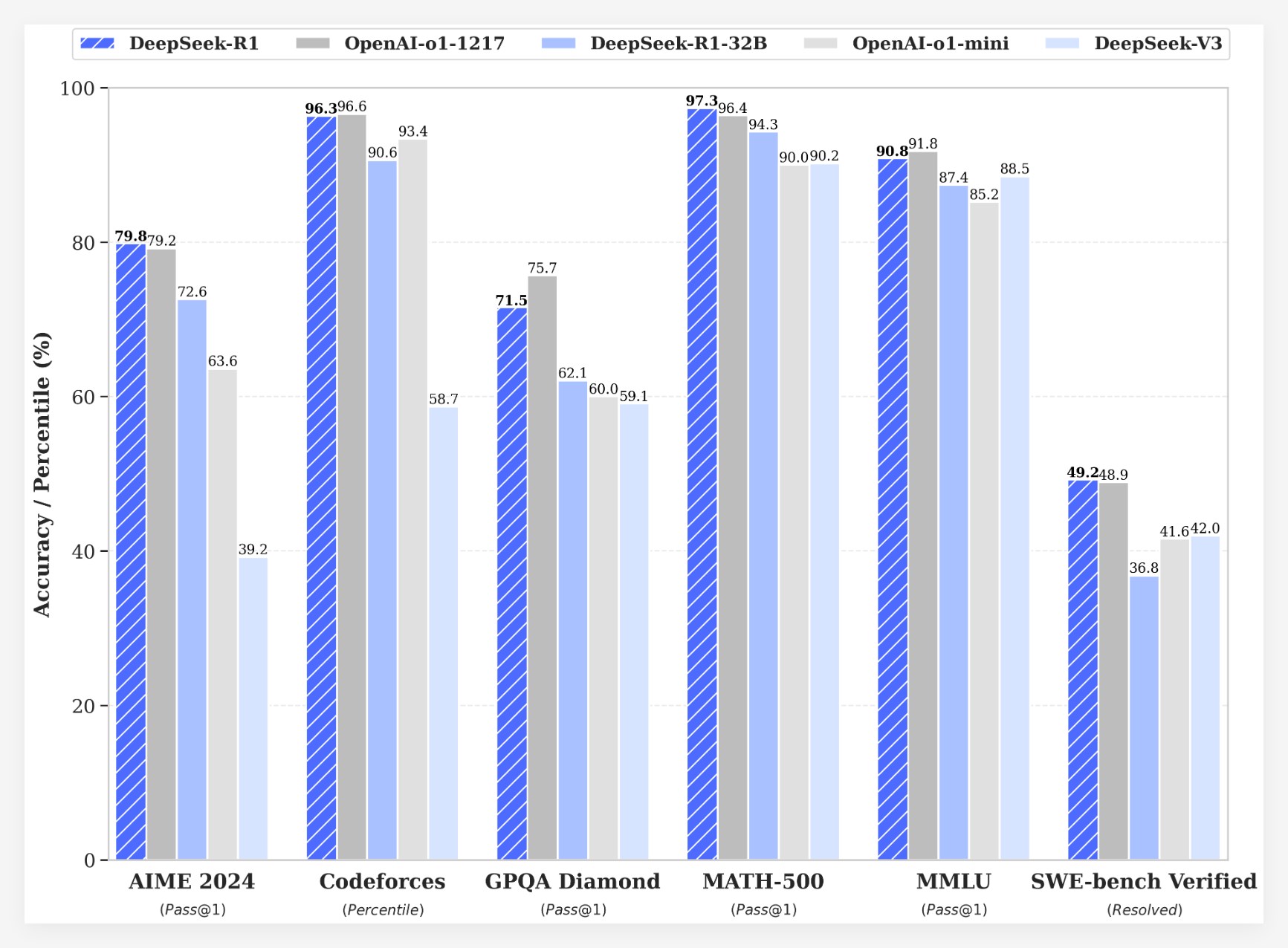

DeepSeek-R1 ने कई बेंचमार्क परीक्षणों में उल्लेखनीय परिणाम प्राप्त किए:

• AIME2024 परीक्षा में, DeepSeek-R1 का pass@1 स्कोर 79.8% तक पहुंच गया, जो OpenAI-o1-1217 से थोड़ा अधिक है।

• MATH-500 परीक्षा में, DeepSeek-R1 का pass@1 स्कोर 97.3% तक पहुंच गया, जो OpenAI-o1-1217 के बराबर है।

• कोड प्रतियोगिता कार्यों में, DeepSeek-R1 ने Codeforces पर 2029 का Elo रेटिंग प्राप्त किया, जो 96.3% मानव प्रतियोगियों से अधिक है।

• ज्ञान बेंचमार्क परीक्षणों (जैसे MMLU, MMLU-Pro और GPQA Diamond) में, DeepSeek-R1 के स्कोर क्रमशः 90.8%, 84.0% और 71.5% थे, जो DeepSeek-V3 से काफी बेहतर है।

• अन्य कार्यों (जैसे रचनात्मक लेखन, सामान्य प्रश्नोत्तरी, संपादन, सारांश आदि) में, DeepSeek-R1 ने भी उत्कृष्ट प्रदर्शन किया।

इसके अलावा, DeepSeek ने DeepSeek-R1 की निष्कर्ष क्षमता को छोटे मॉडलों में डिस्टिल करने का भी अन्वेषण किया। अनुसंधान से पता चला है कि DeepSeek-R1 से सीधे डिस्टिल करना छोटे मॉडलों पर मजबूत शिक्षण लागू करने की तुलना में बेहतर परिणाम देता है। यह दर्शाता है कि बड़े मूल मॉडल द्वारा खोजे गए निष्कर्ष पैटर्न निष्कर्ष क्षमता को बढ़ाने के लिए महत्वपूर्ण हैं।DeepSeek ने DeepSeek-R1-Zero, DeepSeek-R1 और Qwen और Llama पर आधारित DeepSeek-R1 से डिस्टिल किए गए छह घनत्व मॉडल (1.5B, 7B, 8B, 14B, 32B, 70B) को ओपन-सोर्स किया है। DeepSeek-R1 की लॉन्चिंग ने बड़े भाषा मॉडल की निष्कर्ष क्षमता को बढ़ाने में मजबूत शिक्षण की महत्वपूर्ण प्रगति को दर्शाया।

लागत लाभ

लागत के मामले में, DeepSeek-R1 अत्यधिक प्रतिस्पर्धी मूल्य निर्धारण रणनीति प्रदान करता है। इसकी API एक्सेस मूल्य निर्धारण प्रति मिलियन इनपुट टोकन के लिए 0.14 डॉलर (कैश हिट) और 0.55 डॉलर (कैश मिस), और आउटपुट टोकन प्रति मिलियन 2.19 डॉलर है। यह मूल्य निर्धारण रणनीति अन्य समान उत्पादों की तुलना में अधिक आकर्षक है, और उपयोगकर्ताओं द्वारा इसे "गेम चेंजर" के रूप में वर्णित किया गया है। वर्तमान में आधिकारिक वेबसाइट और API अब ऑनलाइन हैं! DeepThink का अनुभव करने के लिए https://chat.deepseek.com पर जाएं!

समुदाय की प्रतिक्रिया और भविष्य की दृष्टि

DeepSeek-R1 की लॉन्चिंग ने समुदाय में गर्म चर्चा को जन्म दिया। कई उपयोगकर्ताओं ने मॉडल के ओपन-सोर्स विशेषताओं और लागत लाभों की प्रशंसा की, यह मानते हुए कि यह डेवलपर्स को अधिक विकल्प और स्वतंत्रता प्रदान करता है। हालांकि, कुछ उपयोगकर्ताओं ने मॉडल की संदर्भ विंडो के आकार पर सवाल उठाए, और भविष्य के संस्करणों में और अधिक अनुकूलन की आशा की।

DeepSeek टीम ने कहा कि वे मॉडल के प्रदर्शन और उपयोगकर्ता अनुभव को बढ़ाने के लिए निरंतर प्रयास करेंगे, और भविष्य में अधिक सुविधाएँ पेश करने की योजना बना रहे हैं, जिसमें उन्नत डेटा विश्लेषण शामिल है, ताकि उपयोगकर्ताओं की AGI (सामान्य कृत्रिम बुद्धिमत्ता) की अपेक्षाओं को पूरा किया जा सके।