हाल ही में, माइक्रोसॉफ्ट अनुसंधान टीम ने कई विश्वविद्यालयों के शोधकर्ताओं के साथ मिलकर "Magma" नामक एक मल्टी-मोडल एआई मॉडल लॉन्च किया है। इस मॉडल का डिज़ाइन विभिन्न डेटा प्रकारों जैसे कि चित्र, पाठ और वीडियो को संसाधित और एकीकृत करने के लिए किया गया है, ताकि डिजिटल और भौतिक वातावरण में जटिल कार्यों को निष्पादित किया जा सके। प्रौद्योगिकी की निरंतर प्रगति के साथ, मल्टी-मोडल एआई एजेंटों का व्यापक रूप से रोबोटिक्स, वर्चुअल सहायक और उपयोगकर्ता इंटरफ़ेस स्वचालन के क्षेत्रों में उपयोग किया जा रहा है।

पूर्व के एआई सिस्टम आमतौर पर दृश्य-भाषा समझ या रोबोट संचालन पर केंद्रित होते थे, और इन दोनों क्षमताओं को एक एकीकृत मॉडल में संयोजित करना कठिन था। कई मौजूदा मॉडल विशेष क्षेत्रों में अच्छा प्रदर्शन करते हैं, लेकिन विभिन्न अनुप्रयोग परिदृश्यों में सामान्यीकरण क्षमता में कमी होती है। उदाहरण के लिए, Pix2Act और WebGUM मॉडल UI नेविगेशन में उत्कृष्ट हैं, जबकि OpenVLA और RT-2 रोबोट नियंत्रण के लिए अधिक उपयुक्त हैं, लेकिन उन्हें अक्सर अलग-अलग प्रशिक्षित करने की आवश्यकता होती है, जिससे डिजिटल और भौतिक वातावरण के बीच की सीमाएँ पार करना कठिन हो जाता है।

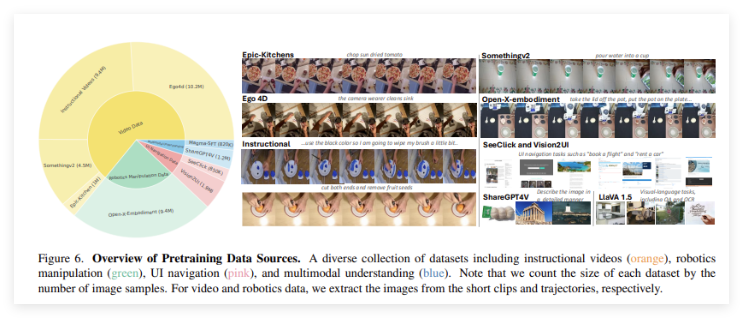

“Magma” मॉडल का लॉन्च इन सीमाओं को पार करने के लिए किया गया है। यह मल्टी-मोडल समझ, क्रिया स्थान निर्धारण और योजना क्षमताओं को एकीकृत करने के लिए एक शक्तिशाली प्रशिक्षण विधि का परिचय देता है, जिसका उद्देश्य एआई एजेंटों को विभिन्न वातावरणों में निर्बाध रूप से कार्य करने में सक्षम बनाना है। Magma के प्रशिक्षण डेटा सेट में 39 मिलियन नमूने शामिल हैं, जिनमें चित्र, वीडियो और रोबोट क्रिया पथ शामिल हैं। इसके अलावा, इस मॉडल ने दो नवोन्मेषी तकनीकों का उपयोग किया है: "लेबल सेट" (Set-of-Mark, SoM) और "पथ लेबल" (Trace-of-Mark, ToM)। पहला मॉडल को UI वातावरण में क्रियाशील दृश्य वस्तुओं को लेबल करने में सक्षम बनाता है, जबकि दूसरा इसे समय के साथ वस्तुओं की गति को ट्रैक करने में सक्षम बनाता है, जिससे भविष्य की क्रियाओं की योजना बनाने की क्षमता बढ़ती है।

“Magma” ने अपने प्रदर्शन को कई क्षेत्रों में अनुकूलित करने के लिए उन्नत गहरे शिक्षण आर्किटेक्चर और बड़े पैमाने पर पूर्व-प्रशिक्षण तकनीकों को अपनाया है। मॉडल चित्रों और वीडियो को संसाधित करने के लिए ConvNeXt-XXL दृश्य बैकबोन का उपयोग करता है, जबकि LLaMA-3-8B भाषा मॉडल पाठ इनपुट को संसाधित करने के लिए जिम्मेदार है। यह आर्किटेक्चर “Magma” को दृश्य, भाषा और क्रियान्वयन को प्रभावी ढंग से एकीकृत करने में सक्षम बनाता है। व्यापक प्रशिक्षण के बाद, मॉडल ने कई कार्यों में उत्कृष्ट परिणाम प्राप्त किए हैं, जो मजबूत मल्टी-मोडल समझ और स्थानिक तर्क क्षमता को दर्शाता है।

प्रोजेक्ट लिंक: https://microsoft.github.io/Magma/

मुख्य बिंदु:

🌟 Magma मॉडल ने 39 मिलियन से अधिक नमूनों के प्रशिक्षण के माध्यम से मजबूत मल्टी-मोडल शिक्षण क्षमता प्राप्त की है।

🤖 यह मॉडल दृश्य, भाषा और क्रियाओं को सफलतापूर्वक एकीकृत करता है, मौजूदा एआई मॉडलों की सीमाओं को पार करता है।

📈 Magma ने कई बेंचमार्क परीक्षणों में उत्कृष्ट प्रदर्शन किया है, जो मजबूत सामान्यीकरण क्षमता और उत्कृष्ट निर्णय निष्पादन क्षमता को दर्शाता है।