हाल ही में, VLM-R1 परियोजना की सफल लॉन्च ने इस क्षेत्र में नई उम्मीदें जगाई हैं। यह परियोजना DeepSeek टीम की R1 विधि का दृश्य भाषा मॉडल में सफल हस्तांतरण है, जिसका अर्थ है कि AI दृश्य सामग्री की समझ एक नए चरण में प्रवेश कर रही है।

VLM-R1 की प्रेरणा पिछले साल DeepSeek द्वारा ओपन-सोर्स की गई R1 विधि से मिली, जिसने GRPO (Generative Reward Processing Optimization) सुदृढीकरण शिक्षण तकनीक का उपयोग किया और शुद्ध पाठ प्रसंस्करण में उत्कृष्ट प्रदर्शन किया। अब, VLM-R1 टीम ने इस विधि को दृश्य भाषा मॉडल में सफलतापूर्वक लागू किया है, जो मल्टी-मोडल AI अनुसंधान के लिए नए अवसर खोलता है।

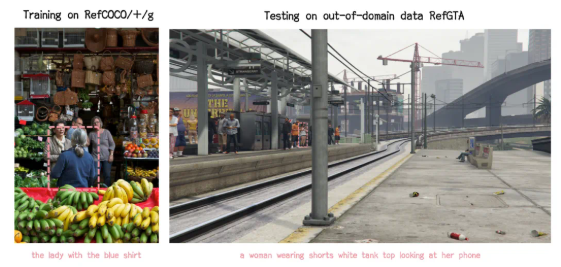

परियोजना के सत्यापन परिणामों में, VLM-R1 का प्रदर्शन आश्चर्यजनक है। सबसे पहले, R1 विधि जटिल परिदृश्यों में अत्यधिक स्थिरता प्रदर्शित करती है, जो वास्तविक अनुप्रयोगों में विशेष रूप से महत्वपूर्ण है। दूसरी बात, इस मॉडल ने सामान्यीकरण क्षमता में उत्कृष्टता दिखाई। तुलना प्रयोगों में, पारंपरिक SFT (Supervised Fine-Tuning) मॉडल के प्रशिक्षण चरणों की संख्या बढ़ने के साथ, इसकी प्रदर्शन धीरे-धीरे गिर गई, जबकि R1 मॉडल ने प्रशिक्षण के दौरान लगातार सुधार किया। यह दर्शाता है कि R1 विधि ने मॉडल को दृश्य सामग्री की समझ की क्षमता सिखाई है, न कि केवल स्मृति पर निर्भरता।

इसके अलावा, VLM-R1 परियोजना का उपयोग करना बेहद आसान है, टीम ने डेवलपर्स के लिए एक संपूर्ण प्रशिक्षण और मूल्यांकन प्रक्रिया प्रदान की है, जिससे डेवलपर्स जल्दी से शुरू कर सकते हैं। एक वास्तविक मामले में, मॉडल से एक समृद्ध भोजन की छवि में प्रोटीन सामग्री वाले खाद्य पदार्थ को खोजने के लिए कहा गया, परिणाम न केवल सटीक था, बल्कि उसने प्रोटीन सामग्री वाले सबसे अधिक अंडे के पकोड़े को छवि में सटीक रूप से फ्रेम में भी दिखाया, जो इसकी उत्कृष्ट दृश्य समझ और तर्क क्षमताओं को प्रदर्शित करता है।

VLM-R1 की सफल लॉन्च न केवल R1 विधि की सामान्यता को प्रमाणित करती है, बल्कि मल्टी-मोडल मॉडल के प्रशिक्षण के लिए नए दृष्टिकोण भी प्रदान करती है, जो एक नए दृश्य भाषा मॉडल प्रशिक्षण प्रवृत्ति की शुरुआत का संकेत देती है। और भी उत्साहजनक बात यह है कि यह परियोजना पूरी तरह से ओपन-सोर्स है, रुचि रखने वाले डेवलपर्स GitHub पर संबंधित सामग्री प्राप्त कर सकते हैं।

संक्षेप में, VLM-R1 का आगमन दृश्य भाषा मॉडल अनुसंधान में नई ऊर्जा का संचार करता है, और हम आशा करते हैं कि अधिक डेवलपर्स इसमें भाग लेंगे, जिससे मल्टी-मोडल AI तकनीक की निरंतर प्रगति को बढ़ावा मिलेगा।