अलीबाबा के क्वेन टीम ने हाल ही में अपने नवीनतम ओपन-सोर्स बड़े भाषा मॉडल (LLM) परिवार के सदस्य - क्यूडब्ल्यूक्यू-32B को लॉन्च किया है। यह 32 अरब पैरामीटर वाला एक अनुमान मॉडल है, जिसका उद्देश्य जटिल समस्या-समाधान कार्यों में प्रदर्शन को बेहतर बनाने के लिए प्रबलित शिक्षा (RL) का उपयोग करना है।

जैसा कि बताया गया है, क्यूडब्ल्यूक्यू-32B को हगिंग फेस और मॉडलस्कोप पर Apache2.0 लाइसेंस के तहत ओपन-सोर्स किया गया है। इसका मतलब है कि इस मॉडल का उपयोग व्यावसायिक और शोध उद्देश्यों के लिए किया जा सकता है, और कंपनियां इसे सीधे अपने उत्पादों और अनुप्रयोगों में लागू कर सकती हैं, जिसमें भुगतान वाली सेवाएं भी शामिल हैं। व्यक्तिगत उपयोगकर्ता क्वेन चैट के माध्यम से भी इस मॉडल तक पहुँच सकते हैं।

क्यूडब्ल्यूक्यू, जिसका पूरा नाम क्वेन-विद-क्वेश्चंस है, अलीबाबा द्वारा नवंबर 2024 में पहली बार लॉन्च किया गया ओपन-सोर्स अनुमान मॉडल है, जिसका लक्ष्य ओपनएआई के o1-प्रिव्यू के साथ प्रतिस्पर्धा करना है। प्रारंभिक क्यूडब्ल्यू ने तार्किक तर्क और योजना क्षमताओं को बढ़ाने के लिए अपने उत्तरों की समीक्षा और सुधार करके अनुमान प्रक्रिया में सुधार किया, विशेष रूप से गणित और कोडिंग कार्यों में उत्कृष्ट प्रदर्शन किया।

पिछले क्यूडब्ल्यू में 32 अरब पैरामीटर और 32,000 टोकन का संदर्भ लंबाई थी, और इसने AIME और MATH जैसे गणितीय बेंचमार्क और GPQA जैसे वैज्ञानिक तर्क कार्यों में o1-प्रिव्यू को पीछे छोड़ दिया। हालाँकि, क्यूडब्ल्यू का प्रारंभिक संस्करण LiveCodeBench जैसे प्रोग्रामिंग बेंचमार्क में अपेक्षाकृत कमजोर प्रदर्शन करता था, और भाषा मिश्रण और कभी-कभी परिपत्र तर्क जैसी चुनौतियों का सामना करना पड़ता था।

इसके बावजूद, अलीबाबा ने इस मॉडल को Apache2.0 लाइसेंस के तहत जारी किया, जिससे यह ओपनएआई के o1 जैसे मालिकाना विकल्पों से अलग हो गया, जिससे डेवलपर्स और कंपनियों को अनुकूलन और व्यावसायीकरण करने की स्वतंत्रता मिली। एआई क्षेत्र के विकास के साथ, पारंपरिक LLM की सीमाएँ तेजी से स्पष्ट होती जा रही हैं, बड़े पैमाने पर विस्तार से होने वाला प्रदर्शन में सुधार धीमा हो रहा है, जिससे बड़े अनुमान मॉडल (LRM) में रुचि बढ़ रही है। LRM सटीकता में सुधार के लिए अनुमान के समय अनुमान और आत्म-प्रतिबिंब का उपयोग करते हैं, जैसे कि ओपनएआई का o3 श्रृंखला और DeepSeek-R1।

नवीनतम क्यूडब्ल्यूक्यू-32B ने प्रबलित शिक्षा और संरचित आत्म-प्रश्नोत्तर को एकीकृत करके प्रदर्शन में और सुधार किया है, जिसका उद्देश्य अनुमान एआई क्षेत्र में एक महत्वपूर्ण प्रतियोगी बनना है। क्यूडब्ल्यूक्यू टीम के शोध से पता चलता है कि प्रबलित शिक्षा मॉडल की जटिल समस्याओं को हल करने की क्षमता को काफी बढ़ा सकती है। क्यूडब्ल्यूक्यू-32B ने गणितीय तर्क, कोडिंग क्षमताओं और सामान्य समस्या-समाधान क्षमताओं को बढ़ाने के लिए बहु-चरणीय प्रबलित शिक्षा प्रशिक्षण विधि का उपयोग किया है।

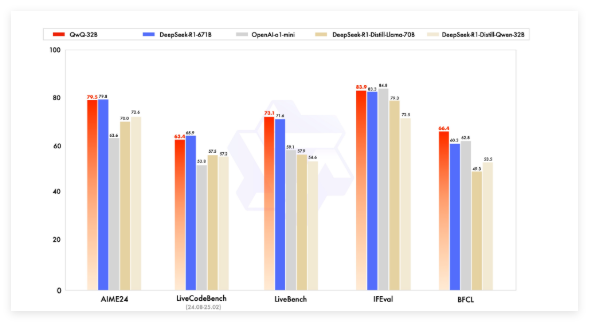

बेंचमार्क परीक्षणों में, क्यूडब्ल्यूक्यू-32B ने DeepSeek-R1, o1-mini और DeepSeek-R1-Distilled-Qwen-32B जैसे अग्रणी मॉडल के साथ प्रतिस्पर्धा की, और कुछ प्रतिस्पर्धियों की तुलना में कम पैरामीटर के साथ प्रतिस्पर्धी परिणाम प्राप्त किए। उदाहरण के लिए, DeepSeek-R1 में 671 अरब पैरामीटर (370 अरब सक्रिय) हैं, जबकि क्यूडब्ल्यूक्यू-32B समान प्रदर्शन के साथ कम मेमोरी की आवश्यकता रखता है, आमतौर पर GPU पर 24GB vRAM की आवश्यकता होती है, जबकि पूर्ण DeepSeek R1 को चलाने के लिए 1500GB से अधिक vRAM की आवश्यकता होती है।

क्यूडब्ल्यूक्यू-32B ने कारण भाषा मॉडल आर्किटेक्चर का उपयोग किया है और कई अनुकूलन किए हैं, जिसमें 64 ट्रांसफॉर्मर परतें, RoPE, SwiGLU, RMSNorm और ध्यान QKV पूर्वाग्रह शामिल हैं। इसने सामान्यीकृत क्वेरी ध्यान (GQA) का भी उपयोग किया है, जिसमें 131,072 टोकन की विस्तारित संदर्भ लंबाई है, और इसमें पूर्व-प्रशिक्षण, पर्यवेक्षित ठीक-ठीक और प्रबलित शिक्षा सहित बहु-चरणीय प्रशिक्षण शामिल है।

क्यूडब्ल्यूक्यू-32B की प्रबलित शिक्षा प्रक्रिया दो चरणों में विभाजित है: पहले गणित और कोडिंग क्षमताओं पर ध्यान केंद्रित किया जाता है, सटीकता सत्यापक और कोड निष्पादन सर्वर का उपयोग करके प्रशिक्षण दिया जाता है। दूसरा चरण सामान्य पुरस्कार मॉडल और नियम-आधारित सत्यापक का उपयोग करके पुरस्कार प्रशिक्षण के माध्यम से किया जाता है, ताकि निर्देशों का पालन, मानव संरेखण और एजेंट अनुमान क्षमताओं में सुधार किया जा सके, जबकि इसकी गणित और कोडिंग क्षमताओं को प्रभावित न किया जाए।

क्यूडब्ल्यूक्यू-32B में एजेंटिक क्षमताएँ भी हैं, जो पर्यावरण प्रतिक्रिया के अनुसार अनुमान प्रक्रिया को गतिशील रूप से समायोजित कर सकती हैं। क्वेन टीम ने सर्वोत्तम प्रदर्शन के लिए विशिष्ट अनुमान सेटिंग्स का उपयोग करने का सुझाव दिया है और vLLM का उपयोग करके परिनियोजन का समर्थन करता है।

क्वेन टीम क्यूडब्ल्यूक्यू-32B को प्रबलित शिक्षा का उपयोग करके अनुमान क्षमताओं को बढ़ाने के पहले कदम के रूप में देखती है, भविष्य में प्रबलित शिक्षा के विस्तार, एजेंटों और प्रबलित शिक्षा को एकीकृत करने के लिए दीर्घकालिक अनुमान को प्राप्त करने और प्रबलित शिक्षा के लिए अनुकूलित आधार मॉडल का निरंतर विकास करने की योजना है, अंततः सामान्य कृत्रिम बुद्धिमत्ता (AGI) की ओर अग्रसर होना।

मॉडल:https://qwenlm.github.io/blog/qwq-32b/

मुख्य बातें:

🚀 अलीबाबा ने ओपन-सोर्स अनुमान बड़ा मॉडल क्यूडब्ल्यूक्यू-32B लॉन्च किया है, जो प्रबलित शिक्षा तकनीक का उपयोग करता है, जिससे जटिल समस्याओं को हल करने की क्षमता में सुधार होता है।

💡 क्यूडब्ल्यूक्यू-32B गणित, प्रोग्रामिंग आदि बेंचमार्क परीक्षणों में बड़े पैरामीटर वाले मॉडल के बराबर प्रदर्शन करता है, और कम मेमोरी की आवश्यकता होती है, और इसे Apache2.0 लाइसेंस के तहत ओपन-सोर्स किया गया है, जिसका मुफ्त में व्यावसायिक उपयोग किया जा सकता है।

🧠 इस मॉडल में विस्तारित संदर्भ लंबाई (130,000 टोकन) और एजेंटिक क्षमताएँ हैं, और भविष्य में मॉडल की बुद्धिमत्ता को बेहतर बनाने में प्रबलित शिक्षा की क्षमता का पता लगाना जारी रहेगा।