11 मार्च को, टोंगयी प्रयोगशाला टीम ने आर1-ओमनी मॉडल को ओपन सोर्स करने की घोषणा की, जिससे बहु-मोडल मॉडल के विकास में एक नई सफलता मिली। यह मॉडल प्रबलित अधिगम और सत्यापन योग्य पुरस्कार (आरएलवीआर) विधि को जोड़ता है, जो बहु-मोडल भावना पहचान कार्यों में अनुमान क्षमता और सामान्यीकरण प्रदर्शन को बेहतर बनाने पर केंद्रित है।

आर1-ओमनी का प्रशिक्षण दो चरणों में विभाजित है। कोल्ड स्टार्ट चरण में, टीम ने 580 वीडियो डेटा वाले संयोजन डेटासेट का उपयोग करके माइक्रोट्यूनिंग की, जो एक्सप्लेनेबल मल्टीमॉडल इमोशन रीज़निंग (ईएमईआर) डेटासेट और ह्यूमनओमनी डेटासेट से प्राप्त हुए थे। इस चरण का उद्देश्य मॉडल के लिए बुनियादी अनुमान क्षमता स्थापित करना है, यह सुनिश्चित करना है कि आरएलवीआर चरण में प्रवेश करने से पहले इसमें एक निश्चित बहु-मोडल भावना पहचान क्षमता है, जिससे बाद के प्रशिक्षण की स्थिरता, दक्षता और स्थिरता सुनिश्चित हो सके।

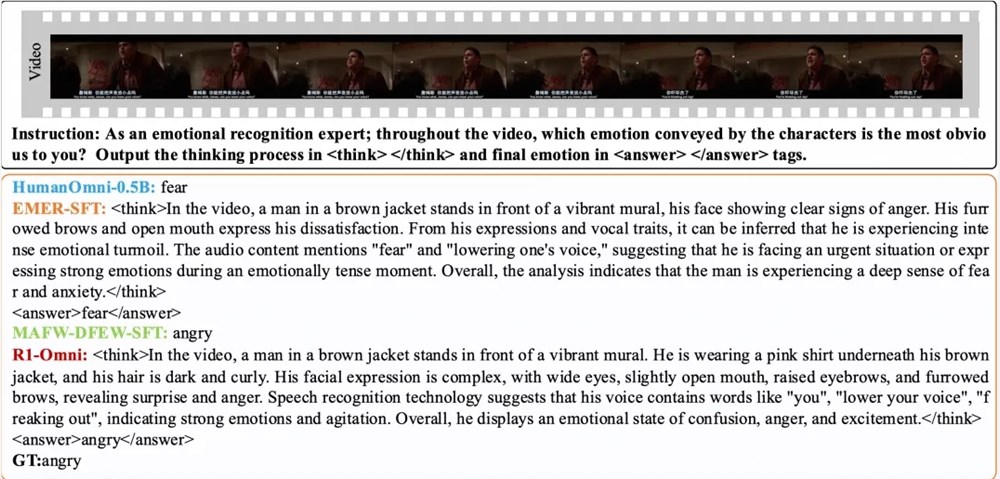

इसके बाद, आरएलवीआर चरण में, मॉडल को प्रबलित अधिगम और सत्यापन योग्य पुरस्कार तंत्र के माध्यम से और बेहतर बनाया गया है। इस चरण की कुंजी नीति मॉडल और पुरस्कार फ़ंक्शन है। नीति मॉडल वीडियो फ़्रेम और ऑडियो स्ट्रीम से बने बहु-मोडल इनपुट डेटा को संसाधित करता है, विस्तृत अनुमान प्रक्रिया के साथ संभावित प्रतिक्रियाएँ उत्पन्न करता है, यह दर्शाता है कि मॉडल दृश्य और श्रवण जानकारी को कैसे एकीकृत करता है ताकि भविष्यवाणी की जा सके। पुरस्कार फ़ंक्शन डीपसीक आर1 से प्रेरित है, जिसे सटीकता पुरस्कार और प्रारूप पुरस्कार में विभाजित किया गया है, जो एक साथ अंतिम पुरस्कार बनाते हैं, यह मॉडल को सही भविष्यवाणी उत्पन्न करने के लिए प्रोत्साहित करता है, और यह सुनिश्चित करता है कि आउटपुट संरचित और पूर्व निर्धारित प्रारूप के अनुरूप हो।

प्रयोग के परिणामों से पता चलता है कि आर1-ओमनी ने समान वितरण परीक्षण सेट डीएफईडब्ल्यू और एमएएफडब्ल्यू पर, मूल बेसलाइन मॉडल की तुलना में औसतन 35% से अधिक की वृद्धि की है, और पर्यवेक्षित माइक्रोट्यूनिंग (एसएफटी) मॉडल की तुलना में बिना भार वाले औसत रिकॉल (यूएआर) में 10% से अधिक की वृद्धि की है। विभिन्न वितरण परीक्षण सेट आरएवीडीईएसएस पर, इसके भारित औसत रिकॉल (डब्ल्यूएआर) और यूएआर में 13% से अधिक की वृद्धि हुई है, जो उत्कृष्ट सामान्यीकरण क्षमता प्रदर्शित करता है। इसके अलावा, आर1-ओमनी में एक उल्लेखनीय पारदर्शिता लाभ भी है, आरएलवीआर विधि के माध्यम से, मॉडल में ऑडियो और वीडियो जानकारी की भूमिका अधिक स्पष्ट रूप से दिखाई देती है, यह स्पष्ट रूप से दिखा सकती है कि विशिष्ट भावना निर्णय के लिए प्रत्येक मोडल जानकारी की महत्वपूर्ण भूमिका क्या है, मॉडल निर्णय प्रक्रिया और भविष्य के शोध को समझने के लिए एक महत्वपूर्ण संदर्भ प्रदान करता है।

पेपर:

https://arxiv.org/abs/2503.05379

गिथहब:

https://github.com/HumanMLLM/R1-Omni

मॉडल:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B