邢波团队提出全面开源LLM360倡议,推动大型语言模型透明训练

站长之家

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

近日,字节跳动豆包大模型团队宣布开源Multi-SWE-bench,这是业内首个多语言代码修复基准数据集,为大模型“自动修Bug”能力的评估与提升带来新突破。在大模型技术快速发展的当下,代码生成任务成为检验模型智能的关键领域。以SWE-bench为代表的代码修复基准,虽能衡量模型的编程智能,但存在明显局限。其仅聚焦Python语言,无法评估模型跨语言泛化能力;且任务难度有限,难以覆盖复杂开发场景,制约了大模型代码智能的进一步发展。面向不同模型代码能力评测分数Multi-SWE-bench应运而生

近日,开源AI界面框架Gradio发布了其5.24版本,这一更新因其全新设计的ImageEditor组件而引发了开发者社区的广泛热议。据AIbase了解,Gradio5.24将图像编辑功能提升至专业级别,新增了类似Photoshop的缩放与平移操作、完整的透明度控制以及自定义图层功能,为AI应用的图像处理能力注入了新的活力。这一升级被认为是开发者构建高质量图像编辑演示的重大突破。媲美专业软件:全新编辑体验Gradio5.24的ImageEditor组件彻底革新了以往的图像处理方式。新版本引入了类似Photoshop的缩放与平移功能,用户

近日,AI代码生成领域掀起了一波开源热潮,多款重量级模型接连亮相,其中Deep Cogito推出的Cogito v1Preview系列尤为引人注目。据AIbase了解,这一全新开源模型家族涵盖3B、8B、14B、32B和70B等多种规格,不仅在性能上全面超越同级别竞争者,其70B版本更是力压Meta最新发布的Llama4109B MoE模型,成为业界热议的焦点。这一系列模型的发布,不仅为开发者提供了强大的编程利器,也预示着AI技术在编码领域的全新突破。多规格覆盖,性能领跑行业Cogito v1Preview系列提供了从3亿到70亿参数的多种选择,满

近期,苹果公司在人工智能领域的新动态引起了广泛关注。根据彭博社记者马克・古尔曼的最新报道,苹果计划在即将推出的 iOS19系统中,显著增强其 “Apple Intelligence” 人工智能技术的应用范围。这一消息让业内人士对苹果未来的 AI 战略充满期待。据了解,苹果将向第三方开发者开放摘要生成 API 接口。这意味着,用户在多个场景中都能享受到 AI 带来的便利。例如,在群组聊天中,用户能够利用设备端的大型语言模型,自动获得对话摘要。这一功能尤其对忙碌的学生来说,将极大提高他

2025年4月9日,在拉斯维加斯举办的Google Cloud Next2025大会上,谷歌正式发布了Agent Development Kit(ADK),一款全新的开源智能体开发框架。这款基于Python的工具包旨在简化多智能体系统的构建、管理和部署流程,被视为AI代理开发领域的重大突破。ADK的发布不仅展示了谷歌在人工智能领域的雄心,也为全球开发者提供了一个灵活、高效的平台,推动AI技术在企业级应用中的落地。ADK的核心特性与技术优势ADK以其模块化设计和高度灵活性脱颖而出,适用于从简单任务到复杂多智能体协作的广泛场景

谷歌云正式宣布推出全新的开源协议Agent2Agent(A2A),旨在打破当前人工智能(AI)智能体之间的壁垒,实现不同厂商、不同框架构建的AI智能体之间的无缝协作与信息交换。这一举措标志着AI领域迈向更加开放、高效和智能的新时代。打破壁垒,实现智能体间的自由“对话”随着企业对自主AI智能体的部署日益增长,如何让这些智能体在复杂的企业环境中协同工作,处理跨系统、跨应用的日常或复杂任务,成为了提升生产力的关键。然而,由于缺乏统一的标准,不同智能体之间往往难以有效

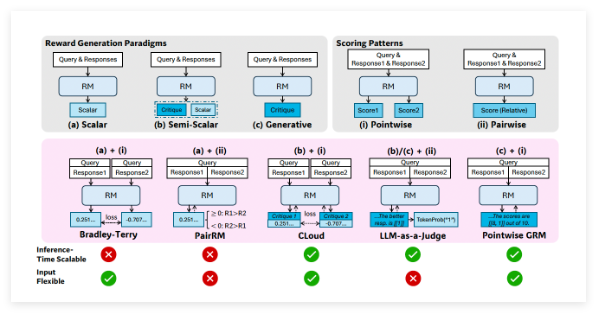

备受瞩目的中国人工智能研究实验室DeepSeek AI,继其强大的开源语言模型DeepSeek-R1之后,再次在大型语言模型(LLM)领域取得重大突破。近日,DeepSeek AI正式推出一项名为自主演原则的批判调优(Self-Principled Critique Tuning,简称SPCT)的创新技术,旨在构建更通用、更具扩展性的AI奖励模型(Reward Models,简称RMs)。这项技术有望显著提升AI在开放式任务和复杂环境中的理解和应对能力,为更智能的AI应用铺平道路。背景:奖励模型——强化学习的“指路明灯”在开发先进的LLM的过程中,强化学习(Reinfo

近日,一款名为“DeepCoder-14B”的全新AI模型正式亮相,这一由Agentica团队与合作伙伴共同打造的开源项目迅速引发了全球科技界的热议。作为一款专为编码推理设计的生成式AI模型,DeepCoder-14B以其卓越的性能跻身行业顶尖水平,据称可与OpenAI的o1和o3-mini相媲美。更令人振奋的是,研发团队不仅开放了模型本身,还一并发布了其完整数据集、源代码和训练方法,这一罕见的透明度为AI研究与开发注入了新的活力。DeepCoder-14B的核心亮点在于其强大的编码推理能力。该模型在设计之初便以解决复

2025年4月8日,英伟达(NVIDIA)宣布推出其最新大型语言模型(LLM)——Llama3.1Nemotron Ultra253B。这一模型基于Meta的Llama-3.1-405B-Instruct开发,通过创新的神经架构搜索(NAS)技术进行了深度优化,不仅在性能上超过了近期发布的Llama4系列中的Behemoth和Maverick,还以开源形式在Hugging Face平台上发布,引发了AI社区的广泛关注。性能突破:碾压Llama4Behemoth和Maverick根据英伟达官方披露的信息以及社交媒体上的最新讨论,Llama3.1Nemotron Ultra253B在多个关键基准测试中表现出色。这一模型拥有2530亿个参数,相较于Lla

2025年4月8日,英伟达推出Llama3.1Nemotron Ultra253B,这一基于Llama-3.1-405B优化的开源模型以253亿参数超越Meta的Llama4Behemoth和Maverick,成为AI领域焦点。该模型在GPQA-Diamond、AIME2024/25及LiveCodeBench等测试中表现卓越,推理吞吐量达DeepSeek R1的四倍。通过优化训练和算法,英伟达证明高效设计可让小模型媲美巨型对手。Llama3.1Nemotron Ultra253B通过HuggingFace开放权重,并采用商业友好许可。英伟达此举不仅便利开发者,也推动了AI技术的广泛应用和生态发展。以较小参数挑战万亿级模型,该模型展现“少即是多