IBMは5月に、企業向けアプリケーションに適したGranite13B LLMモデルをオープンソース化しました。そして今、IBMのAIプラットフォーム製品担当副社長であるアルマンド・ルイーズ(Armand Ruiz)氏が、Granite13Bのトレーニングに使用された6.48TBの膨大なデータセットの全容を公開しました。

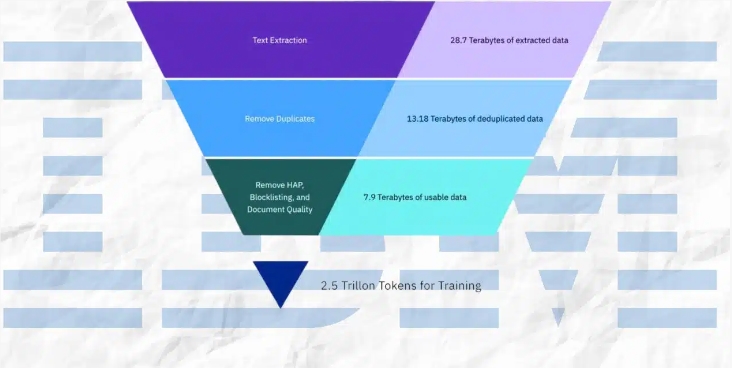

このデータセットは厳格な前処理を経て、2.07TBに圧縮され、68%の削減を実現しました。ルイーズ氏は、このステップが、企業向けアプリケーションのニーズを満たすために、高品質で、バイアスがなく、倫理的で法的にも問題のないデータセットを確保する上で極めて重要であると強調しています。

データセットは、複数のソースから慎重に選定されたもので構成されています。

- arXiv:240万件以上の科学論文のプレプリント。

- Common Crawl:公開されているウェブクロールデータベース。

- DeepMind Mathematics:数学に関する質疑応答ペア。

- Free Law:米国裁判所からのパブリックドメインの法的意見。

- GitHub Clean:CodeParrotからのコードデータ。

- Hacker News:2007年から2018年までのコンピューターサイエンスと起業家に関するニュース。

- OpenWeb Text:OpenAIのWeb Textコーパスのオープンソース版。

- Project Gutenberg(PG-19):初期の作品に焦点を当てた無料電子書籍。

- Pubmed Central:生物医学および生命科学に関する論文。

- SEC Filings:米国証券取引委員会(SEC)の10-K/Q提出書類(1934~2022年)。

- Stack Exchange:Stack Exchangeネットワーク上のユーザー投稿コンテンツ。

- USPTO:1975年から2023年5月までに付与された米国特許。

- Webhose:非構造化ウェブコンテンツを機械可読データに変換したもの。

- Wikimedia:8つの英語版ウィキメディアプロジェクト。

前処理プロセスには、テキスト抽出、重複排除、言語識別、文分割、ヘイトスピーチ、悪用、卑猥な言葉の注釈、文書品質の注釈、URLマスクの注釈、フィルタリング、トークン化が含まれます。

これらのステップでは、設定された閾値に基づいた注釈とフィルタリングが行われ、最終的なデータセットがモデルのトレーニングに最適な品質であることが保証されています。

IBMは、Graniteコードモデルの4つのバージョンを公開しており、パラメータ数は30億から340億の範囲です。これらのモデルは、一連のベンチマークテストでテストされており、Code LlamaやLlama3などの他の同等のモデルを多くのタスクで上回っています。

要点:

⭐ IBMは、Granite13B LLMモデルのトレーニングに使用された6.48TBのデータセット全体を公開しました。

⭐ データセットは厳格な前処理を経て、2.07TBに圧縮され、68%削減されました。

⭐ IBMは、パラメータ数が30億から340億の範囲の4つのGraniteコードモデルのバージョンを公開しました。