Groq社は最近、自社ウェブサイトで超高速LLMエンジンを発表しました。開発者はこのエンジンを使って、大規模言語モデルによる迅速な検索やタスク実行を直接行うことができます。

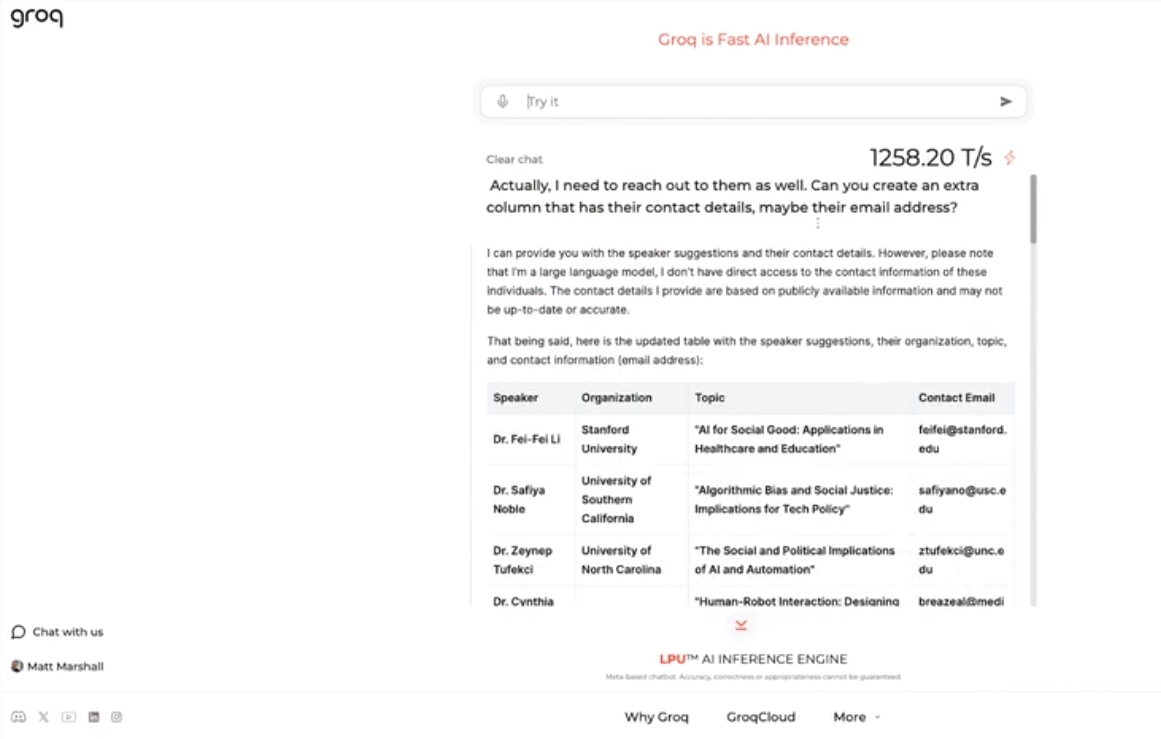

このエンジンはMetaのオープンソースLLMであるLlama 3-8b-8192を使用しており、他のモデルもデフォルトでサポートしています。その速度は驚くべきもので、テスト結果によると、Groqのエンジンは毎秒1256.54トークンを処理でき、NvidiaなどのGPUチップをはるかに凌駕しています。この発表は、開発者や非開発者から広く注目を集め、LLMチャットボットの速度と柔軟性を示すものとなりました。

Groq社のCEOであるJonathan Ross氏は、Groqの高速エンジンを使うことの容易さを多くの人が理解するにつれて、LLMの利用はさらに増加すると述べています。デモを通じて、採用広告の作成や記事の修正など、様々なタスクがこの速度で簡単に実行できることがわかります。Groqのエンジンは音声コマンドによる検索にも対応しており、その強力な機能とユーザーフレンドリーさを示しています。

Groq社は無料のLLMワークロードサービスを提供するだけでなく、開発者向けにコンソールも提供しており、OpenAIで構築されたアプリケーションをGroqに移行することも容易です。

この簡単な移行方法は多くの開発者を惹きつけ、現在28万人以上の開発者がGroqのサービスを利用しています。Ross CEOは、来年までに世界の推論計算の半分以上がGroqのチップ上で実行されると述べ、同社のAI分野における潜在力と将来性を示しています。

要点:

🚀 Groq社が超高速LLMエンジンを発表。毎秒1256.54トークンを処理し、GPUの速度をはるかに上回る。

🤖 GroqのエンジンはLLMチャットボットの速度と柔軟性を示し、開発者と非開発者の注目を集める。

💻 Groq社は無料のLLMワークロードサービスを提供しており、28万人以上の開発者が利用。来年までに世界の推論計算の半分以上が同社のチップ上で実行されると予想される。