バイトダンスの大規模モデルチームがまた功績を挙げました。彼らのDepth Anything V2モデルが、アップル社によってCore MLモデルライブラリに採用されました。これは技術的なブレークスルーであるだけでなく、注目すべきは、このプロジェクトのリーダーがなんとインターンシップ生だったことです。

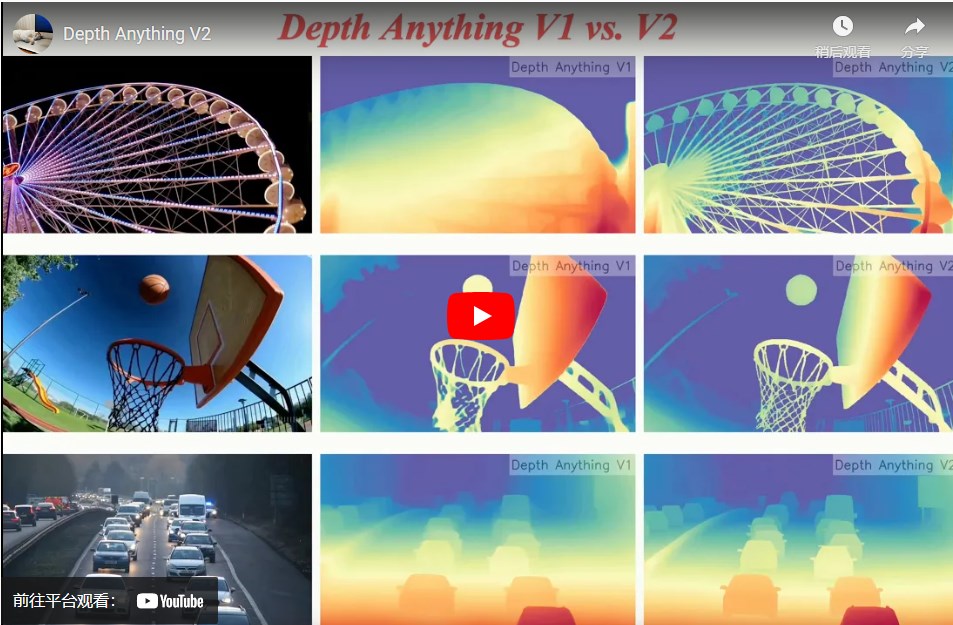

Depth Anything V2は単眼深度推定モデルで、一枚の画像からシーンの深度情報を推定できます。このモデルは、2024年初頭のV1バージョンから現在のV2バージョンまで、パラメータ数は25Mから1.3Bに拡大し、ビデオエフェクト、自動運転、3Dモデリング、拡張現実など、複数の分野で活用されています。

このモデルはGitHubで8.7kのスターを獲得しており、V2バージョンはリリース直後に2.3kスターを獲得、V1バージョンは6.4kスターを獲得しました。このような成果は、どの技術チームにとっても誇れるものであり、ましてやその中心人物がインターンシップ生であることはさらに驚きです。

アップル社がDepth Anything V2をCore MLモデルライブラリに採用したことは、モデルの性能と将来性への高い評価を示しています。Core MLはアップルの機械学習フレームワークであり、機械学習モデルをiOS、macOSなどのデバイスで効率的に実行することを可能にし、インターネット接続がなくても複雑なAIタスクを実行できます。

Depth Anything V2のCore MLバージョンは、少なくとも25Mのモデルを採用し、Hugging Face公式のエンジニアリングによる最適化を経て、iPhone 12 Pro Maxでの推論速度は31.1ミリ秒に達しました。これは、FastViT、ResNet50、YOLOv3などの他の採用モデルと共に、自然言語処理から画像認識まで、幅広い分野をカバーしています。

大規模モデルの波の中で、スケーリング則の価値はますます多くの人々によって認識されています。Depth Anythingチームは、シンプルながらも強力な基礎モデルを構築し、単一タスクでより良い結果を出すことを選択しました。彼らは、スケーリング則を利用して基礎的な問題を解決することに、より現実的な価値があると考えています。深度推定はコンピュータビジョン分野における重要なタスクの一つであり、画像からシーン内の物体の距離情報を推定することは、自動運転、3Dモデリング、拡張現実などのアプリケーションにとって非常に重要です。Depth Anything V2はこれらの分野で幅広い応用が期待できるだけでなく、ビデオプラットフォームや編集ソフトウェアにミドルウェアとして統合され、特殊効果の作成やビデオ編集などの機能をサポートすることもできます。Depth Anythingプロジェクトの筆頭著者はチームのインターンシップ生であり、この新星はメンターの指導の下、プロジェクトの構想から論文の執筆まで、1年足らずで大部分の作業を完了しました。会社とチームは自由な研究環境と十分なサポートを提供し、インターンシップ生がより難しく本質的な問題を深く研究することを奨励しました。

このインターンシップ生の成長とDepth Anything V2の成功は、個人の努力と才能を示すだけでなく、バイトダンスがビジュアル生成と大規模モデル関連分野における深い探求と人材育成を行っていることを示しています。

プロジェクトアドレス:https://top.aibase.com/tool/depth-anything-v2