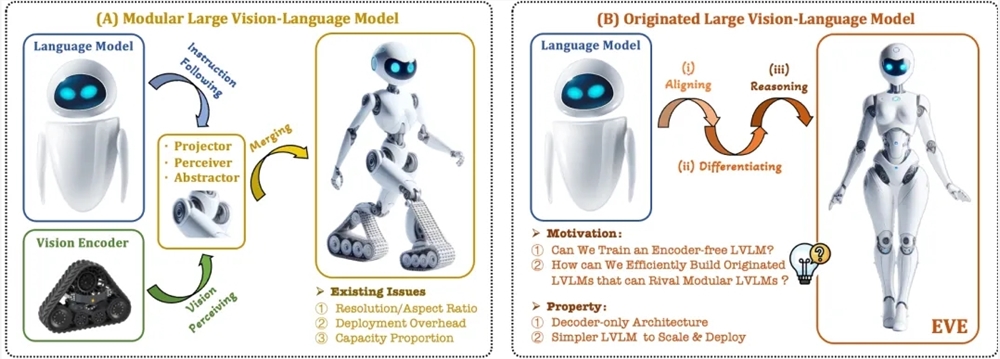

近年、マルチモーダル大規模言語モデルの研究開発は目覚ましい進歩を遂げています。OpenAI、Google、Microsoftなどの海外企業が数々の先進的なモデルを発表する一方、国内でも智譜AI、階躍星辰などの機関が同分野で大きな成果を上げています。これらのモデルは通常、画像特徴量を抽出するビジョンエンコーダと大規模言語モデルを組み合わせた構成ですが、訓練における分離によって視覚的なバイアスが生じ、マルチモーダル大規模言語モデルの展開効率と性能を制限する課題がありました。

これらの問題を解決するため、智源研究院は、大連理工大学、北京大学などの大学と協力して、新たなエンコーダレスの視覚言語モデルEVEを開発しました。EVEは、高度な訓練戦略と追加の視覚的監督を用いることで、視覚・言語表現、アライメント、推論を統一的な純粋なデコーダアーキテクチャに統合しています。公開データを用いた評価において、EVEは複数の視覚言語ベンチマークで優れた性能を示し、エンコーダベースの主流マルチモーダル手法に匹敵、あるいは凌駕する結果を達成しています。

EVEの主な特徴は以下の通りです。

ネイティブな視覚言語モデル:ビジョンエンコーダを排除し、任意のアスペクト比の画像を処理可能。同タイプのFuyu-8Bモデルを大幅に上回ります。

データと訓練コストの削減:OpenImages、SAM、LAIONなどの公開データを使用し、訓練時間も短縮されています。

透明性と効率性の高い探求:純粋なデコーダによるネイティブなマルチモーダルアーキテクチャに対して、効率的で透明性のある開発パスを提供します。

モデル構造:

Patch Embedding Layer:単層畳み込み層と平均プーリング層によって画像の2D特徴マップを取得し、局所特徴とグローバル情報を強化します。

Patch Aligning Layer:複数層のネットワーク視覚特徴を統合し、ビジョンエンコーダの出力との細粒度アライメントを実現します。

訓練戦略:

大規模言語モデルによるガイド付き事前学習段階:視覚と言語間の初期的な関連付けを構築します。

生成的な事前学習段階:視覚・言語コンテンツに対するモデルの理解能力を向上させます。

教師あり微調整段階:モデルが言語指示に従い、対話パターンを学習する能力を向上させます。

定量分析:EVEは複数の視覚言語ベンチマークで優れた性能を示し、様々な主流のエンコーダベースの視覚言語モデルと同等の結果を達成しています。特定の指示に対する正確な応答には課題が残りますが、効率的な訓練戦略によって、エンコーダベースの視覚言語モデルと同等の性能を実現しています。

EVEは、エンコーダレスのネイティブな視覚言語モデルの可能性を示しており、今後の性能向上、エンコーダレスアーキテクチャの最適化、ネイティブなマルチモーダル構築を通じて、マルチモーダルモデルの発展をさらに推進する可能性を秘めています。

論文アドレス: https://arxiv.org/abs/2406.11832

プロジェクトコード: https://github.com/baaivision/EVE