人工知能の分野では、GPT-3やLlama-2のような大規模言語モデル(LLM)が著しい進歩を遂げ、人間の言語を正確に理解し生成できるようになりました。しかし、これらのモデルは膨大なパラメータ数を持つため、訓練と展開には莫大な計算資源が必要となり、資源の限られた環境では課題となっています。

論文はこちら:https://arxiv.org/html/2406.10260v1

従来、異なる計算資源の制約下で効率性と正確性のバランスを取るため、研究者たちは複数の異なるバージョンのモデルを訓練する必要がありました。例えば、Llama-2モデルシリーズには、70億、13億、7億パラメータの異なるバリエーションがあります。しかし、この方法は大量のデータと計算資源を必要とし、効率的ではありません。

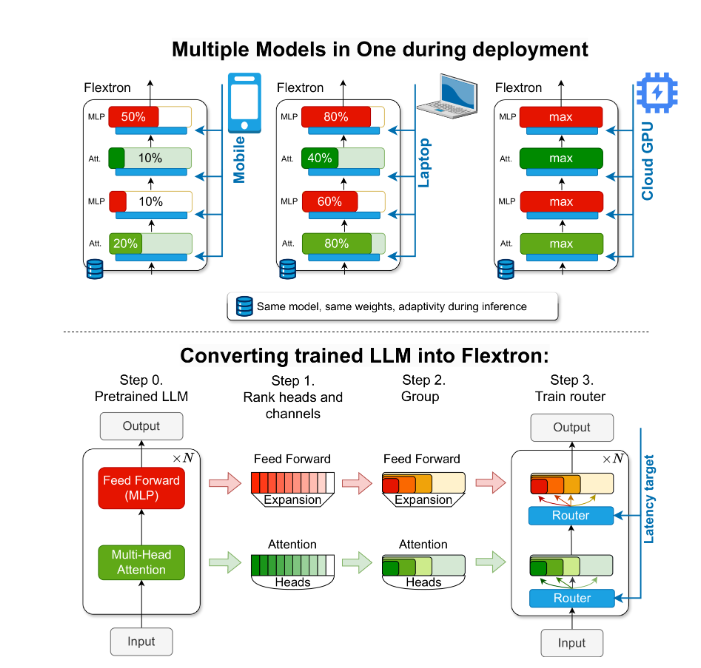

この問題を解決するために、NVIDIAとテキサス大学オースティン校の研究者たちは、Flextronフレームワークを発表しました。Flextronは、追加の微調整なしに適応的にモデルを展開できる革新的な柔軟なモデルアーキテクチャと後訓練最適化フレームワークであり、従来の方法の非効率性を解決します。

Flextronは、サンプル効率の良い訓練方法と高度なルーティングアルゴリズムを用いて、事前訓練済みのLLMを弾性モデルに変換します。この構造はネストされた弾性設計を採用しており、推論中に特定の遅延と精度目標を満たすために動的に調整できます。この適応性により、さまざまな展開シナリオで単一の事前訓練済みモデルを使用することが可能になり、複数のモデルバリアントの必要性が大幅に減少します。

Flextronの性能評価は、複数のエンドツーエンド訓練モデルや他の最先端の弾性ネットワークと比較して、効率性と正確性の両方で優れた性能を示しています。例えば、FlextronはARC-easy、LAMBADA、PIQA、WinoGrande、MMLU、HellaSwagなどの複数のベンチマークテストで優れた結果を示しており、元の事前訓練のわずか7.63%の訓練トークンしか使用していません。これにより、膨大な計算資源と時間を節約できます。

Flextronフレームワークには、弾性多層パーセプトロン(MLP)と弾性マルチヘッドアテンション(MHA)層も含まれており、適応性をさらに強化しています。弾性MHA層は、入力データに基づいてアテンションヘッドのサブセットを選択することで、利用可能なメモリと処理能力を効果的に活用し、計算資源の限られた環境に特に適しています。

要点:

🌐 Flextronフレームワークは、追加の微調整なしで柔軟なAIモデルの展開をサポートします。

🚀 サンプル効率の良い訓練と高度なルーティングアルゴリズムにより、モデルの効率性と正確性が向上します。

💡 弾性マルチヘッドアテンション層は資源利用を最適化し、計算資源の限られた環境に特に適しています。

この記事は、高校生にも分かりやすくFlextronフレームワークの重要性と革新性を紹介することを目的としています。