人工知能の世界では、大規模言語モデル(LLM)はその卓越した自然言語処理能力で知られています。しかし、これらのモデルを実際のアプリケーションに展開するには、推論段階における高い計算コストとメモリ消費が大きな課題となっています。この問題を解決するために、研究者たちはLLMの効率向上を模索してきました。最近では、Q-Sparseという手法が注目を集めています。

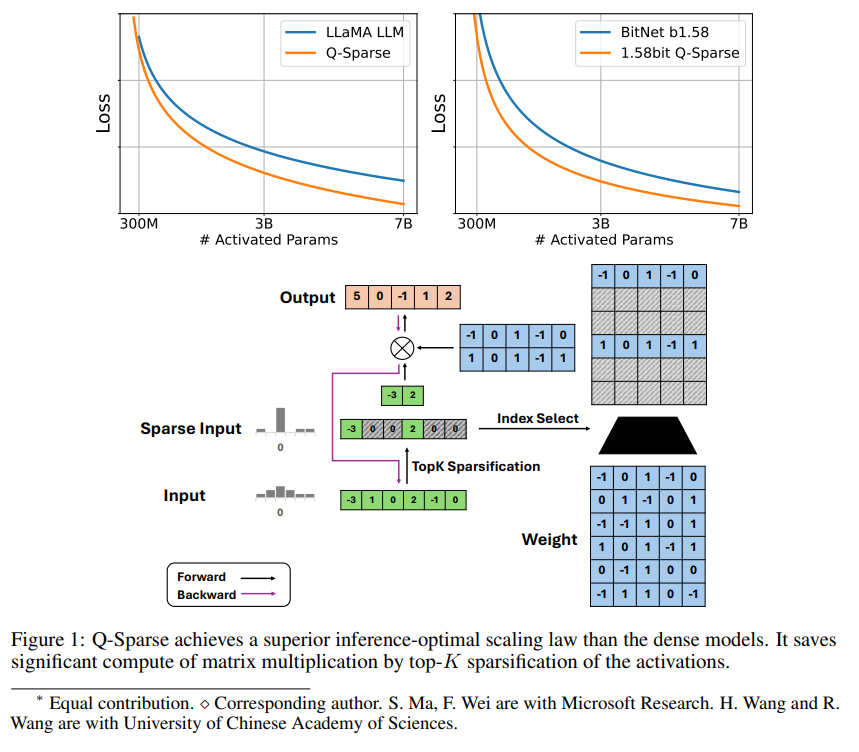

Q-Sparseはシンプルながらも効果的な手法で、活性化にtop-Kスパース化と訓練におけるストレート・スルー・エスティメータを適用することで、LLMの完全スパース活性化を実現します。これは、推論時の効率を大幅に向上させることを意味します。主な研究成果は以下の通りです。

Q-Sparseは、基線のLLMと同等の結果を維持しながら、推論効率を向上させます。

スパース活性化LLMに適用可能な推論最適化拡張則を提案しました。

Q-Sparseは、ゼロから訓練、既存LLMの継続訓練、ファインチューニングなど、様々な設定で有効です。

Q-Sparseは、全精度と1ビットLLM(例:BitNet b1.58)の両方に適用可能です。

スパース活性化の利点

スパース性によって、LLMの効率は2つの方法で向上します。まず、ゼロ要素は計算されないため、スパース性によって行列乗算の計算量が減少します。次に、スパース性によって入出力(I/O)の転送量が減少します。これは、LLMの推論段階における主要なボトルネックです。

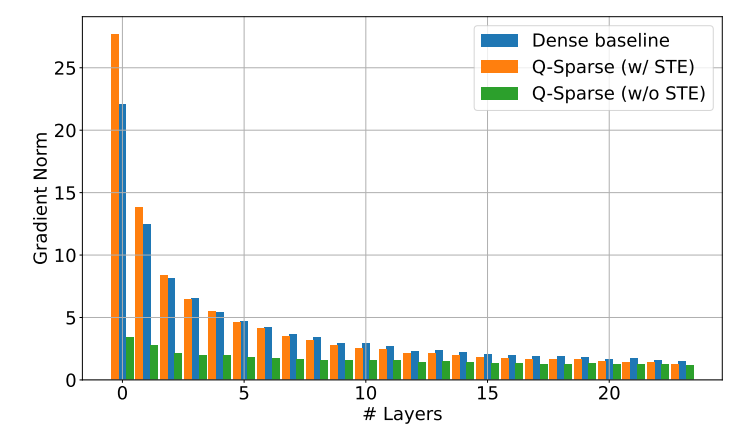

Q-Sparseは、各線形投影にtop-Kスパース化関数を適用することで、活性化の完全スパース性を実現します。逆伝播には、ストレート・スルー・エスティメータを使用して活性化の勾配を計算します。さらに、平方ReLU関数を導入して、活性化のスパース性をさらに向上させています。

実験検証

研究者たちは、一連の拡張実験を通じてスパース活性化LLMの拡張則を研究し、いくつかの興味深い発見をしました。

スパース活性化モデルの性能は、モデルサイズとスパース率の増加とともに向上します。

スパース率Sを固定した場合、スパース活性化モデルの性能はモデルサイズNに対してべき乗則に従います。

パラメータNを固定した場合、スパース活性化モデルの性能はスパース率Sに対して指数則に従います。

Q-Sparseは、ゼロから訓練するだけでなく、既存のLLMの継続訓練やファインチューニングにも使用できます。継続訓練とファインチューニングの設定では、ゼロから訓練する場合と同じアーキテクチャと訓練プロセスを使用し、唯一の違いは、事前訓練済み重みでモデルを初期化し、スパース関数を有効にして訓練を継続することです。

研究者たちは、LLMの効率をさらに向上させるために、Q-Sparseを1ビットLLM(例:BitNet b1.58)や混合専門家(MoE)と組み合わせることを検討しています。さらに、バッチ処理モードとの互換性を高める取り組みも行われており、これはLLMの訓練と推論により多くの柔軟性をもたらすでしょう。