AIが生成した画像でAI自身を再学習させるとどうなるのでしょうか?最近、スタンフォード大学とカリフォルニア大学バークレー校の研究者たちがこの実験を行い、驚くべき結果が得られました。

研究者たちは、AI画像生成モデルを、それ自身が生成した画像を使って再学習させると、モデルはひどく歪んだ画像を生成することを発見しました。さらに悪いことに、この歪みは再学習に使用されたテキストプロンプトに限定されません。「汚染」されたモデルは、その後、本物の画像だけを使って再学習させても、完全に回復することは難しいのです。

実験の出発点は、Stable Diffusion(SD)というオープンソースのモデルでした。研究者たちはまず、FFHQ顔データセットから70,000枚の高品質な顔画像を選び、自動分類を行いました。次に、これらの本物の画像を入力として使用し、Stable Diffusionモデルで特定の人口統計的特徴に一致する900枚の画像を生成しました。

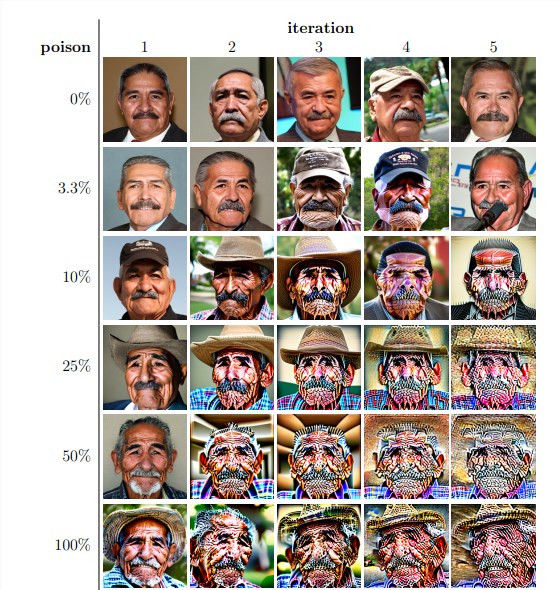

次に、研究者たちはこれらの生成された画像をモデルの反復再学習に使用しました。再学習データセットにおける自己生成画像の割合に関係なく、モデルは最終的に崩壊し、生成される画像の品質は急激に低下しました。再学習データに自己生成画像がわずか3%含まれている場合でも、モデルの崩壊は発生しました。

実験の結果、基線バージョンのStable Diffusionモデルは、テキストプロンプトと一致し、視覚的な品質も高い画像を生成しました。しかし、モデルが反復的に再学習されると、生成される画像に意味的な不一致や視覚的な歪みが現れ始めました。研究者たちはまた、モデルの崩壊は画像の品質に影響を与えるだけでなく、生成される画像の多様性の欠如にもつながることを発見しました。

これを検証するために、研究者たちは対照実験を行い、生成画像の色ヒストグラムを調整したり、低品質の画像を削除したりして、モデルの崩壊の影響を軽減しようと試みました。しかし、その結果、これらの対策はモデルの崩壊を効果的に阻止することはできませんでした。

研究者たちはまた、「汚染」されたモデルが再学習によって回復する可能性があるかどうかについても検討しました。いくつかのケースでは、反復的な再学習の後、生成画像の品質がいくらか回復したものの、モデル崩壊の兆候は依然として残っていました。これは、一度モデルが「汚染」されると、その影響は長期的なもの、あるいは不可逆的なものになる可能性があることを示しています。

この研究は、現在普及している拡散ベースのテキストから画像への生成AIシステムがデータの「汚染」に非常に敏感であるという重要な問題を明らかにしました。この「汚染」は、オンラインリソースから画像を無差別に取得することなど、意図せずに発生する可能性があります。また、意図的に「汚染」されたデータをウェブサイトに配置することなど、標的型攻撃によって発生する可能性もあります。

これらの課題に対処するために、研究者たちは、AI生成画像を除外するための画像の真偽判定器を使用したり、生成画像に透かしを追加したりするなど、いくつかの解決策を提案しています。これらの方法は完璧ではありませんが、組み合わせることで、データの「汚染」のリスクを大幅に軽減できる可能性があります。

この研究は、AI技術の発展にはリスクが伴わないわけではないことを私たちに思い出させます。AI生成コンテンツをより慎重に扱い、それが私たちのモデルやデータセットに長期的な悪影響を与えないようにする必要があります。今後の研究では、このタイプのデータ「汚染」に対してAIシステムをより強靭にする方法、あるいはモデルの「治療」を加速させる技術の開発をさらに探求する必要があります。

論文アドレス:https://arxiv.org/pdf/2311.12202