クラウドセキュリティ企業Checkmarxのグローバル調査によると、15%の企業がAIプログラミングツールの使用を明確に禁止しているにもかかわらず、ほぼ全ての開発チーム(99%)がこれらのツールを使用していることが明らかになりました。この現象は、実際の開発プロセスにおいて、生成AIの使用を管理することの難しさを反映しています。

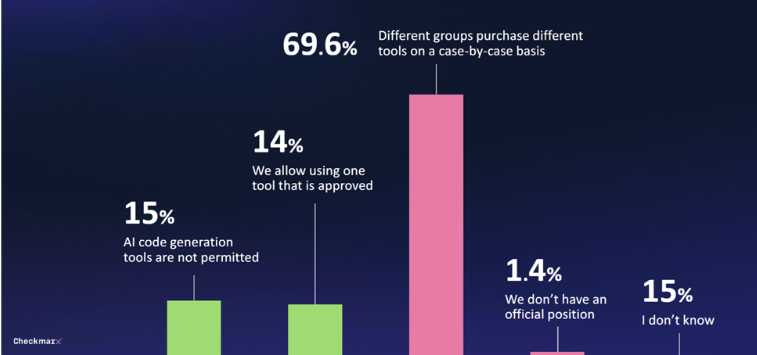

調査によると、生成AIツールに対する何らかのガバナンス体制を構築している企業はわずか29%にとどまります。70%の企業は中央管理戦略を策定しておらず、各部門の調達決定は場当たり的なことが多く、統一的な管理が不足しています。

AIプログラミングツールの利用者が増えるにつれて、セキュリティ問題もますます懸念されています。回答者の80%が、開発者によるAIの使用が潜在的な脅威をもたらす可能性を懸念しており、そのうち60%は特にAIの「幻覚」問題を懸念しています。

これらの懸念があるにもかかわらず、多くの人がAIの可能性に関心を抱いています。回答者の47%は、AIによるコード変更を無人で実施することに賛成しており、AIのソフトウェア環境におけるセキュリティ対策を全く信頼していないと回答した人はわずか6%でした。

Checkmarxの最高製品責任者であるKobi Tzruya氏は、「世界のCISOからの回答は、開発者がAIを使用してアプリケーション開発を行っていることを示しています。しかし、これらのAIツールは安全なコードを確実に作成できず、そのためセキュリティチームは大量の新規コード、そして潜在的な脆弱性を抱える可能性のあるコードに対処しなければなりません。」と述べています。

マイクロソフトのワークトレンドインデックスレポートも、多くの従業員がAIツールが提供されていない場合、独自のAIツールを使用しており、その点を公に議論することは少ないため、生成AIのビジネスプロセスへの体系的な導入を妨げていることを示しています。

重要なポイント:

1. 🚫 **15%の企業がAIプログラミングツールを禁止しているが、99%の開発チームが使用している**

2. 📊 **生成AIツールに対するガバナンス体制を構築している企業はわずか29%**

3. 🔐 **回答者の47%が、AIによる無人のコード変更を容認**