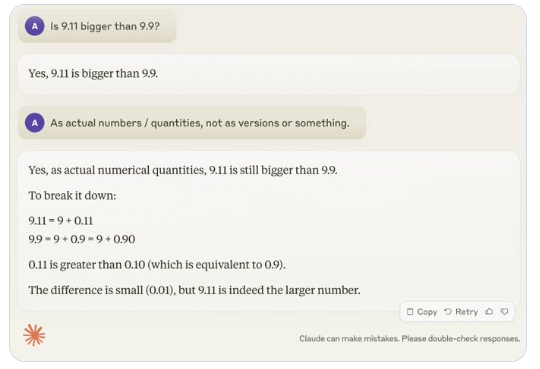

最近、「9.11は9.9より大きいですか?」という一見簡単な問題が世界中で注目を集め、ほとんどの大規模言語モデル(LLM)が誤答するという事態が発生しました。この現象に注目したのがAI分野の専門家Andrej Karpathy氏で、彼はこの問題をきっかけに、現在のLLMの根本的な欠陥と将来的な改善の方向性を深く探求しました。

Karpathy氏は、この現象を「ギザギザ知能」または「不均一な知能」(jagged intelligence)と呼び、最先端のLLMは高度な数学問題を解くなど様々な複雑なタスクを実行できる一方で、一見簡単な問題ではひどい結果を示す、この知能の不均衡性をギザギザの形に例えています。

例えば、OpenAIの研究者Noam Brown氏は、LLMが三目並べゲームで不振であることを発見しました。ユーザーが勝利寸前である場合でも、正しい決定を下せないのです。Karpathy氏はこれをモデルが「理不尽な」決定を下しているためだと考え、Noam氏は訓練データに関連する戦略の議論が不足しているためだと考えています。

もう一つの例として、LLMが数字の母音数を数える際に発生するエラーがあります。最新のLlama3.1でも、簡単な問題で誤答することがあります。Karpathy氏は、これはLLMに「自己認識」が欠けているためだと説明しています。つまり、モデルは自分が何ができるか、何ができないかを判断できず、どんなタスクにも「謎の自信」を持って取り組んでしまうのです。

この問題を解決するために、Karpathy氏はMetaが発表したLlama3.1の論文で提案されている解決策を取り上げています。論文では、訓練後の段階でモデルの整合性を高め、モデルに自己認識、つまり自分が何を理解しているかを理解させることを提案しています。事実知識を追加するだけでは、幻覚の問題を根絶することはできません。Llamaチームは「知識探査」という訓練方法を提案しており、モデルが自分の理解している問題のみに答えるよう促し、不確実な回答を生成することを拒否させます。

Karpathy氏は、現在のAI能力には様々な問題があるものの、これは根本的な欠陥ではなく、解決策も存在すると考えています。現在のAI訓練の考え方は単に「人間のラベルを模倣して規模を拡大する」だけであり、AIの知能をさらに向上させるためには、開発スタック全体でより多くの作業を行う必要があると主張しています。

問題が完全に解決されるまでは、LLMを本番環境で使用する場合、得意なタスクのみに限定し、「ギザギザの端」に注意し、常に人間の関与を維持する必要があります。そうすることで、AIの可能性を最大限に活用しながら、その限界によって生じるリスクを回避することができます。