3Dデジタルヒューマンの分野では、目覚ましい進歩が見られる一方で、従来の手法では多視点の一貫性と感情表現の不足という問題がありました。これらの課題を解決するため、南京大学、復旦大学、そしてHuawei Noah's Ark Labの研究チームが新たなブレークスルーを達成しました。

製品ページ:https://nju-3dv.github.io/projects/EmoTalk3D/

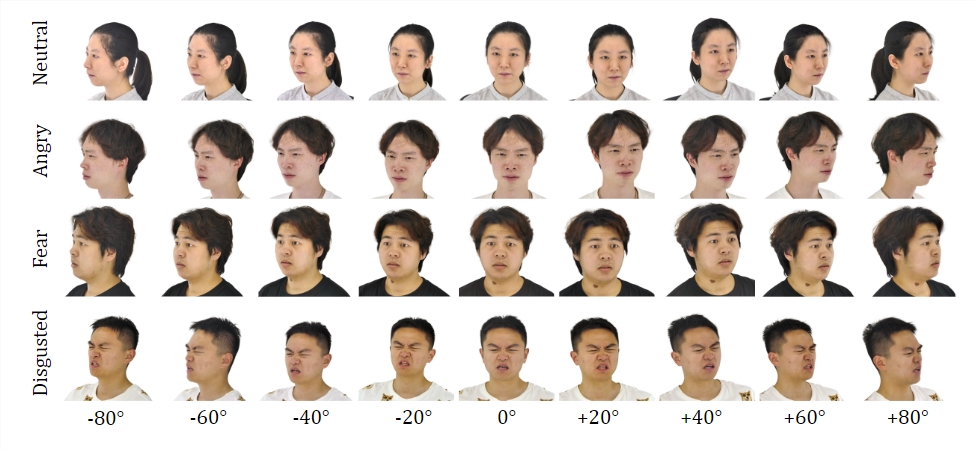

彼らは、校正された多視点ビデオ、感情ラベル、そしてフレームごとの3Dジオメトリを含むEmoTalk3Dデータセットを収集しました。そして、制御可能な感情を持つ3Dの会話アバターを合成するための新しい手法を提案し、リップシンクとレンダリング品質の両面で顕著な向上を実現しました。

データセット:

EmoTalk3Dデータセットを用いたトレーニングを通して、研究チームは「音声からジオメトリ、そして外観へ」というマッピングフレームワークを構築しました。まず、音声特徴からリアルな3Dジオメトリシーケンスを予測し、次に予測されたジオメトリに基づいて、4Dガウス分布で表現された3D会話アバターの外観を合成します。外観はさらに標準的なガウス分布と動的なガウス分布に分解され、多視点ビデオから学習され、自由視点の会話アバターアニメーションを表現するために融合されます。

このモデルは、生成された会話アバターにおいて制御可能な感情を実現し、広範囲の視点でレンダリングすることができます。しわや微妙な表情などの動的な顔のディテールを捉えながら、リップシンクの生成におけるレンダリング品質と安定性の向上を示しました。生成結果の例では、3Dデジタルヒューマンの喜び、怒り、落胆といった表情が正確に表現されています。

全体的な流れは5つのモジュールから構成されています。

1つ目は、感情内容分解エンコーダーで、入力音声から内容と感情の特徴を解析します。2つ目は、音声からジオメトリへのネットワークで、特徴から動的な3D点群を予測します。3つ目は、ガウス最適化と完成モジュールで、標準的な外観を構築します。4つ目は、ジオメトリから外観へのネットワークで、動的な3D点群に基づいて顔の外観を合成します。5つ目は、レンダリングモジュールで、動的なガウス分布を自由視点アニメーションとしてレンダリングします。

さらに、彼らはEmoTalk3Dデータセットも構築しました。これは、フレームごとの3D顔形状を持つ感情ラベル付きの多視点会話アバターデータセットであり、非商業的な研究目的で一般公開される予定です。

重要なポイント:

💥 制御可能な感情を持つデジタルヒューマンを合成する新しい手法を提案。

🎯 「音声からジオメトリ、そして外観へ」というマッピングフレームワークを構築。

👀 EmoTalk3Dデータセットを構築し、公開準備中。