現代において、自然言語処理(NLP)分野は急速に発展しており、大規模言語モデル(LLM)は複雑な言語関連タスクを高精度で実行できるようになり、人機インタラクションの可能性を広げています。しかし、NLPにはモデル評価が人間の注釈に依存するという顕著な問題が存在します。

人間の生成データはモデルの訓練と検証に不可欠ですが、これらのデータの収集には費用と時間がかかります。さらに、モデルが改善されるにつれて、以前収集された注釈は更新が必要になる場合があり、新しいモデルを評価する際の有効性が低下します。そのため、継続的に新しいデータを取得する必要があり、効果的なモデル評価の規模化と持続可能性に課題が生じています。

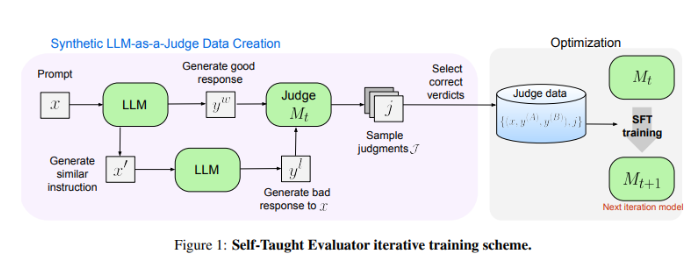

Meta FAIRの研究者たちは、全く新しい解決策「Self-Taught Evaluator(自習評価器)」を発表しました。この方法は人間の注釈を必要とせず、合成生成データを用いて訓練を行います。まず、シードモデルを用いて対照的な合成選好ペアを生成し、次にモデルがこれらのペアを評価して反復的に改善することで、自身の判断を用いて後続の反復における性能を向上させ、人間の生成注釈への依存を大幅に削減します。

研究者たちは、Llama-3-70B-Instructモデルを用いて「自習評価器」の性能をテストしました。この方法は、RewardBenchベンチマークにおけるモデルの精度を75.4から88.7に向上させ、人間の注釈を用いて訓練されたモデルの性能に匹敵、あるいはそれを上回る結果となりました。複数回の反復を経て、最終的なモデルは単一推論で88.3の精度、多数決で88.7の精度を達成し、その強力な安定性と信頼性を示しました。

「自習評価器」は、NLPモデル評価に対して拡張性が高く効率的な解決策を提供します。合成データと反復的な自己改善を利用することで、人間の注釈への依存という課題に対応し、言語モデルの発展を促進します。

論文アドレス:https://arxiv.org/abs/2408.02666

要点:

- 😃NLPモデル評価は人間の注釈に依存しており、データ収集のコストが高く、時間がかかり、有効性が低下しやすいという問題があります。

- 🤖Meta FAIRは「Self-Taught Evaluator」を発表し、合成データを用いた訓練により、人間の注釈への依存を軽減しました。

- 💪「自習評価器」は優れた性能を示し、テストにおいてモデルの精度を大幅に向上させ、安定した信頼性を示しました。