情報が溢れる現代、私たちは毎日写真や動画で生活を記録し、喜びを共有しています。しかし、機械が人間のようにそれらの写真や動画を理解し、私たちと深く交流できたらどうなるか、考えたことはありますか?

アリババチームが最近発表した汎用マルチモーダル大規模モデルmPLUG-Owl3は、驚異的な効率と理解力により、2時間の映画をわずか4秒で「視聴」することができます!これは単なるモデルではなく、見て、聞いて、話して、考えることができるAIアシスタントのようなものです。

mPLUG-Owl3、この名前はまるで眼鏡をかけたフクロウのように、賢く機敏です。その核心能力は、長い画像シーケンスの理解にあります。一連の写真でも動画でも、その内容を理解し、ストーリーラインさえ理解することができます。

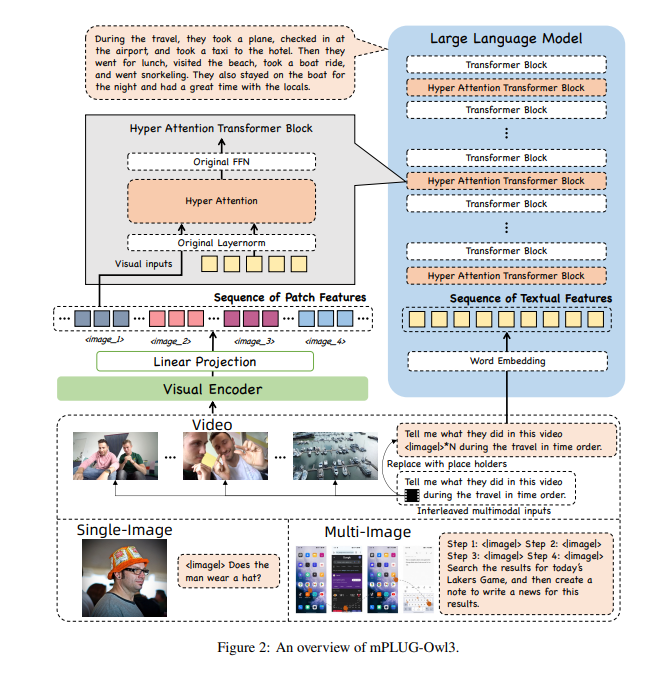

mPLUG-Owl3がこれほど多くの情報を処理できるようにするため、研究者たちは超注意力モジュールという超脳を搭載しました。このモジュールはAIの超脳のようなもので、視覚情報と言語情報を同時に処理し、AIが画像を理解する一方で、関連するテキスト情報も理解できるようにします。

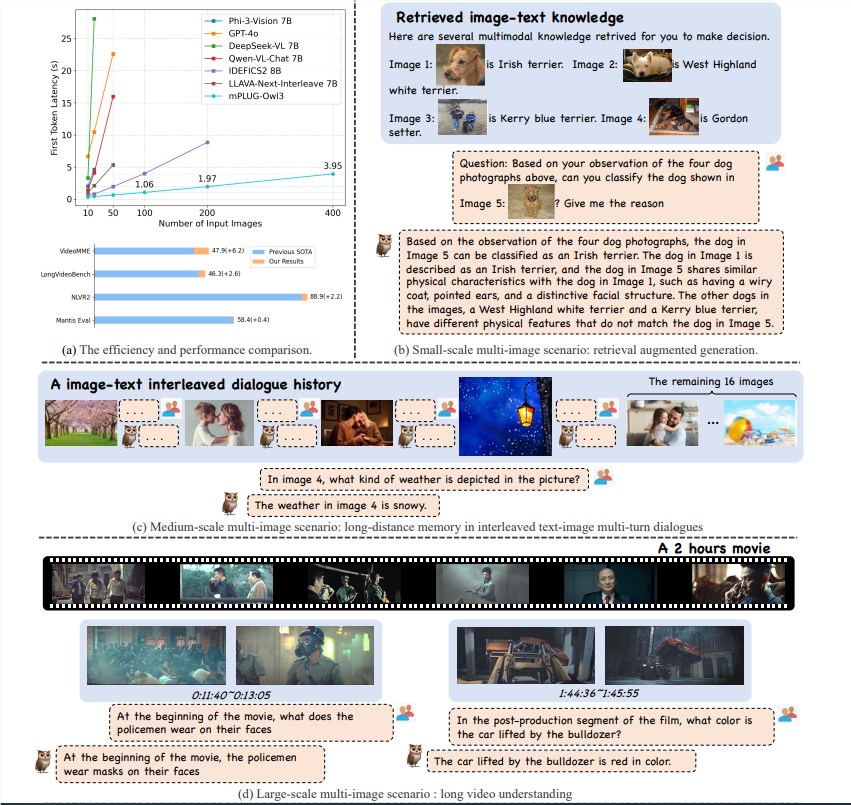

mPLUG-Owl3モデルは、その優れた推論効率により、マルチモーダル理解分野で大きな進歩を遂げました。単一画像、複数画像、動画など、複数のシナリオのベンチマークでSOTA(State of the Art)を達成しただけでなく、First Token Latencyを6倍短縮し、単一のA100 GPUで処理できる画像数を8倍の400枚に増加させました。

mPLUG-Owl3は、入力されたマルチモーダルな知識を正確に理解し、質問に答えることができます。どの知識に基づいて判断したのか、そして詳細な判断根拠も教えてくれます。

mPLUG-Owl3は、異なる素材の内容関係を正しく理解し、深い推論を行うことができます。スタイルの違いやキャラクターの認識なども容易に処理できます。

mPLUG-Owl3は最長2時間の動画を視聴して理解し、4秒以内にユーザーの質問に答えることができます。質問が動画のどの部分に関するものであってもです。

mPLUG-Owl3は軽量化されたHyper Attentionモジュールを採用し、Transformer Blockを画像とテキストの特徴の相互作用とテキストモデリングを行うことができる新しいモジュールに拡張しました。この設計により、追加で導入される新しいパラメータが大幅に削減され、モデルの訓練が容易になり、訓練と推論の効率も向上しました。

広範なデータセットで実験を行った結果、mPLUG-Owl3はほとんどの単一画像マルチモーダルベンチマークでSOTAの結果を達成しました。複数画像の評価では、複数画像のシナリオに特化して最適化されたモデルを上回りました。LongVideoBenchでは、既存のモデルを凌駕し、長尺動画の理解における卓越した能力を示しました。

アリババのmPLUG-Owl3の発表は、技術的な飛躍であるだけでなく、マルチモーダル大規模モデルの応用にも新たな可能性をもたらします。技術の更なる向上とともに、mPLUG-Owl3が将来、より多くの驚きをもたらしてくれることを期待しています。

論文アドレス:https://arxiv.org/pdf/2408.04840

コード:https://github.com/X-PLUG/mPLUG-Owl/tree/main/mPLUG-Owl3