現代のテクノロジー企業がこぞってデバイス上でのAI実装を目指している中、リソースの限られたデバイスでも動作する小型言語モデル(SLM)が続々と登場しています。最近、Nvidiaの研究チームは最先端のモデル剪定と蒸留技術を用いて、Llama3モデルの圧縮版であるLlama-3.1-Minitron4Bを発表しました。この新しいモデルは、大規模モデルに匹敵する性能を持ち、同規模の小型モデルと比べても競争力があり、訓練と展開の両面で効率的です。

剪定と蒸留は、より小さく、より効率的な言語モデルを作成するための2つの重要な技術です。「深層剪定」—層全体を削除すること、「幅剪定」—ニューロンやアテンションヘッドなどの特定の要素を削除することを含む、モデルの不要な部分を削除するのが剪定です。一方、モデル蒸留とは、大規模モデル(「教師モデル」)から、より小さくシンプルな「生徒モデル」に知識と能力を転移することです。

蒸留には主に2つの方法があります。1つ目は「SGD訓練」で、生徒モデルが教師モデルの入力と応答を学習する方法です。2つ目は「古典的知識蒸馏」で、生徒モデルは結果だけでなく、教師モデルの内部活性化も学習します。

以前の研究で、Nvidiaの研究者たちは、Nemotron15Bモデルを剪定と蒸留によって8億パラメータのモデルに削減し、さらに4億パラメータにまで小型化することに成功しました。このプロセスは、有名なMMLUベンチマークテストで16%の性能向上をもたらしただけでなく、必要なトレーニングデータもゼロから訓練する場合と比べて40倍少なくなりました。

今回、NvidiaチームはLlama3.18Bモデルをベースに、同じ手法を用いて4億パラメータのモデルを作成しました。まず、940億トークンを含むデータセットで未剪定の8Bモデルを微調整し、訓練データと蒸留データセット間の分布の違いに対応しました。次に、深層剪定と幅剪定の両方の方法を採用し、Llama-3.1-Minitron4Bの2つの異なるバージョンを得ました。

研究者たちは、NeMo-Alignerを使用して剪定後のモデルを微調整し、指示追従、ロールプレイング、検索強化生成(RAG)、関数呼び出しなどの能力を評価しました。

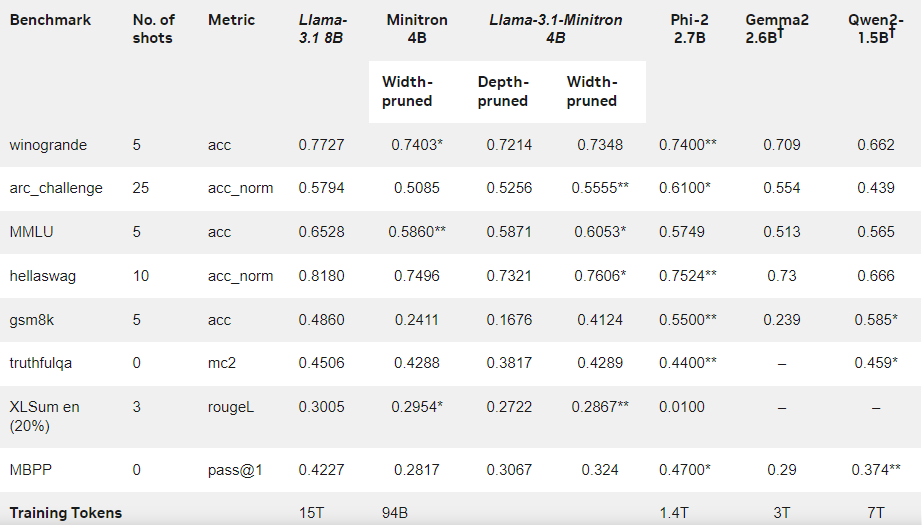

その結果、訓練データ量が比較的少ないにもかかわらず、Llama-3.1-Minitron4Bは他の小型モデルに匹敵する優れた性能を示しました。このモデルの幅剪定バージョンはHugging Faceで公開されており、商用利用が許可されており、より多くのユーザーと開発者がその効率性と優れた性能の恩恵を受けることができます。

公式ブログ:https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model/

要点:

🌟 Llama-3.1-Minitron4Bは、Nvidiaが剪定と蒸留技術に基づいて開発した小型言語モデルであり、効率的な訓練と展開能力を備えています。

📈 このモデルは、訓練においてゼロから訓練する場合と比べて40倍少ないトークン数で、性能を大幅に向上させました。

🔓 幅剪定バージョンはHugging Faceで公開されており、ユーザーは商用利用や開発に容易に利用できます。