AIトレーニング分野において、NvidiaのGPUは圧倒的な地位を築いていますが、AI推論においては、特にエネルギー効率の面で競合他社が追いつきつつあります。Nvidia最新のBlackwellチップは高い性能を誇りますが、その優位性を維持できるかどうかはまだ分かりません。

ML Commonsは最新のAI推論コンテストの結果、MLPerf Inference v4.1を発表しました。このラウンドでは、AMDのInstinctアクセラレータ、GoogleのTrilliumアクセラレータ、カナダのスタートアップUntetherAIのチップ、そしてNvidiaのBlackwellチップが初めて参加しました。CerebrasとFuriosaAIも新しい推論チップを発表しましたが、MLPerfのテストには参加しませんでした。

MLPerfは、複数の項目とサブ項目を持つオリンピックのような構造です。「データセンタークローズド」カテゴリの参加者が最も多くなっています。オープンカテゴリとは異なり、クローズドカテゴリでは、ソフトウェアを大幅に変更せずに、与えられたモデルで直接推論を行う必要があります。データセンターカテゴリは主にバッチ処理リクエストの能力をテストし、エッジカテゴリはレイテンシの低減に重点を置いています。

各カテゴリには9つの異なるベンチマークがあり、人気のある画像生成(Midjourneyなど)や大規模言語モデルの質問応答(ChatGPTなど)を含む様々なAIタスク、そして画像分類、物体検出、レコメンドエンジンなど、重要なもののあまり知られていないタスクも含まれています。

このラウンドでは、「エキスパートミックスモデル」という新しいベンチマークが追加されました。これは、大規模言語モデルの展開方法としてますます普及しており、1つの言語モデルを複数の独立した小さなモデルに分割し、各モデルを特定のタスク(日常会話、数学の問題解決、プログラミング支援など)に合わせて微調整します。各クエリを対応する小さなモデルに割り当てることで、リソースの利用を削減し、コストを削減し、スループットを向上させることができます。AMDの上級技術者Miroslav Hodak氏はそう述べています。

人気のある「データセンタークローズド」ベンチマークでは、Nvidia H200 GPUとGH200スーパーチップベースの提出物が依然として勝利しました。これらはGPUとCPUを1つのパッケージに統合しています。しかし、結果を詳しく分析すると、興味深い詳細がいくつか分かります。一部の参加者は複数のアクセラレータを使用し、その他は1つだけを使用しました。アクセラレータの数でクエリ毎秒数を正規化し、各アクセラレータの種類で最高の提出物を残すと、結果はさらに複雑になります。この方法はCPUとインターコネクトの影響を無視していることに注意が必要です。

アクセラレータごとに、NvidiaのBlackwellは大規模言語モデルの質問応答タスクで優れた性能を示し、以前のチップ世代よりも2.5倍高速化されました。これは、彼らが提出した唯一のベンチマークです。Untether AIのspeedAI240プレビューチップは、唯一提出された画像認識タスクでH200とほぼ同等の性能を示しました。GoogleのTrilliumは画像生成タスクでH100とH200をやや下回り、AMDのInstinctは大規模言語モデルの質問応答タスクでH100と同等の性能を示しました。

Blackwellの成功は、部分的に大規模言語モデルを4ビット浮動小数点精度で実行できることによるものです。Nvidiaと競合他社は、変換モデル(ChatGPTなど)におけるデータ表現のビット数を削減することに取り組んでおり、計算速度を向上させています。NvidiaはH100で8ビット演算を導入しましたが、今回の提出物はMLPerfベンチマークにおける4ビット演算の最初の発表となります。

このような低精度数値を使用する際の最大の課題は、精度を維持することです。Nvidiaのプロダクトマーケティングディレクター、Dave Salvator氏は述べています。MLPerfの提出物で高い精度を維持するために、Nvidiaチームはソフトウェア面で多くの革新を行いました。

さらに、Blackwellのメモリ帯域幅はほぼ2倍になり、毎秒8テラバイトに達しました。一方、H200は4.8テラバイトです。

NvidiaのBlackwellの提出物は単一チップを使用していましたが、Salvator氏は、それがネットワークと拡張用に設計されており、NvidiaのNVLinkインターコネクトと組み合わせて使用した場合に最適な性能を発揮すると述べています。Blackwell GPUは最大18個のNVLink 100GB/秒接続をサポートし、総帯域幅は1.8テラバイト/秒に達し、H100のインターコネクト帯域幅のほぼ2倍です。

Salvator氏は、大規模言語モデルの規模が拡大するにつれて、推論でさえ、ニーズを満たすためにマルチGPUプラットフォームが必要になると考えており、Blackwellはそのような状況のために設計されています。「Blackwellはプラットフォームです」とSalvator氏は述べています。

NvidiaはBlackwellチップシステムをプレビューサブカテゴリに提出しました。これはまだ発売されていないことを意味しますが、次回のMLPerfリリース前には利用可能になる予定です。約6ヶ月後です。

各ベンチマークでは、MLPerfにはエネルギー測定部分も含まれており、タスク実行時の各システムの実消費電力を体系的にテストします。このラウンドの主要なコンテスト(データセンタークローズドエネルギーカテゴリ)には、NvidiaとUntether AIの2社のみが参加しました。Nvidiaはすべてのベンチマークに参加しましたが、Untetherは画像認識タスクでのみ結果を提出しました。

Untether AIはこの点で優れた性能を示し、卓越したエネルギー効率を実現しました。彼らのチップは「インメモリコンピューティング」と呼ばれる方法を採用しています。Untether AIのチップは、近くに小型プロセッサが隣接するメモリセル群で構成されています。各プロセッサは並列で動作し、隣接するメモリセル内のデータと同時に処理することで、メモリと計算コア間のモデルデータ転送にかかる時間とエネルギーを大幅に削減します。

「AIワークロードを実行する際に、エネルギー消費の90%はDRAMからキャッシュ処理ユニットへのデータ移動にあります」とUntether AIのプロダクトバイスプレジデント、Robert Beachler氏は述べています。「そのため、Untetherのアプローチは、データを計算ユニットに移動するのではなく、計算をデータの近くに移動することです。」

この方法は、MLPerfの別のサブカテゴリである「エッジクローズド」で特に優れた性能を示しました。このカテゴリは、工場の機械検出、ガイド付きビジョンロボット、自動運転車など、より現実的なユースケースに焦点を当てています。これらのアプリケーションは、エネルギー効率と高速処理に厳しい要件があります。Beachler氏は説明しています。

画像認識タスクにおいて、Untether AIのspeedAI240プレビューチップは、NvidiaのL40Sよりもレイテンシ性能が2.8倍高速で、スループット(毎秒サンプル数)も1.6倍向上しました。このスタートアップは、このカテゴリで消費電力結果も提出しましたが、Nvidiaの競合他社は提出していなかったため、直接比較することは困難です。しかし、Untether AIのspeedAI240プレビューチップの定格消費電力は150ワットであるのに対し、NvidiaのL40Sは350ワットであるため、消費電力面で2.3倍の優位性があり、同時にレイテンシ性能も優れていることが示されています。

CerebrasとFuriosaはMLPerfに参加しませんでしたが、それぞれ新しいチップを発表しました。Cerebrasはスタンフォード大学のIEEE Hot Chipsカンファレンスで、その推論サービスを発表しました。カリフォルニア州サンニーベールに拠点を置くCerebrasが製造する巨大チップは、シリコンウェハーが許容する限界まで大きく、チップ間のインターコネクトを回避し、デバイスのメモリ帯域幅を大幅に向上させ、主に巨大なニューラルネットワークのトレーニングに使用されます。現在、彼らは最新のコンピューターCS3をアップグレードして推論をサポートしています。

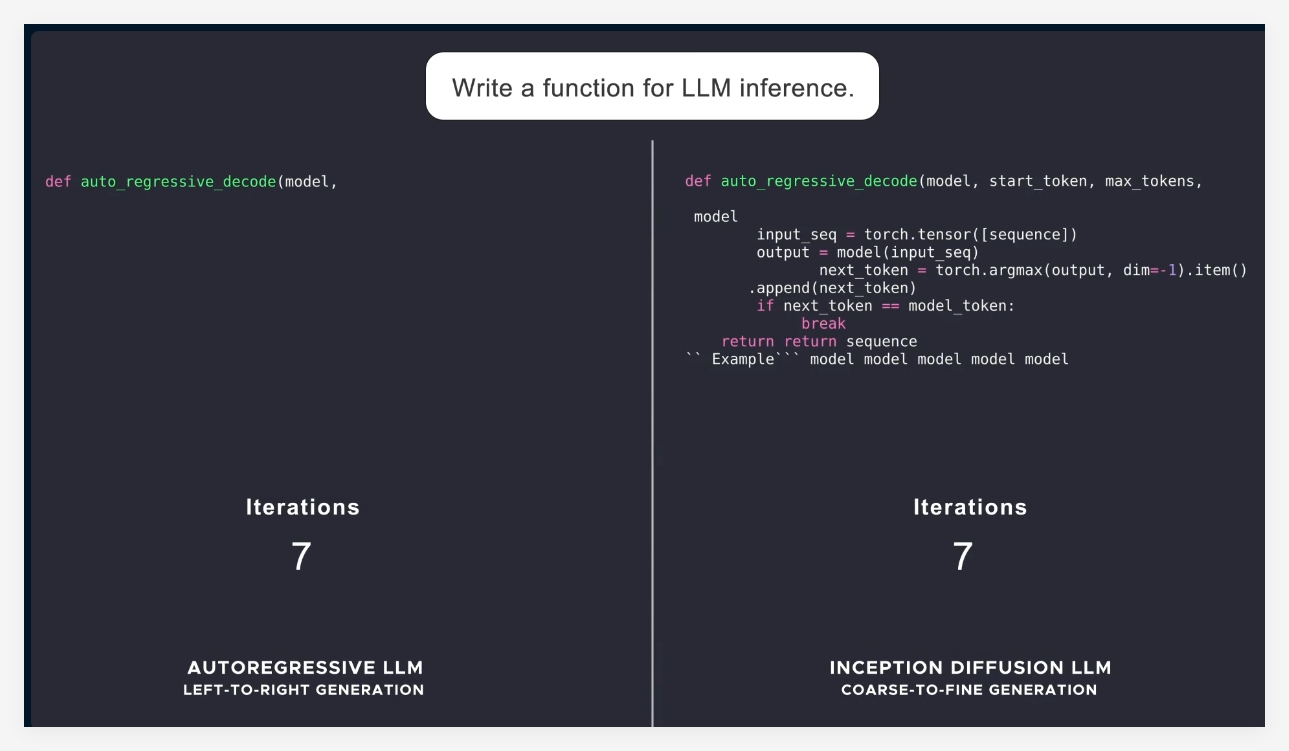

CerebrasはMLPerfに提出していませんが、同社は、そのプラットフォームが毎秒生成されるLLMトークン数において、H100の7倍、競合他社のGroqチップの2倍を上回ると主張しています。「今日、私たちは生成AIのダイヤルアップ時代にあります」とCerebrasのCEO兼共同創設者であるAndrew Feldman氏は述べています。「これはすべて、メモリ帯域幅のボトルネックが存在するためです。NvidiaのH100、AMDのMI300、TPUのいずれも、同じ外部メモリを使用しているため、同じ制限があります。私たちはウェハーレベル設計を採用しているため、この障害を克服しました。」

Hot Chipsカンファレンスでは、ソウルを拠点とするFuriosaも、第2世代チップRNGD(「Rebel」と発音)を発表しました。Furiosaの新しいチップは、テンソル縮小プロセッサ(TCP)アーキテクチャを特徴としています。AIワークロードでは、基本的な数学関数は行列乗算であり、通常はハードウェアでプリミティブとして実装されます。しかし、行列のサイズと形状、つまりより広範なテンソルは大きく異なる可能性があります。RNGDはこのより一般的なテンソル乗算をプリミティブとして実装しています。「推論では、バッチサイズは大きく変化するため、特定のテンソルの形状に固有の並列性とデータ再利用を最大限に活用することが重要です」とFuriosaの創設者兼CEOであるJune Paik氏はHot Chipsで述べています。

FuriosaはMLPerfに参加していませんが、内部テストではRNGDチップをMLPerfのLLMサマリーベンチマークと比較し、NvidiaのL40Sチップと同等の性能を示しましたが、消費電力は185ワットで、L40Sは320ワットでした。Paik氏は、さらなるソフトウェア最適化により、性能が向上すると述べています。

IBMも、エンタープライズ生成AIワークロード向けに設計された新しいSpyreチップを発表し、2025年第1四半期に発売される予定です。

明らかに、AI推論チップ市場は、近い将来、活況を呈するでしょう。

参考文献:https://spectrum.ieee.org/new-inference-chips