最近、NVIDIAはGeorgia Tech、UMD、HKPUの研究チームと協力して、全く新しいビジョン言語モデル——NVEagleを発表しました。これは画像を理解し、会話もできる、いわば何でもできるスーパーアシスタントのようなものです。

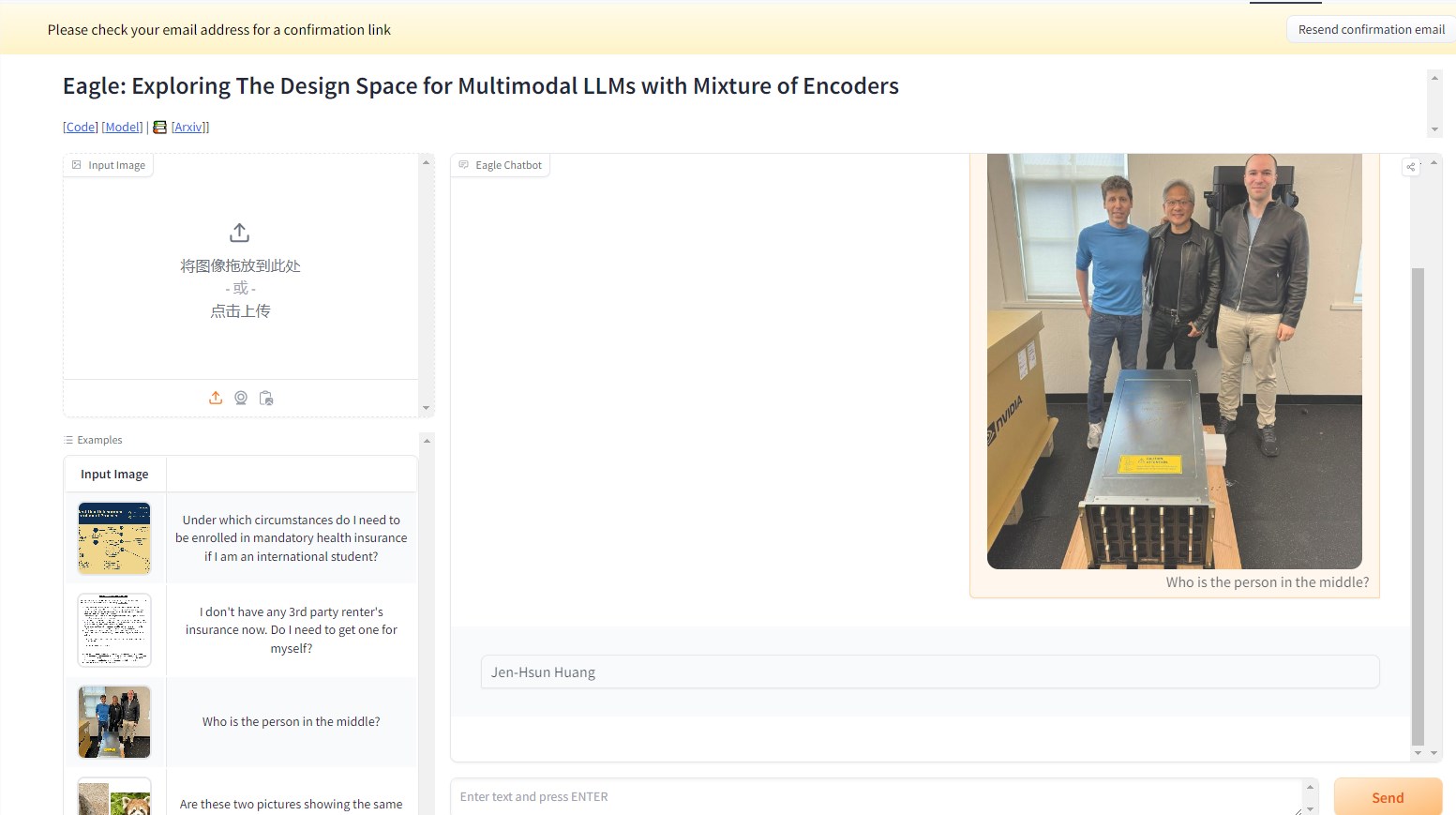

例えば、以下の例では、NVEagleモデルに画像の人物が誰なのか尋ねると、モデルは画像を解釈し、「黄仁勋」と正確に答えます。

このマルチモーダル大規模言語モデル(MLLM)は、視覚情報と言語情報の融合において重要な一歩を踏み出しました。NVEagleは複雑な現実の場面を理解し、視覚入力を通じてより良い解釈と応答を行うことができます。その設計の中核は、画像を視覚トークンに変換し、テキスト埋め込みと組み合わせることで、視覚情報の理解を向上させることにあります。

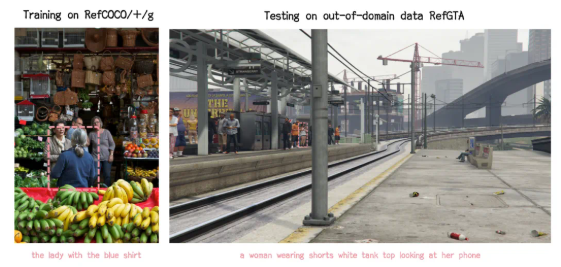

しかし、このような強力なモデルの構築には、特に視覚認識能力の向上において多くの課題があります。研究によると、多くの既存モデルは高解像度画像を処理する際に「幻覚」現象、つまり不正確または無意味な出力を生成することがあります。これは、光学文字認識(OCR)や文書理解など、詳細な分析が必要なタスクで特に顕著です。これらの困難を克服するために、研究チームはさまざまな方法を探求し、異なるビジュアルエンコーダーや融合戦略をテストしました。

NVEagleの発表は、この研究の成果であり、Eagle-X5-7B、Eagle-X5-13B、Eagle-X5-13B-Chatの3つのバージョンがあります。7Bと13Bのバージョンは一般的なビジョン言語タスクに使用され、13B-Chatバージョンは対話型AI用に微調整されており、視覚入力に基づいたインタラクションをより適切に行うことができます。

NVEagleの注目すべき点は、混合専門家(MoE)メカニズムを採用していることで、異なるタスクに応じて最適なビジュアルエンコーダーを動的に選択でき、複雑な視覚情報の処理能力が大幅に向上します。このモデルはHugging Faceで公開されており、研究者や開発者が簡単に使用できます。

さまざまなベンチマークテストで、Eagleモデルは非常に優れた性能を示しました。例えば、OCRタスクでは、EagleモデルはOCRBenchで平均85.9点を獲得し、InternVLやLLaVA-HRなどの他の最先端モデルを上回りました。TextVQAテストでは88.8点を獲得し、複雑な視覚的な質問応答タスクでも優れた性能を発揮し、GQAテストでは65.7点を獲得しました。さらに、追加の視覚専門家を導入することで、性能はさらに向上しました。

NVEagleシリーズモデルは、体系的な設計探索と最適化を通じて、視覚認識における多くの重要な課題を解決し、ビジョン言語モデルの発展に新たな地平を開きました。

プロジェクト入口:https://top.aibase.com/tool/eagle

デモ:https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

要点:

🌟 NVEagleは、NVIDIAが発表した次世代ビジョン言語モデルであり、複雑な視覚情報の理解力を向上させることを目的としています。

📈 このモデルには3つのバージョンがあり、それぞれ異なるタスクに適しており、13B-Chatバージョンは対話型AIに特化しています。

🏆 複数のベンチマークテストで、Eagleモデルは多くの既存の最先端モデルを上回る性能を示し、卓越した能力を備えていることが示されました。