智源研究院は、Infinity-Instructという数千万件の命令微調整データセットをリリースしました。これは、対話などにおける言語モデルの性能向上を目指したものです。最近、Infinity InstructはInfinity-Instruct-7M基本命令データセットとInfinity-Instruct-Gen対話命令データセットを含む、新たなアップデートを行いました。

Infinity-Instruct-7M基本命令データセットは744万件以上のデータを含み、数学、コード、常識的な質問応答など多様な分野を網羅しており、事前学習モデルの基本能力向上を目指しています。テスト結果によると、このデータセットで微調整されたLlama3.1-70BとMistral-7B-v0.1モデルは、総合的な能力において公式にリリースされている対話モデルに匹敵する性能を示しました。特にMistral-7BはGPT-3.5を上回り、Llama3.1-70BはGPT-4に迫る性能です。

Infinity-Instruct-Gen対話命令データセットは、149万件の人工的に生成された複雑な命令を含み、現実的な対話シーンにおけるモデルの堅牢性の向上を目指しています。このデータセットを用いてさらに微調整することで、モデルの性能は公式の対話モデルを上回ることが可能です。

智源研究院は、MTBench、AlpacaEval2、Arena-Hardなどの主要な評価ベンチマークでInfinity-Instructをテストし、Infinity-Instructで微調整されたモデルは対話能力において公式モデルを凌駕することを示しました。

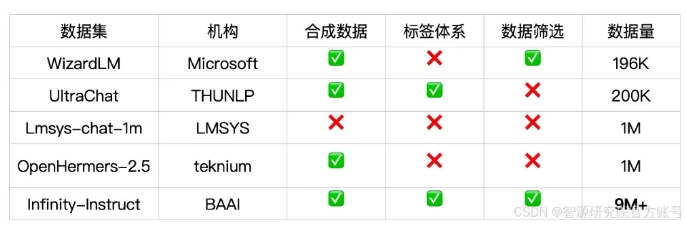

Infinity-Instructは、言語、能力の種類、タスクの種類、データソースなど、各命令データに詳細な注釈を提供しており、ユーザーは必要に応じてデータサブセットを選択できます。智源研究院は、データの選定と命令の合成を通じて高品質なデータセットを構築し、オープンソースの対話モデルとGPT-4との間のギャップを埋めることを目指しています。

本プロジェクトでは、FlagScaleトレーニングフレームワークを採用して微調整のコストを削減し、MinHashによる重複排除とBGE検索による重複サンプルの除去も行っています。智源研究院は今後、データ処理とモデルトレーニングの全プロセスコードをオープンソース化し、Infinity-Instructのデータ戦略をアライメントや事前学習段階に拡張することで、言語モデルのライフサイクル全体におけるデータニーズに対応することを計画しています。

データセットリンク:

https://modelscope.cn/datasets/BAAI/Infinity-Instruct