自然言語処理の分野では、大規模言語モデル(LLM)の進歩が著しく、多くの分野で目覚ましい成果を上げています。しかし、モデルの複雑化に伴い、その出力の正確な評価が非常に重要になっています。従来は、人間の評価に頼っていましたが、これは時間と労力を要し、スケールアップが困難で、モデルの急速な発展に追いつくことができません。

この状況を変えるため、Salesforce AI研究チームは、3つの大規模言語モデルからなる評価ファミリーであるSFR-Judgeを発表しました。これらのモデルは、それぞれ80億、120億、700億のパラメータを持ち、Meta Llama3とMistral NeMOを基に構築されています。SFR-Judgeは、ペアワイズ比較、単一スコア付け、2値分類評価など、様々な評価タスクを実行でき、研究チームが新しいモデルのパフォーマンスを迅速かつ効率的に評価するのに役立ちます。

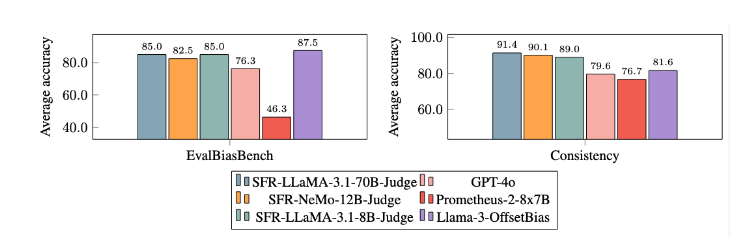

従来のLLM評価モデルは、位置バイアスや長さバイアスなど、いくつかのバイアスの問題を抱えていることが多く、これらが判断に影響を与えます。これらの問題を克服するために、SFR-Judgeは直接選好最適化(DPO)トレーニング方法を採用し、モデルが正例と負例から学習することで、評価タスクの理解能力を高め、バイアスを軽減し、判断の一貫性を確保しています。

テストでは、SFR-Judgeは13個のベンチマークテストで優れた成績を収め、いくつかのプライベートモデルを含む多くの既存の評価モデルを上回りました。特にRewardBenchランキングでは、92.7%の精度を達成し、これは生成型評価モデルが初めて90%の閾値を超えた事例であり、その優れたパフォーマンスを示しています。

SFR-Judgeのトレーニング方法は、3つの異なるデータ形式を網羅しています。まず「思考連鎖批評」は、モデルが評価応答に対する構造化された分析を生成するのに役立ちます。次に「標準判定」は、評価プロセスを簡素化し、応答が基準を満たしているかどうかを直接フィードバックします。最後に「応答推論」は、モデルが高品質な応答の特徴を理解し、判断能力を強化するのに役立ちます。これらの3つのデータ形式を組み合わせることで、SFR-Judgeの評価能力が大幅に向上しました。

多くの実験を経て、SFR-Judgeモデルは、他のモデルよりもバイアス軽減において顕著な成果を上げています。EvalBiasBenchベンチマークテストでは、高いペアワイズ順序の一貫性を示しており、応答順序が変わってもモデルの判断が安定していることを示しています。これにより、SFR-Judgeは信頼性の高い自動評価ソリューションとなり、人的注釈への依存を減らし、モデル評価によりスケーラブルな選択肢を提供します。

論文へのリンク:https://arxiv.org/abs/2409.14664

要点:

📊 高精度:SFR-Judgeは13個のベンチマークテストのうち10個で最高の成績を収め、特にRewardBenchでは92.7%の高精度を達成しました。

🛡️ バイアス軽減:このモデルは、他の評価モデルよりも低いバイアス、特に長さバイアスと位置バイアスを示しました。

🔧 多機能性:SFR-Judgeは、ペアワイズ比較、単一スコア付け、2値分類評価に対応しており、様々な評価シナリオに適応できます。