最近、Googleは「gemma-2-2b-jpn-it」という新しいモデルを発表しました。これはGemmaシリーズ言語モデルの最新版で、日本語に特化して最適化されており、Googleが大型言語モデル(LLM)分野に継続的に投資していることを示しています。

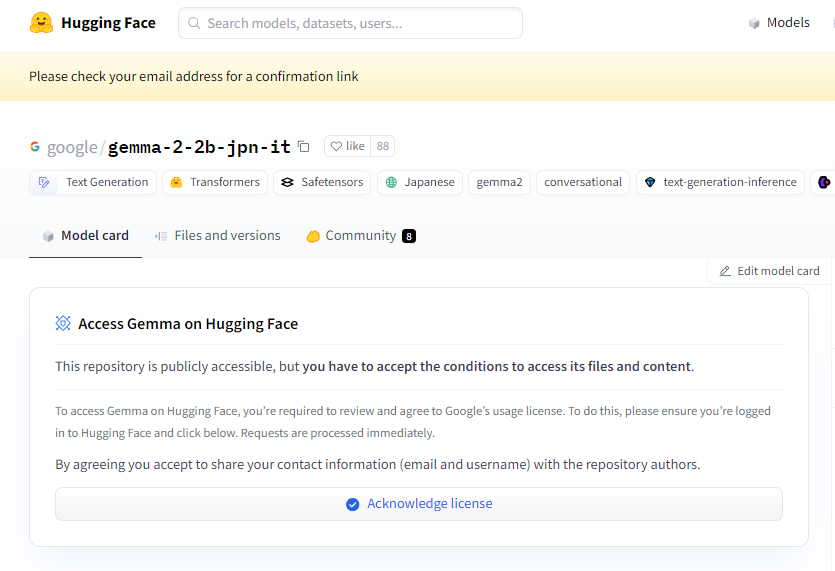

プロジェクト入口:https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-itは、テキストからテキストへのデコーダー型の大規模言語モデルで、重みが公開されているため、一般の人がアクセスして、質問応答、要約、推論など、さまざまなテキスト生成タスクに合わせて微調整できます。

この新しいモデルは26.1億個のパラメータを持ち、BF16テンソル型を使用しています。GoogleのGeminiシリーズモデルアーキテクチャに基づいて設計されており、非常に高度な技術文書とリソースが提供されているため、開発者は推論を簡単にさまざまなアプリケーションに統合できます。特筆すべきは、このモデルがGoogle最新のTPUハードウェア、特にTPUv5pと互換性があることです。このハードウェアは強力な計算能力を提供し、従来のCPUインフラストラクチャをはるかに上回る速度と性能でモデルのトレーニングを可能にします。

ソフトウェアの面では、gemma-2-2b-jpn-itはJAXとML Pathwaysフレームワークを使用してトレーニングされています。JAXは高性能機械学習アプリケーションに最適化されており、ML Pathwaysはトレーニング全体のプロセスを整理するための柔軟なプラットフォームを提供します。これにより、Googleは効率的なトレーニングワークフローを実現しています。

gemma-2-2b-jpn-itの発表により、その多様な分野への応用可能性が注目されています。このモデルは、詩、脚本、コード、マーケティングコピー、さらにはチャットボットの返信など、コンテンツ作成やコミュニケーションにおいて大きな役割を果たすことができます。そのテキスト生成能力は要約タスクにも適しており、大量のテキストを簡潔な要約に凝縮することができ、研究、教育、知識探求に非常に役立ちます。

しかし、gemma-2-2b-jpn-itにはいくつかの限界もあります。ユーザーはそれを理解する必要があります。モデルのパフォーマンスは、トレーニングデータの多様性と質に依存しており、データにバイアスや欠落があると、モデルの応答に影響を与える可能性があります。また、大規模言語モデルには知識ベースが組み込まれていないため、複雑なクエリを処理する際に、不正確または時代遅れの事実を生成する可能性があります。

開発において、Googleは倫理的な考慮事項を重視し、gemma-2-2b-jpn-itを厳格に評価して、コンテンツの安全性、表現の損害、トレーニングデータの記憶に関する問題に対処しています。Googleは有害なコンテンツを除外するためのフィルタリング技術も実装し、透明性と説明責任の枠組みを構築して、開発者が継続的に監視し、データプライバシー規制の遵守を確保するためのプライバシー保護技術を採用することを推奨しています。

重要なポイント:

🌟 Googleが発表したgemma-2-2b-jpn-itモデルは日本語向けに最適化されており、26.1億個のパラメータと高度なアーキテクチャを備えています。

💡 このモデルは、コンテンツ作成、自然言語処理などの分野で幅広い応用可能性があり、さまざまなテキスト生成タスクに対応しています。

🔒 Googleはモデル開発において倫理的な考慮事項を重視し、コンテンツの安全性を確保するためのフィルタリングとプライバシー保護対策を実施してリスクを軽減しています。