この度、アリババママクリエイティブチームは、FLUX.1-devモデルをベースに訓練された8ステップ蒸留LoraモデルであるFLUX.1-Turbo-Alphaを発表しました。

このモデルはマルチヘッド識別器を採用することで、蒸留の質を大幅に向上させ、テキストから画像の生成、修復コントロールネットなど、様々なFLUX関連アプリケーションに対応しています。チームは、使用時にはガイダンススケールを3.5、Loraスケールを1に設定することを推奨しており、今後、ステップ数の少ないバージョンもリリースする予定です。

FLUX.1-Turbo-Alphaは、Diffusersフレームワークと直接連携して使用できます。数行のコードだけでモデルを読み込み、必要な画像を生成できます。例えば、「皮ジャケット、カウボーイハット、チェック柄スカート、リボンをつけた笑顔のナマケモノが、街並みが描かれた光沢のあるフォルクスワーゲンバスの前に立っている」という面白いシーンを作成できます。パラメータを簡単に調整するだけで、1024x1024の高解像度で高品質な画像を生成できます。

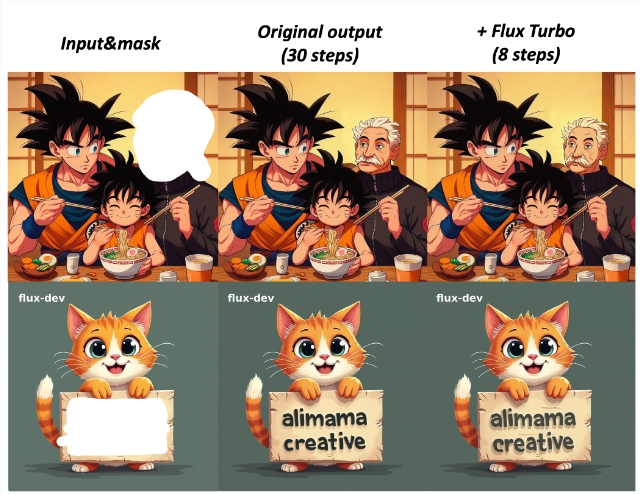

さらに、このモデルはComfyUIにも対応しており、テキストから画像への高速なワークフローに使用したり、修復コントロールネットにおいてより効率的な生成効果を実現したりできます。この技術により、生成された画像は元の出力にうまく追従し、ユーザーの創作体験を向上させます。

FLUX.1-Turbo-Alphaのトレーニングプロセスも注目に値します。このモデルは100万枚以上のオープンソースと内部リソースの画像でトレーニングされており、6.3以上の美的評価を得ており、解像度はすべて800以上です。チームはトレーニングプロセスにおいて敵対的トレーニング手法を採用し、画像の質を向上させ、各トランスフォーマー層にマルチヘッド設計を追加しました。トレーニングプロセスにおけるガイダンススケールは3.5に固定され、時間オフセットは3に設定され、混合精度bf16が使用され、学習率は2e-5、バッチサイズは64、画像サイズは1024x1024に設定されました。

FLUX.1-Turbo-Alphaの発表は、アリババママによる画像生成分野における新たなブレークスルーであり、人工知能技術の普及と応用を促進します。

プロジェクト入口:https://huggingface.co/alimama-creative/FLUX.1-Turbo-Alpha

要点:

🌟 このモデルはFLUX.1-devをベースとし、8ステップ蒸留とマルチヘッド識別器を採用することで、画像生成の質を向上させています。

🖼️ テキストから画像の生成と修復コントロールネットに対応しており、ユーザーは様々な面白いシーンを簡単に作成できます。

📊 トレーニングプロセスでは敵対的トレーニングを採用し、100万枚以上の画像でトレーニングすることで、高品質な出力を確保しています。