この度、AI動画企業Genmoは、テキストプロンプトから高品質な動画を生成できる、全く新しいオープンソースの動画生成モデル「Mochi1」を発表しました。Mochi1の性能は、Runway、Luma AIのDream Machine、快手の可灵、MinimaxのHailuoなど、市場をリードする閉鎖型競合製品に匹敵、あるいはそれ以上と評価されています。

このモデルはApache2.0ライセンスの下で公開されており、ユーザーは最先端の動画生成技術を無料で利用できます。一方、競合製品は、無料プランが限定的であったり、月額94.99ドルもの高額な料金がかかるものもあります。

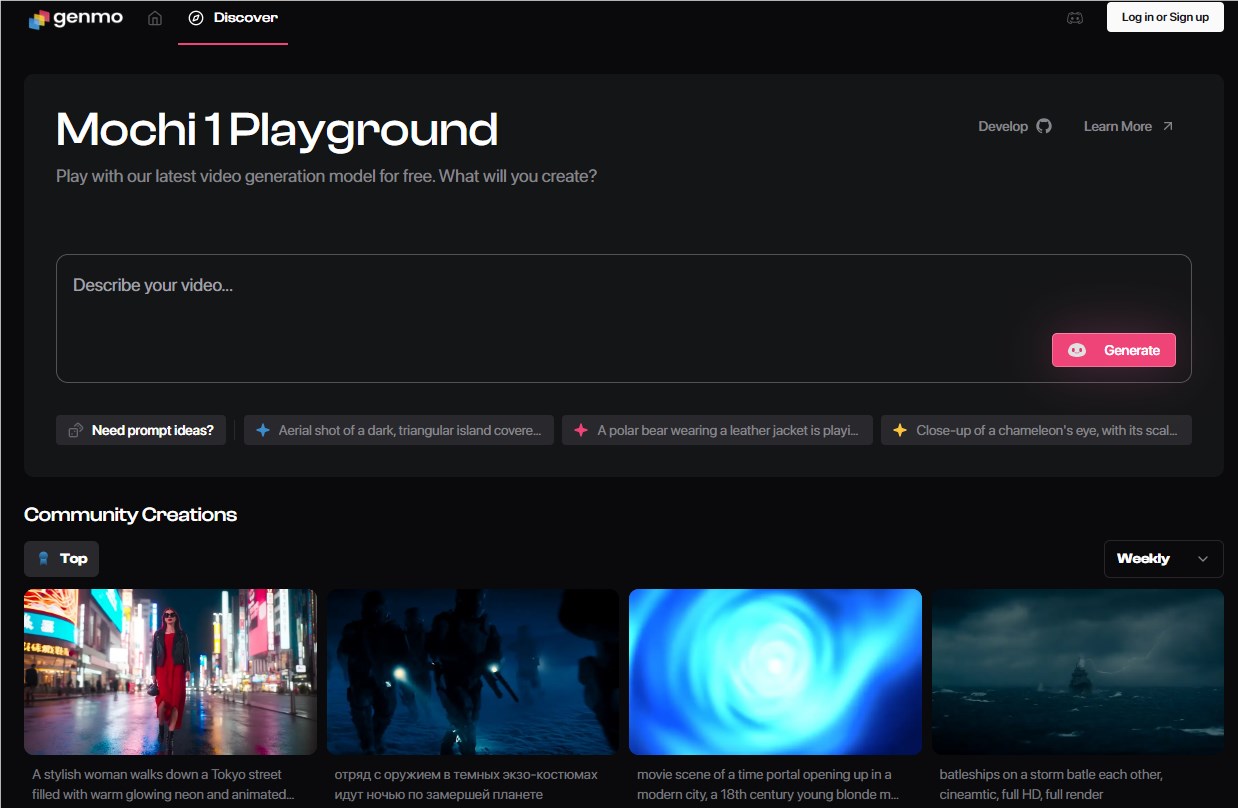

ユーザーはHugging FaceからMochi1のモデルウェイトとコードを無料でダウンロードできます。ただし、個人デバイスでこのモデルを実行するには、少なくとも4枚のNvidia H100 GPUが必要です。Genmoは、ユーザーがMochi1の機能を体験できるように、オンライン試用プラットフォームも提供しています。

Mochi1で生成された動画の例:

Genmoによると、Mochi1は詳細なユーザー指示に従うことに優れており、生成される動画のキャラクター、設定、アクションを正確に制御できます。Genmoは内部テストで、Mochi1は、迅速な粘着性とモーションの質において、RunwayやLunaなどの独自の競合製品を含む、他のほとんどの動画AIモデルを上回ったと主張しています。

Mochi1は、高忠実度のモーション表現と正確なプロンプトへの準拠能力など、動画生成分野で顕著な進歩を遂げています。GenmoのCEOであるParas Jain氏は、オープンソースと閉鎖型の動画生成モデルのギャップを縮小することを目指していると述べています。彼は、動画が最も重要なコミュニケーション手段であるため、この技術をより多くの人々に広めたいと強調しました。

同時に、Genmoは2840万ドルのシリーズAラウンドの資金調達を完了したことも発表しました。投資家にはNEAと複数のベンチャーキャピタルが含まれています。Jain氏は、動画生成はエンターテインメントやコンテンツ作成だけでなく、将来のロボットや自律システムにとって重要なツールになると指摘しました。

Mochi1のアーキテクチャは、Genmo独自の非対称拡散トランスフォーマー(AsymmDiT)に基づいており、これまでに公開された中で最大のオープンソース動画生成モデルであり、パラメーター数は100億にも及びます。このモデルは視覚推論に重点を置いており、動画データの処理においてより優れています。

Mochi1で生成された動画の例:

Mochi1は強力な機能を示していますが、現在、解像度が480pに限定されていることや、複雑な動きのあるシーンでわずかな視覚的な歪みが発生する可能性があるなど、いくつかの制限があります。Genmoは、ユーザーエクスペリエンスを向上させるため、年内に720p解像度をサポートするMochi1HDバージョンをリリースする予定です。

試用版はこちら:https://www.genmo.ai/play

モデルダウンロード:https://huggingface.co/genmo/mochi-1-preview

要点:

🌟 Mochi1はGenmoが発表したオープンソースの動画生成モデルで、無料で使用でき、性能は多くの閉鎖型製品に匹敵します。

💰 Genmoは2840万ドルのシリーズAラウンドの資金調達を行い、AI動画技術の民主化を目指しています。

🎥 今後、現在の480pの解像度と複雑な動きのあるシーンにおけるいくつかの制限を解消するMochi1HDバージョンをリリース予定です。