「画像を見て話す」神器として知られるGPT-4Vを覚えていますか?画像は理解できるし、画像に基づいてタスクを実行することもできます。まさに怠け者の福音です!しかし、致命的な弱点があります。視力が悪いのです!

GPT-4Vにボタンを押してもらおうとすると、「画面盲」のようにあちこち押しまくり、イライラする場面を想像してみてください。

そこで今回は、GPT-4Vの視力を向上させる神器、OmniParser!をご紹介します。これはマイクロソフトが発表した新しいモデルで、グラフィカルユーザーインターフェース(GUI)の自動操作における課題解決を目指しています。

OmniParserとは何をするもの?

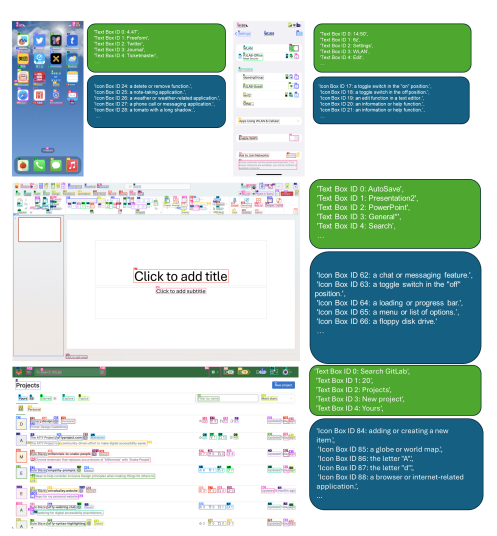

簡単に言うと、OmniParserは「画面翻訳官」です。スクリーンショットをGPT-4Vが理解できる「構造化された言語」に変換します。OmniParserは、微調整されたインタラクティブアイコン検出モデル、微調整されたアイコン記述モデル、OCRモジュールの出力を組み合わせています。

この組み合わせにより、UIの構造化されたDOMに似た表現と、潜在的にインタラクティブな要素の境界ボックスを覆うスクリーンショットが生成されます。研究者たちはまず、一般的なウェブページとアイコン記述データセットを使用して、インタラクティブアイコン検出データセットを作成しました。これらのデータセットは、専用のモデルの微調整に使用されました。1つは画面上のインタラクティブな領域を解析するための検出モデル、もう1つは検出された要素の機能的な意味を抽出するための記述モデルです。

具体的には、OmniParserは以下のことを行います。

画面上のすべてのインタラクティブなアイコンとボタンを識別し、枠で囲み、各枠に一意のIDを割り当てます。

各アイコンの機能をテキストで記述します(例:「設定」、「最小化」)。画面上のテキストを識別して抽出します。

これにより、GPT-4Vは画面上に何が表示されているか、それぞれの要素は何をするものか、どのボタンを押したいのかを明確に理解できるようになります。ボタンを押したい場合は、IDを伝えるだけで済みます。

OmniParserの性能は?

研究者たちは様々なテストでOmniParserを試しましたが、GPT-4Vの「視力」を向上させることが実証されました!

ScreenSpotテストでは、OmniParserによってGPT-4Vの精度が大幅に向上し、グラフィカルインターフェース向けに特化して訓練されたモデルの一部を上回りました。例えば、ScreenSpotデータセットでは、OmniParserの精度は73%向上し、低レベルのHTML解析に依存するモデルを上回りました。注目すべきは、UI要素の局所的な意味論が予測精度の顕著な向上につながったことです。OmniParserの出力を用いた場合、GPT-4Vによるアイコンの正しいラベル付けは70.5%から93.8%に向上しました。

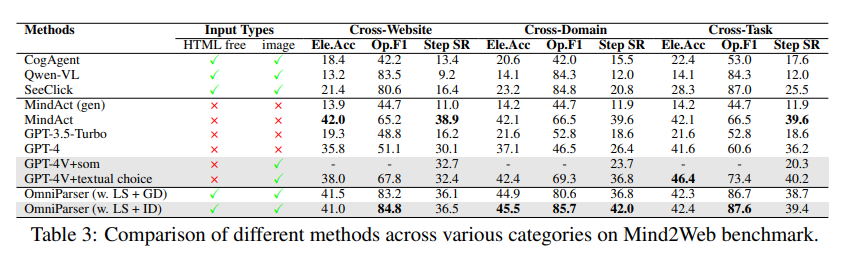

Mind2Webテストでは、OmniParserによってGPT-4Vのウェブブラウジングタスクにおけるパフォーマンスが向上し、HTML情報を利用したGPT-4Vを上回る精度を達成しました。

AITWテストでは、OmniParserによってGPT-4Vのモバイルナビゲーションタスクにおけるパフォーマンスも著しく向上しました。

OmniParserの課題は?

OmniParserは非常に強力ですが、いくつかの欠点もあります。

同じアイコンやテキストがあると混乱しやすいため、より詳細な説明が必要です。

枠の精度が低い場合があり、GPT-4Vが間違った場所をクリックすることがあります。

アイコンの解釈が間違っている場合があり、文脈を考慮してより正確に記述する必要があります。

しかし、研究者たちはOmniParserの改善に取り組んでおり、ますます強力になり、最終的にはGPT-4Vにとって最高の相棒になるでしょう!

モデル体験:https://huggingface.co/microsoft/OmniParser

論文入口:https://arxiv.org/pdf/2408.00203

公式紹介:https://www.microsoft.com/en-us/research/articles/omniparser-for-pure-vision-based-gui-agent/

要点:

✨OmniParserは、GPT-4Vが画面の内容をより良く理解し、より正確にタスクを実行するのに役立ちます。

🔍OmniParserは様々なテストで優れた性能を示し、その有効性を証明しました。

🛠️OmniParserにはまだ改善の余地がありますが、将来性が期待できます。