先日、研究チームはHelloMemeというフレームワークを発表しました。これは、画像内の人物の表情を別の画像の人物に超高精度で移植できるフレームワークです。

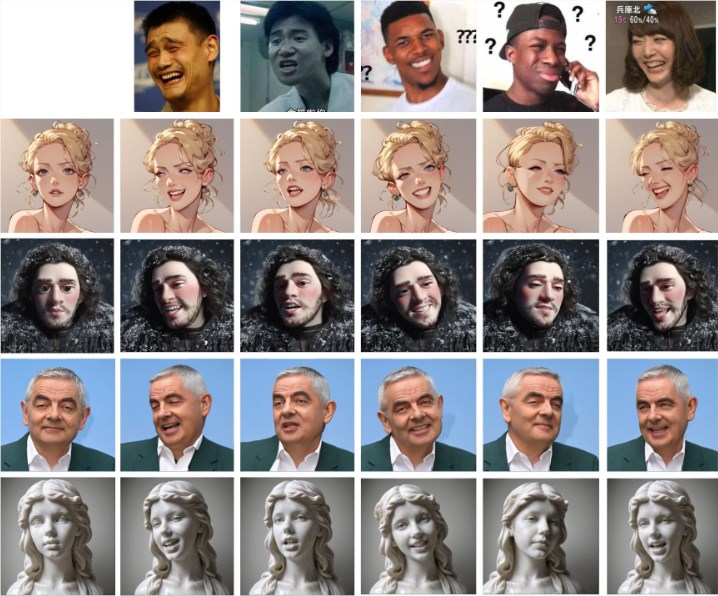

下図のように、表情画像(一行目)を与えると、その表情のディテールを他の画像の人物に移植できます。

HelloMemeの中核は、その独自のネットワーク構造にあります。このフレームワークは、運転動画から各フレームの特徴を抽出し、それらをHMControlModuleに入力します。これにより、研究者たちは滑らかな動画を生成できます。しかし、初期生成の動画では、フレーム間にちらつきがあり、視聴体験に影響を与えていました。この問題を解決するために、チームはAnimatediffモジュールを導入しました。この革新的なモジュールは動画の連続性を大幅に向上させましたが、画質をある程度低下させるというトレードオフがありました。

この矛盾に対処するため、研究チームはAnimatediffモジュールをさらに最適化し、最終的に動画の連続性を向上させながら高画質を維持することに成功しました。

さらに、HelloMemeフレームワークは、顔表情編集を強力にサポートします。ARKit Face Blendshapesと連携することで、ユーザーは生成された動画内のキャラクターの顔表情を簡単に制御できます。この柔軟性により、制作者は必要に応じて特定の感情や表現を持つ動画を生成でき、動画コンテンツ表現力の幅が大きく広がります。

技術互換性において、HelloMemeはSD1.5ベースのホットスワップアダプター設計を採用しています。この設計の最大の利点は、T2I(テキストから画像)モデルの汎化能力に影響を与えず、SD1.5ベースで開発されたあらゆるスタイル化モデルとHelloMemeをシームレスに統合できることです。これは、様々な創作の可能性を広げます。

研究チームは、HMReferenceModuleの導入により、動画生成時の忠実度が大幅に向上したことを発見しました。これは、高品質な動画を生成しながら、サンプリングステップを削減できることを意味します。この発見は、生成効率の向上だけでなく、リアルタイム動画生成への扉を開くものです。

他の手法との比較結果は下記の通りです。HelloMemeの表情移植効果は、より自然で元の表情に近いことが明らかです。

プロジェクト入口:https://songkey.github.io/hellomeme/

https://github.com/HelloVision/ComfyUI_HelloMeme

要点:

🌐 HelloMemeは独自のネットワーク構造とAnimatediffモジュールにより、動画生成の滑らかさと画質の両方を向上させています。

🎭 このフレームワークはARKit Face Blendshapesをサポートしており、ユーザーはキャラクターの顔表情を柔軟に制御し、動画コンテンツ表現力を豊かにすることができます。

⚙️ ホットスワップアダプター設計を採用することで、SD1.5ベースの他のモデルとの互換性を確保し、創作の柔軟性を高めています。