最新の研究によると、生成AIモデル、特に大規模言語モデル(LLM)を利用することで、様々な状況下で人間の行動を正確にシミュレートできるアーキテクチャを構築できることが示されました。この研究成果は、社会科学研究にとって強力な新たなツールとなります。

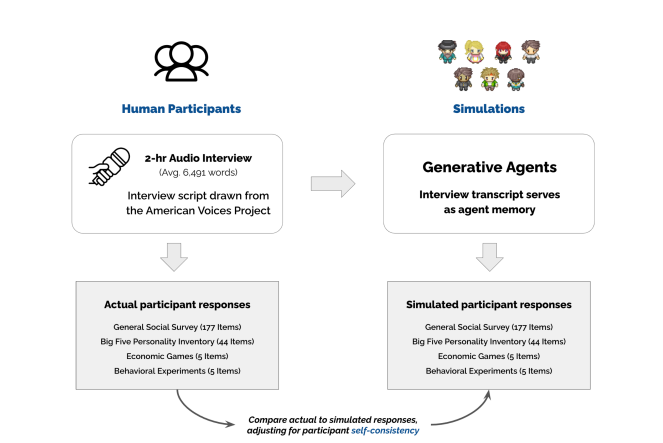

研究者らはまず、アメリカ合衆国各地の多様な背景を持つ1000名以上の参加者を募集し、2時間にわたる詳細なインタビューを実施しました。彼らの生活経験、意見、価値観などの情報を収集しました。その後、これらのインタビュー記録と大規模言語モデルを用いて「生成型エージェントアーキテクチャ」を構築しました。

このアーキテクチャは、参加者のインタビュー内容に基づいて、数千もの仮想的な「クローン」を作成できます。それぞれの「クローン」は、独自の個性と行動パターンを持っています。「ビッグファイブ」人格テストや行動経済学ゲームなどの標準的な社会科学テストを通じて、これらの「クローン」の行動を評価しました。

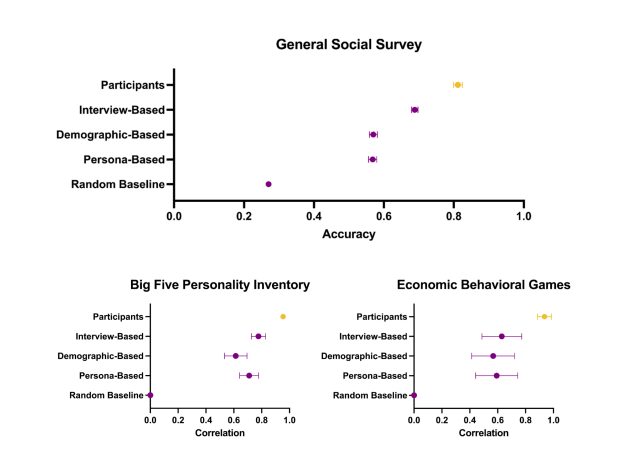

驚くべきことに、これらの「クローン」はテストにおけるパフォーマンスが実際の参加者と非常に一致しました。アンケートへの回答を正確に予測できるだけでなく、実験における行動反応も予測できました。例えば、権力が信頼に及ぼす影響に関する実験では、「クローン」は実際の参加者と同様に、高権力グループの信頼度が低権力グループよりも明らかに低いという結果を示しました。

この研究成果は、生成AIモデルを用いて非常にリアルな「仮想人間」を作成し、実際の人の行動を予測できることを示しています。これは、社会科学研究に全く新しい手法を提供します。例えば、大規模な実証実験を行うことなく、これらの「仮想人間」を利用して、新しい公衆衛生政策やマーケティング戦略の効果をテストできます。

研究者らはまた、「仮想人間」を構築する際に、人口統計情報だけでは不十分であり、詳細なインタビュー内容を組み合わせることで、個人の行動をより正確にシミュレートできることを発見しました。これは、個々人が独自の経験と意見を持っており、これらの情報が彼らの行動を理解し予測するために非常に重要であることを示しています。

参加者のプライバシー保護のため、研究者らは「エージェントライブラリ」を構築し、2つの方法でアクセス権を提供する予定です。1つは、特定タスクの集約データへのオープンアクセス、もう1つは、特定タスクの個人データへの制限付きアクセスです。これにより、研究者はこれらの「仮想人間」を容易に使用でき、インタビュー内容に関するリスクを最小限に抑えることができます。

この研究成果は、社会科学研究に新たな扉を開くことは間違いありません。今後どのような大きな影響をもたらすのか、注目しましょう。

論文アドレス:https://arxiv.org/pdf/2411.10109